O Google Tag Managerze zwykle pisze się w pozytywnym kontekście… ale nie tym razem. Dzisiaj chcę Wam pokazać, że nawet tak niepozorny element jak stary tag z GTM jest w stanie negatywnie wpłynąć na działania SEO i wypracowane pozycje fraz kluczowych. Co się stało i na co warto zwracać uwagę? Już tłumaczę.

Spis treści:

Zobacz też:

SEO sypie się przez GTM – czy to w ogóle możliwe?

Jest to krótka historia na zasadzie „nie powtarzajcie mojego błędu”.

Ten przypadek potwierdza, że nawet jeden drobny szczegół – mały element, który pozostawiliśmy bez nadzoru i po nim nie posprzątaliśmy – może wrócić do nas po jakimś czasie, ale niekoniecznie tak, jakbyśmy tego chcieli.

Coś, czego byście się nie spodziewali po zwykłym tagu wdrożonym już dawno w GTM, który powinien po prostu sobie wisieć i nie działać – a tymczasem narobił dużo bałaganu.

Nie zamierzam tutaj nikogo straszyć, ani tym bardziej zrazić do używania Google Tag Managera :D. To świetne narzędzie i chcę, żeby to głośno wybrzmiało.

Co nie zmienia faktu, że nie jest totalnie bezobsługowe i nieszkodliwe – o czym zaraz się przekonacie.

Opis strony

Niestety domeny wam podać nie mogę, taką mamy umowę z tym klientem. Ale mogę za to krótko opisać charakterystykę serwisu – a konkretnie sklepu, bo jest to dość duży e-commerce.

Branża: to tak naprawdę nie ma znaczenia, bo nie chodzi o działania konkurencji, tylko o błędy wewnętrzne, które zależą wyłącznie od nas.

Wielkość serwisu: zaindeksowanych podstron jest ponad 20 tysięcy, więc sami widzicie, że nie jest to mały sklep.

Postawiony jest na Magento i – co akurat jest istotne – korzysta z technologii PWA (Progressive Web Application), czyli strona internetowa działa trochę jak aplikacja mobilna. Można zainstalować ją na smartfonie i używać, jakby była kolejną apką.

Ważne w kontekście całej historii jest też to, że sklep mocno korzysta z JavaScript i to głównie na tym języku programowania jest oparty.

Ma on swoich zwolenników i przeciwników – warto pamiętać, że nie do końca sprawny serwis generowany przy pomocy JS’a może powodować trudności z indeksowaniem. W tym przypadku właśnie z takimi problemami mieliśmy do czynienia.

Pierwsze objawy, że coś jest nie tak

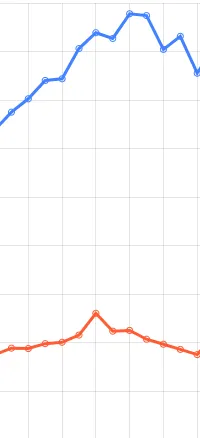

Wszystko zaczęło się od komunikatu, że na stronie naszego klienta są rejestrowane spadki widoczności.

Początkowo powiadomienia nie wyglądały zbyt groźnie – kilkaset fraz na minusie przy widoczności 30k+ to nie jest jakiś duży problem.

Chyba że takich komunikatów dostajesz kilka w ciągu 10 dni. Wtedy robi się już niewesoło, bo wykres zaczyna przypominać równię pochyłą.

A takich sytuacji raczej nikt nie chce widzieć. Ani specjalista od pozycjonowania, ani tym bardziej klient.

Co do tej pory wiedziałem na pewno? Serwis działa, nic nie było usuwane i nie pojawiały się żadne błędy w działaniu strony.

Na tym etapie zastanawiałem się, o co może chodzić – i zaczynałem podejrzewać, że znalezienie odpowiedzi nie będzie takie łatwe.

Pierwsza lampka: w świecie SEO pojawił się news, że IP robotów Google są częściej aktualizowane. Może mamy coś poblokowane? Może coś się ostatnio zmieniło?

Szybki e-mail podbity telefonem, informacja priorytetowo przekazana do programistów, ale okazało się, że wszystko jest okej. Fałszywy alarm.

A może to tylko chwilowe wyczyszczenie fraz kluczowych? Wiecie, każdy jest świadomy, że ciężko cały czas rosnąć i czasem musi być jakieś wyrównanie. Jednak spadki były zbyt gwałtowne i trwało to już za długo.

Nurkowanie głębiej i szukanie przyczyny

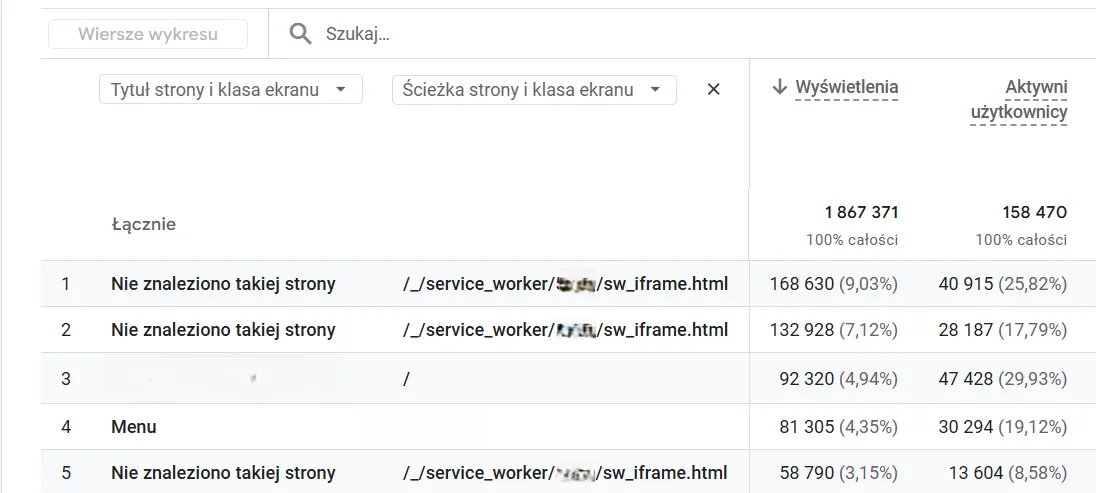

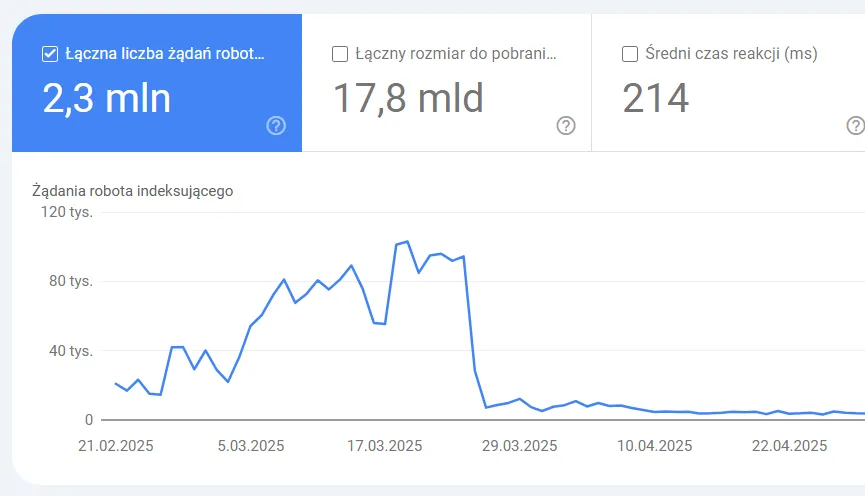

Nie znalazłem niczego wewnątrz strony, musiałem więc wejść głębiej do Google Search Console i statystyk indeksowania. Tam od razu zwróciłem uwagę na większą niż zwykle liczbę żądań indeksowania przez roboty Google.

Czy to dobrze, że roboty częściej odwiedzają serwis? W większości przypadków tak, bo dzięki temu zmiany na stronie są szybciej zauważane, a nowe podstrony mogą być sprawnie indeksowane.

W tym przypadku chodziło jednak o żądania dotyczące błędów 404, co już nie napawa takim optymizmem. A mówimy tu o wzroście z kilkuset czy kilku tysięcy do 80 000, a potem do nawet 150 000 żądań.

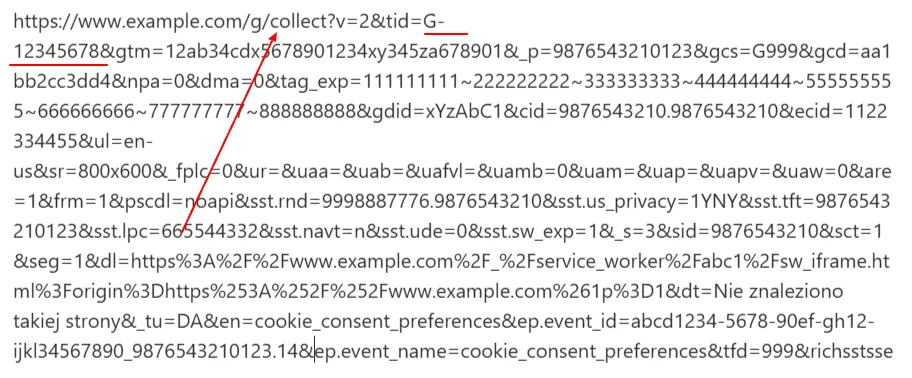

Na liście przykładowych adresów z odpowiedzią 404 najczęściej pojawiały się takie kwiatki:

Co tutaj widzimy?

Przede wszystkim jest element g/collect/ (oznaczony strzałką), który wskazuje nam na Google Analytics 4.

Mamy też identyfikator G-12345678 mówiący o tym, jakie konto GA jest do tego przypisane (podkreślony).

Jest jeszcze informacja o GTMie, identyfikatorze użytkownika, ciasteczkach, eventach, źródłowym adresie strony, tytule strony, service_worker czy ID sesji.

No jest tego po prostu dużo, ale już nakierowuje na jakieś problemy z Analyticsem i zbieraniem danych.

Po zajrzeniu do GA4 okazało się, że wpływa to też na dane zbierane w tym narzędziu, a adresy w takiej postaci pojawiają się codziennie.

Problem znaleziony – czas go naprawić

Po poszukiwaniach związanych z service_worker i JavaScriptem, odpalaniem się skryptów i consent mode, ciasteczkami oraz eventami okazało się, że jest jedna rzecz, która się nie zgadza.

Wspomniany w tym tasiemcu identyfikator GA4 nie pokrywał się z tym aktualnym. W Google Tag Managerze udało mi się zlokalizować dwa tagi, w których użyty był błędny identyfikator usługi.

To ID było prawdopodobnie pozostałością po wcześniej używanej usłudze i ktoś po prostu zapomniał wyłączyć te tagi.

Usunięcie ich praktycznie od razu zmniejszyło liczbę wyświetleń wskazanych wyżej adresów w GA4 oraz liczbę żądań indeksowania URL-i z odpowiedzią 404.

Efekty działań

Po kilku dniach zaczęły również wracać pozycje poszczególnych fraz oraz widoczność serwisu.

W ciągu pierwszego miesiąca pozycja nie odbudowała się w pełni, ale jak widać, potem „kliknęło” i odnotowaliśmy już pełny wzrost, który trwa do dzisiaj – i oby utrzymywał się jak najdłużej.

Większość fraz kluczowych, które zaliczyły wtedy spadki, zaczęła wracać na swoje miejsce, a nawet więcej – ich pozycje urosły w porównaniu z okresem przed tą całą sytuacją.

Mówiąc krótko, naprawa tych błędów pozwoliła odblokować potencjał sklepu klienta.

Wnioski

Ta historia nauczyła mnie (a może bardziej – utwierdziła w przekonaniu), że zawsze warto trzymać porządek i pozbywać się zbędnych elementów.

Bardzo pomogła mi tutaj dociekliwość i sprawdzanie każdego potencjalnego tropu. Rozwiązanie nie było podane na tacy i musiałem się do niego dokopać – w SEO to się zdarza.

Czasami jeden problem, choć może wydawać się błahy, jest w stanie wpłynąć na całą witrynę, a co za tym idzie – również na poszczególne frazy kluczowe i ogólną widoczność.

Pozycjonowanie to precyzyjna, techniczna zabawa i po prostu zawsze trzeba mieć oczy dookoła głowy.

Podsumowanie w punktach

- Stary tag GTM przypisany do strony naszego klienta – czyli z pozoru zupełnie niegroźny element – zapewnił nam dawkę „mocnych” wrażeń i problemy ze spadkami pozycji.

- Ten konkretny przypadek dotyczył dużego sklepu internetowego działającego w technologii PWA i korzystającego z JavaScriptu, co miało wpływ na problemy z indeksacją.

- Spadki pozycji fraz kluczowych pojawiły się nagle i narastały, mimo że strona działała poprawnie i nie odnotowaliśmy żadnych widocznych błędów.

- Analiza Google Search Console ujawniła duży wzrost błędów 404 powiązanych z nietypowymi adresami URL, które zawierały dane z GA4, informacje o adresie źródłowym strony, tytule, eventach, ciasteczkach i inne elementy.

- Źródłem problemu okazały się dwa nieaktualne tagi GA4 w GTM, które generowały błędne żądania.

- Po usunięciu tych tagów pozycje fraz i widoczność strony zaczęły stopniowo wracać do normy, z czasem osiągając jeszcze lepsze wyniki niż wcześniej.

- Ten przypadek udowodnił mi, że warto zachowywać porządek w GTM, bo nawet takie drobne błędy techniczne mogą wpłynąć na wyniki SEO.