Pozycja strony internetowej w wynikach wyszukiwania zależy od tego, jak widzi ją wyszukiwarka. Ocenia ona serwisy na podstawie ich zawartości, ale to jak Google widzi stronę znacznie różni się od tego, co widzi użytkownik. Różnica ta pozwala lepiej zrozumieć na czym dokładnie polega pozycjonowanie.

W tej części Akademii SEO dowiesz się, jakie niewidoczne elementy strony widzi Google i jakie jest ich znaczenie. Wyjaśnimy też w skrócie, czym tak właściwie są roboty internetowe, co mają wspólnego z wyszukiwarką i jak działają.

Spis treści:

- Dlaczego warto spojrzeć na stronę z perspektywy Google?

- Czym jest robot internetowy?

- Jak działają roboty Google?

- Jak robot Google trafia na Twoją stronę?

- Dwa oblicza strony internetowej – z czego wynika ta różnica?

- Co widzi Google?

- Podsumowanie

Dlaczego warto spojrzeć na stronę z perspektywy Google?

Jeśli chcemy prowadzić skuteczne SEO, musimy zastanowić się nad tym, jak Google widzi moją stronę. Takie spojrzenie z perspektywy wyszukiwarki pozwoli nam zrozumieć, na co trzeba zwrócić uwagę. Zadbamy dzięki niemu o elementy niewidoczne na stronie, które wpływają na jej pozycję.

Takie „wejście w skórę” Google pozwoli nam też wyłapać dość częste błędy, istotne pod względem SEO.

Chodzi o to, że praca nad stroną internetową może z czasem pozbawić nas obiektywnego spojrzenia. Im więcej czasu nad czymś spędzamy, tym bardziej jest to dla nas oczywiste. Jeśli nie chcemy więc, by nasz wysiłek włożony w SEO poszedł na marne, musimy co jakiś czas rzucić na witrynę nieco inne światło.

Podstawowym sposobem na to jest audyt SEO – to w nim przeglądamy po kolei wszystkie istotne elementy.

Czym jest robot internetowy?

Oprogramowanie nazywane potocznie robotem internetowym to algorytm regularnie przeglądający strony internetowe w określonym celu.

Nie tylko Google ma swoje boty. Szacuje się, że wszystkie roboty sieciowe odpowiadają za niemal połowę całego ruchu w Internecie. Wiedza o ich działaniu i przeznaczeniu jest więc niezbędna do prawidłowego pozycjonowania stron.

Wśród wszystkich poruszających się po sieci algorytmów można wyróżnić między innymi roboty monitorujące działanie witryn i ich pozycję w wyszukiwarce oraz roboty zbierające newsy do wyświetlania w aplikacjach mobilnych.

Istnieją też boty odpowiedzialne za wyłapywanie duplikatów treści w obrębie poszczególnych serwisów i boty indeksujące wyszukiwarek. Pod kątem SEO to właśnie te indeksujące są dla nas najistotniejsze.

Szczegółowo o robotach internetowych piszemy w jednej z kolejnych części naszego kursu SEO – link znajdziesz nad spisem treści.

Jak działają roboty Google?

Roboty Google to nic innego jak algorytmy indeksujące. Zostały one stworzone do systematycznego zaglądania na wszystkie istniejące witryny internetowe i odnajdywania tych nowopowstałych. Skanują one strony w celu zebrania szeregu informacji na ich temat. Informacje te przekazywane są później do bazy danych i to na ich podstawie układa się wyniki wyszukiwania.

O tym, jaką pozycję zajmuje konkretna strona internetowa na daną frazę kluczową Google decyduje na podstawie własnej, tworzonej z pomocą algorytmów, bazy danych. To dlatego tak ważne jest zadbanie o to, by robot indeksujący mógł prawidłowo "zrozumieć" Twoją stronę.

Roboty Google mają za zadanie indeksowanie stron internetowych, czyli zbieranie informacji o witrynach i przekazywanie ich do bazy danych. To właśnie na podstawie tej bazy (indeksu) algorytmy dobierają później wyniki wyszukiwania stające się odpowiedziami na zapytania użytkowników.

Jeśli chcesz więc pozyskać ruch z wyszukiwarki, musisz zadbać najpierw o indeksację. To dzięki niej Twoja strona będzie mogła zostać uwzględniona w dobieraniu wyników. Jeśli witryna nie zostanie zindeksowana, to wyszukiwarka nie będzie mogła "zareagować" na żadne działania związane z SEO. Po prostu nie będzie ich widzieć.

Indeksacji podlega cała witryna, ale każda jej podstrona musi zostać dodana do indeksu osobno. Szczegółowo omawiamy ten proces w następnej lekcji. Jak zaindeksować stronę w Google dowiesz się w kolejnej lekcji SEO Samodzielnych.

Strona bez SEO jest jak yeti.

Nikt jej nie widział.

Jak robot Google trafia na Twoją stronę?

Dokładny sposób poruszania się algorytmów wyszukiwarki w sieci nie jest znany. Jedyne, czego można być pewnym, to to, że roboty odwiedzają strony wystarczająco często, by na bieżąco aktualizować wyniki wyszukiwania. Istnieje wiele teorii dotyczących poruszania się algorytmów, proces ten jest jednak ciągle udoskonalany i zmieniany.

Wiadomo natomiast, że Googleboty poruszają się m.in. za pomocą linków. Robot odwiedzający zindeksowaną już witrynę skanuje jej zawartość i odsyła zebrane informacje do indeksu. Jeśli w trakcie zbierania informacji trafi na odnośnik, podąża za nim i wykonuje całą sekwencję ponownie. W ten sposób może on poruszać się z podstrony na podstronę lub pomiędzy różnymi witrynami.

Robot może też jednak odwiedzać podstrony na podstawie zgłoszonych do Google adresów lub całych map witryn. Poprzez skanowanie serwerów może także trafić na strony niezgłoszone, nawet jeśli nie prowadzą do nich żadne linki.

Dwa oblicza strony internetowej – z czego wynika ta różnica?

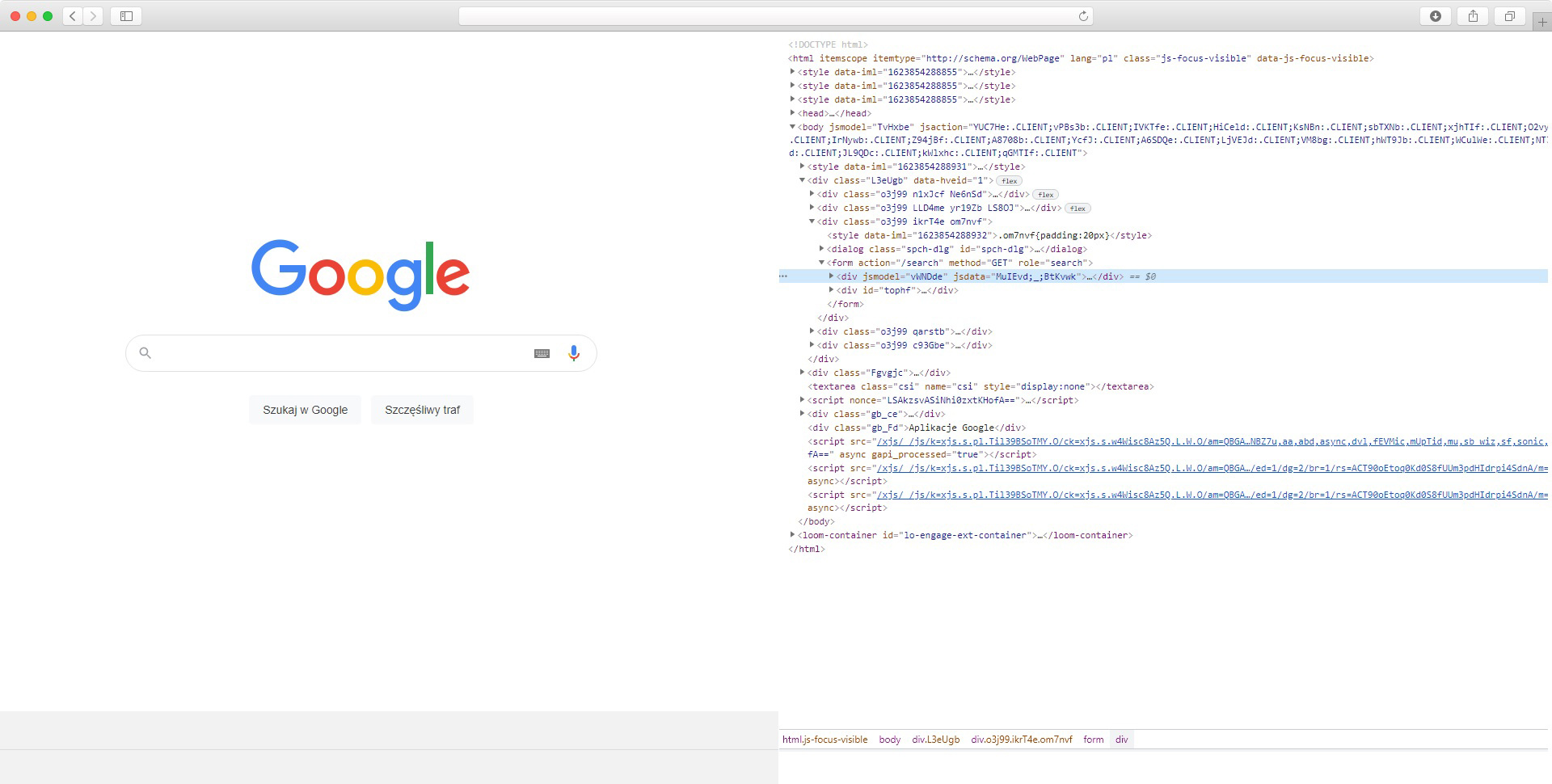

Użytkownik wchodzący na stronę internetową widzi nie tylko sam tekst, ale też jego układ, zastosowaną czcionkę, jej rozmiar i kolor. Widzi też wszelkie grafiki i zdjęcia, nie widzi natomiast kodu źródłowego.

Spora część elementów widocznych dla użytkownika nie ma większego wpływu na pozycję strony. Warstwa wizualna witryny jest ważna ze względu na wygodę, intuicyjność, odczucia i w efekcie zaufanie przeglądającego. Pod względem dobierania wyników nie ma ona jednak (prawie) żadnego znaczenia.

Zapamiętaj

Dla wyszukiwarek liczą się przede wszystkim treść i kod źródłowy. To dzięki nim roboty indeksujące mogą zrozumieć zawartość i przeznaczenie danej strony.

To właśnie na tym, co zostało zawarte na danej stronie, skupia się odwiedzający ją robot Google. Przede wszystkim widzi on witrynę w wersji nieprzetworzonej przez przeglądarkę, czyli tak, jak została ona napisana (stworzona). System rankingowy nie może zobaczyć efektu, a jedynie źródło strony, na podstawie którego efekt ten może zostać wygenerowany.

I to właśnie z takiej „surowej” wersji może on odczytywać poszczególne elementy, czyli m.in. treść, zamieszczone w niej linki czy nagłówki zawarte w znacznikach H1-H6. Robot indeksujący ma też jednak dostęp do czynników w dużej mierze niewidocznych dla osoby przeglądającej stronę, takich jak choćby meta tagi.

Odczytywanie tych wszystkich niewidocznych elementów pomaga w prawidłowej indeksacji, a co za tym idzie, może mieć też wpływ na SEO.

Co widzi Google?

Robot Indeksujący, czyli inaczej Web Crawler, nie jest w stanie odebrać strony tak jak człowiek, dlatego odczytuje jej kod. Wyszczególnia on z niego zarówno samą treść, jak i elementy mające świadczyć o tym, czego ta treść dotyczy. Sprawdza też aspekty dotyczące samego funkcjonowania witryny.

Crawler Google bierze pod uwagę m.in.:

- Meta tag title,

- Meta tag description,

- Atrybuty alt obrazków,

- Przekierowania,

- Atrybuty rel linków,

- Nagłówki H1-H6,

- Treść.

Podsumowanie

Zrozumienie tego, na jakiej zasadzie działają roboty internetowe pozwala lepiej zrozumieć, co mają na celu działania prowadzone w obrębie SEO. Dzięki wiedzy na temat tego, jak Google widzi stronę, możesz z kolei prowadzić te działania skuteczniej. Wiesz po prostu, jak to wszystko działa. Jesteś więc o krok bliżej od nauczenia się, jak samodzielnie pozycjonować swoją stronę.

Z tego artykułu dowiedziałeś się:

- Jak Google widzi Twoją stronę

- Jak działają roboty Google

![[object Object] - Top Online](

https://cdn.toponlineapp.pl/6979-logo-toponline-partner.png)