Raporty GSC „Jakość strony” i „Obsługa na urządzeniach mobilnych” zostaną usunięte. Page Expierence okazuje się być częścią Helpful Content. Pojawił się też nowy Googlebot: GoogleOther. Poza tym: usunięte wzmianki o systemach rankingowych, informacje o dostawach i zwrotach w SERP i analiza bazy danych AI.

1. Raport Jakość strony zniknie z Google Search Console

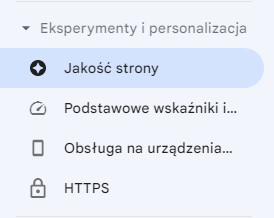

Zakładkę Eksperymenty i personalizacja w Search Console czeka spora przebudowa.

Google zapowiedziało, że usunie „niebawem” raport Jakość strony (Page Experience). Na grudzień 2023 zaplanowane zostało też wycofanie raportu Obsługa na urządzeniach mobilnych, oraz Testu optymalizacji mobilnej i jego API.

Decyzje te nie znaczą jednak, że optymalizacja mobilna czy ogólna jakość strony w wycofywanym właśnie raporcie przestają mieć znaczenie – wręcz przeciwnie. Google komentuje to tak:

„Raport jakości strony powstał jako ogólny przewodnik po niektórych wskaźnikach, które mogą świadczyć o dobrych doświadczeniach użytkowników na stronie, a nie jako kompleksowa ocena wszystkich różnych aspektów”.

W domyśle: w miarę rozwoju systemów Google raport przestał być wystarczająco istotny i ze względu na swoją prostotę może przekłamywać realia. Stąd decyzja o tym, żeby się go pozbyć.

Raport, narzędzie i API dotyczące badania optymalizacji pod kątem urządzeń mobilnych będą z kolei wycofywane dlatego, że „zostały one uruchomione 10 lat temu, a od tego czasu powstało mnóstwo solidnych narzędzi tego typu, jak choćby Lighthouse od Chrome”.

W skrócie więc: Google pozbywa się rzadziej używanego i mniej rozwiniętego rozwiązania – stawiając na rozwój Lighthouse.

Wszystkich chcących zadbać o jakość strony Google odsyła teraz do zaktualizowanej podstrony Page Experience w swojej dokumentacji. Uwaga: polska wersja językowa nie została jeszcze odświeżona.

2. Nie ma Helpful Content bez dobrego Page Experience

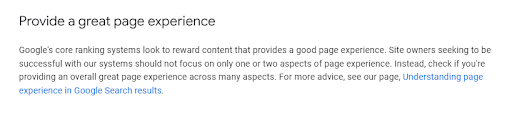

W związku z powyższymi zmianami w Search Console oraz dokumentacji, Google zaktualizowało podstronę dotyczącą tworzenia przydatnych treści (Helpful Content). Od teraz w wytycznych tych oficjalnie uwzględniane jest też Page Experience.

Dokumentacja wyszukiwarki zaznacza teraz, że „systemy rankingowe nagradzają content dostarczający dobre doświadczenia”. Liczy się więc nie tylko użyteczność treści, ale i ogólna jakość strony.

Pojawił się też odnośnik do nowej dokumentacji Page Experience, którą linkowałem już w pierwszym newsie.

Najważniejsze wnioski ze zmienionej dokumentacji dot. Page Experience i Helpful Content streściłbym do 4 punktów:

- Nie ma żadnego indywidualnego „sygnału” jakości strony, sygnałów tych jest wiele – trzeba skupiać się nie na „odhaczaniu” poszczególnych elementów optymalizacji, tylko na ogólnych, całościowych wytycznych.

- System Helpful Content nadal skupia się głównie na treści, czynniki dot. jakości strony są tu tylko jedną ze składowych.

- Dobre wyniki Core Web Vitals nadal są ważne w kontekście dobrych doświadczeń użytkowników oraz SEO.

- Choć istnieją ponoć w tej kategorii czynniki dotyczące całych serwisów (site-wide), to Google ocenia jakość strony przede wszystkim w stosunku do pojedynczych podstron – warto być więc dokładnym.

Zaktualizowana dokumentacja Helpful Content jest dostępna na razie wyłącznie po angielsku.

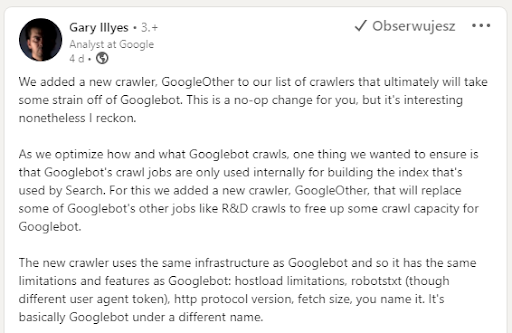

3. Nowy crawler Google – GoogleOther

Google dodało nowego robota internetowego (crawlera), którego nazwa to GoogleOther. Nowy bot ma „ostatecznie” odciążyć nieco Googlebota. Powstał po to, by firma mogła zagwarantować użytkownikom, że wszystkie wizyty Googlebota są wykorzystywane wyłącznie wewnętrznie, do budowy indeksu wyszukiwania.

GoogleOther zajmie się całą resztą zadań, takich jak crawlowanie w celach badawczych i rozwojowych, które dotychczas wykonywał Googlebot.

Technicznie nowy crawler jest identyczny jak podstawowy Googlebot. Przestrzega takich samych reguł, porusza się w ten sam sposób, a nawet korzysta z tej samej infrastruktury. Jedyna różnica to inny User Agent (czyli nazwa, której można używać w pliku robots.txt).

4. Google usuwa informacje o kilku aktualizacjach

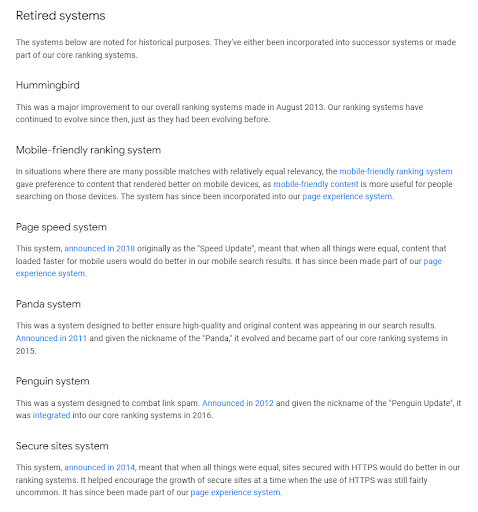

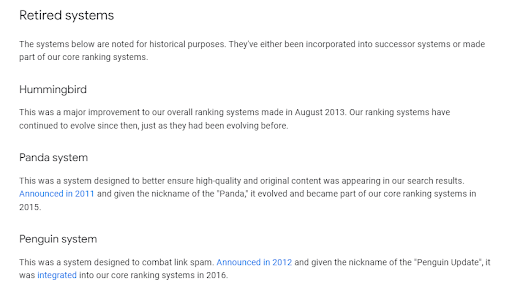

Z Przewodnika po systemach rankingowych wyszukiwarki Google zniknęły w tym tygodniu informacje o kilku aktualizacjach/systemach rankingowych.

Google po cichu znacznie odchudziło sekcję Wycofanych systemów, usuwając kompletnie ze strony Page experience system, Mobile-friendly ranking system, Page speed system oraz Secure sites system.

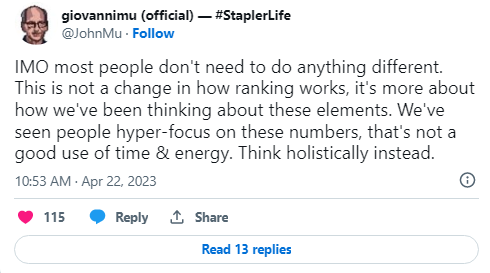

Zmiany te zostawiły w społeczności spory znak zapytania. Z odpowiedzią i wyjaśnieniem sprawy przyszedł jednak John Mueller (który pracuje dla Google).

Parafrazując: Nie jest to żadna zmiana w działaniu wyszukiwarki, chodzi raczej o to, jak myślimy o tych elementach. Widzieliśmy ludzi, którzy niepotrzebnie skupiają się na liczbach związanych z tymi „systemami”. To strata czasu i energii, lepiej myśleć holistycznie (całościowo).

Google wyrzuciło wzmianki o systemach rankingowych, które skupiają się bardziej na koncepcjach niż na sztywnych sygnałach. Po to, by nikt nie myślał, że np. bezpieczna strona = HTTPS, a dobry page speed = wynik 80+ w Lighthouse.

Bezpieczeństwo, szybkość czy jakość strony nie są łatwo mierzalne i nie da się zadbać o nie trzymając się sztywno kilku metryk. Według Google podejście zawsze powinno być całościowe, także wtedy gdy prowadzimy pozycjonowanie.

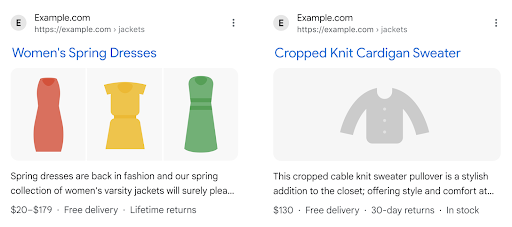

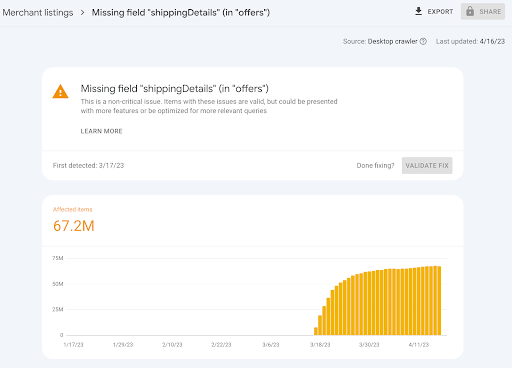

5. Info o dostawach i zwrotach – nowa funkcja wyników, nowa Schema i raport GSC

Google oficjalnie wprowadziło rozszerzenie wyświetlające informacje o dostawach i zwrotach w wynikach produktowych. Razem z nim pojawiła się też nowa specyfikacja danych strukturalnych, pozwalająca na widoczność w nowych funkcjach oraz analogiczny raport w Search Console.

Informacje o dostawie i zwrotach będą pojawiać się poniżej wyniku wyszukiwania, razem z ceną. Na ich wyświetlanie pozwalać mają nowe oznaczenia danych strukturalnych produktów w połączeniu z Google Merchant Center. Ich specyfikację zobaczyć możesz na stronie dokumentacji schema Product.

Razem z nowymi typami wspieranych danych strukturalnych w Search Console pojawi się także nowy dotyczących ich raport. Konkretnie będzie to nowy rodzaj błędu w raporcie Merchant Listings (Informacje na karcie zakupy).

Nowe funkcje wyników będą dostępne niebawem w Stanach Zjednoczonych, ale zostaną już na stałe i trafią też później do innych krajów.

Czy warto aktualizować już dane strukturalne w sklepie internetowym? W naszej opinii nie ma pośpiechu, ale na pewno przyda się to w przyszłości.

6. Sprawdź, czy Google uczyło swoje AI na Twojej stronie

Na koniec niezła ciekawostka.

The Washington Post, we współpracy z Allen Institute przygotował analizę zbioru danych C4 (Colossal Clean Crawled Corpus). To baza treści z przeszło 15 milionów stron internetowych, na którym trenowane były modele językowe (AI) Google i Facebooka.

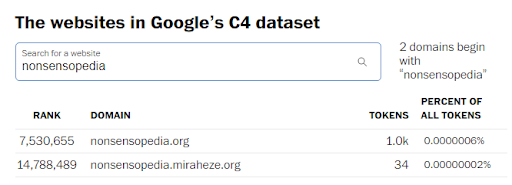

Z analizy tej powstał świetny artykuł, który porusza między innymi kwestie praw autorskich, ochrony danych osobowych i obiektywności AI. To, co chciałem jednak szczególnie tutaj wyróżnić, to wyszukiwarka stron stworzona w ramach tego projektu.

Serwis przygotował wewnątrz tekstu narzędzie, które pozwala sprawdzić, czy wpisana domena znalazła się w zbiorze danych. Dzięki temu możemy zobaczyć, czy nasze strony zostały wykorzystane do trenowania AI!

Zanim jednak rzucicie się do sprawdzania, pamiętajcie, że dane nie są kompletne (o czym więcej w treści artykułu), oraz że sam analizowany data-set powstał w 2019 roku.

Na koniec jeszcze jeden fakt z tekstu, który wydał mi się wyjątkowo ciekawy:

Autorzy donoszą, że symbol Copyright (©) przewinął się w całym zestawie danych bagatela 200 milionów razy (!). Cytując: analiza sugeruje, że (w związku z AI) pojawi się jeszcze wiele wyzwań prawnych.

Tekst, o którym mowa znajdziecie na Washingtonpost.com.