W ChatGPT można korzystać z zewnętrznych aplikacji. Ciekawe badania dotyczące związku między datą publikacji contentu a widocznością w wyszukiwarkach AI. Google wprowadza technologię Speech-to-Retrieval do wyszukiwania głosowego. Poza tym: NotebookLM ignoruje plik robots.txt, informacje o systemie Google Goldmine Scoring System, a także Nano Banana w Google Lens.

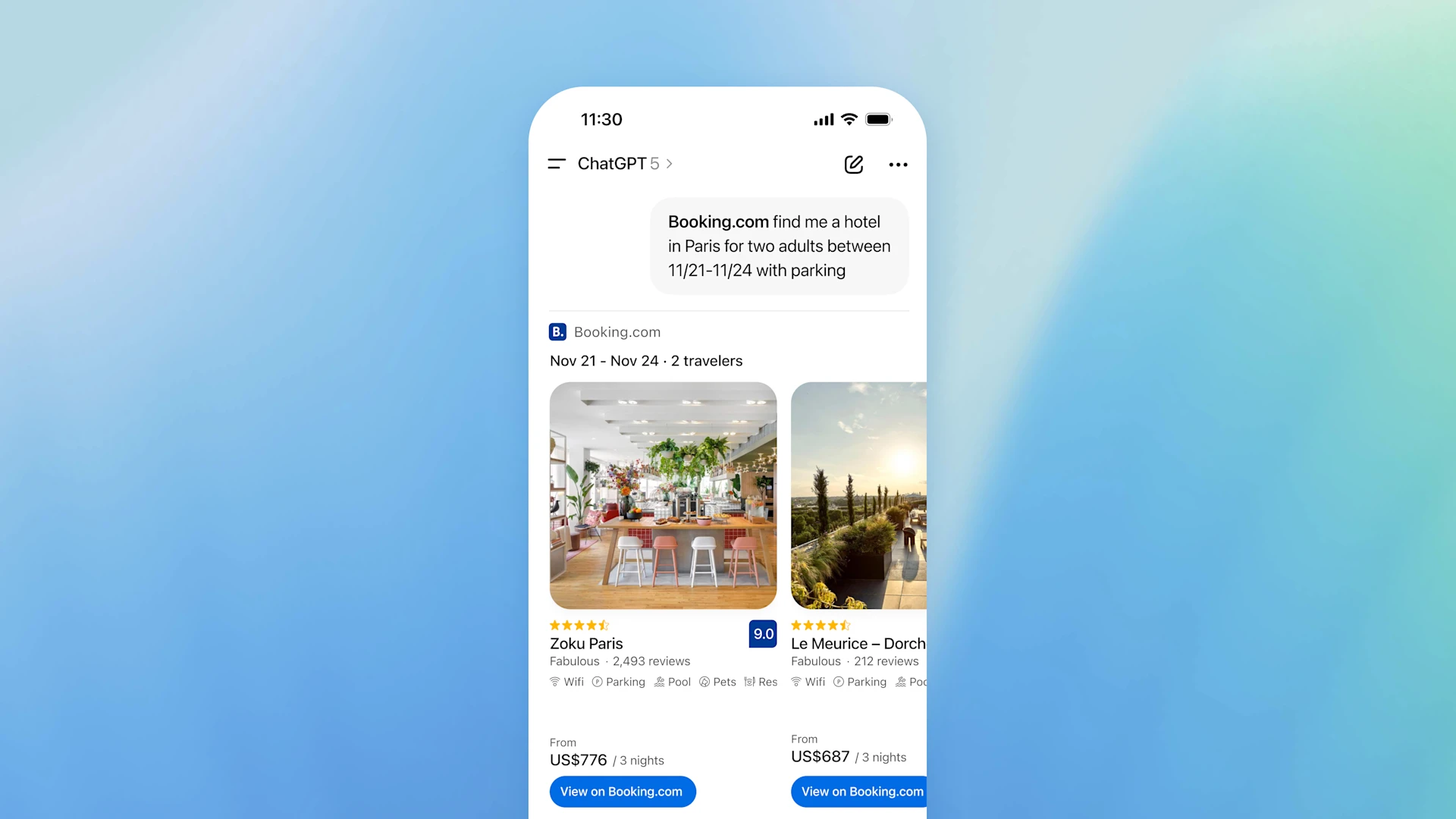

1. Aplikacje innych firm bezpośrednio w ChatGPT

Najpopularniejszy na świecie czatbot AI stopniowo przestaje być jedynie narzędziem do rozmowy. Po testach funkcji Instant Checkout, czyli możliwości robienia zakupów bezpośrednio w ChatGPT przyszedł czas na wdrożenie do niego zewnętrznych aplikacji.

Użytkownicy mogą od teraz korzystać z apek innych producentów (np. z Canvy czy Spotify) bez opuszczania czata. Można więc nie tylko rozmawiać z GPT, ale też wykonywać konkretne działania.

Co ważne, czatbot sam będzie proponował aplikacje w zależności od kontekstu rozmowy. Jeśli użytkownik wspomni o planowaniu podróży, może automatycznie pojawić się propozycja skorzystania z Booking.com lub innego serwisu z noclegami.

OpenAI zapowiada również wprowadzenie sklepu z aplikacjami wewnątrz ChatGPT oraz pakietu narzędzi (SDK) dla deweloperów. Dzięki temu firmy i twórcy będą mogli tworzyć własne miniaplikacje działające w środowisku konwersacyjnym.

W planach jest też dalsze rozwijanie funkcji dokonywania zakupów i płatności bezpośrednio w czacie, co na pewno zwiększy popularność tzw. „agentic commerce”.

Dzieje się.

Zapowiedź nowych funkcjonalności możecie sprawdzić pod tym linkiem: Introducing apps in ChatGPT and the new Apps SDK.

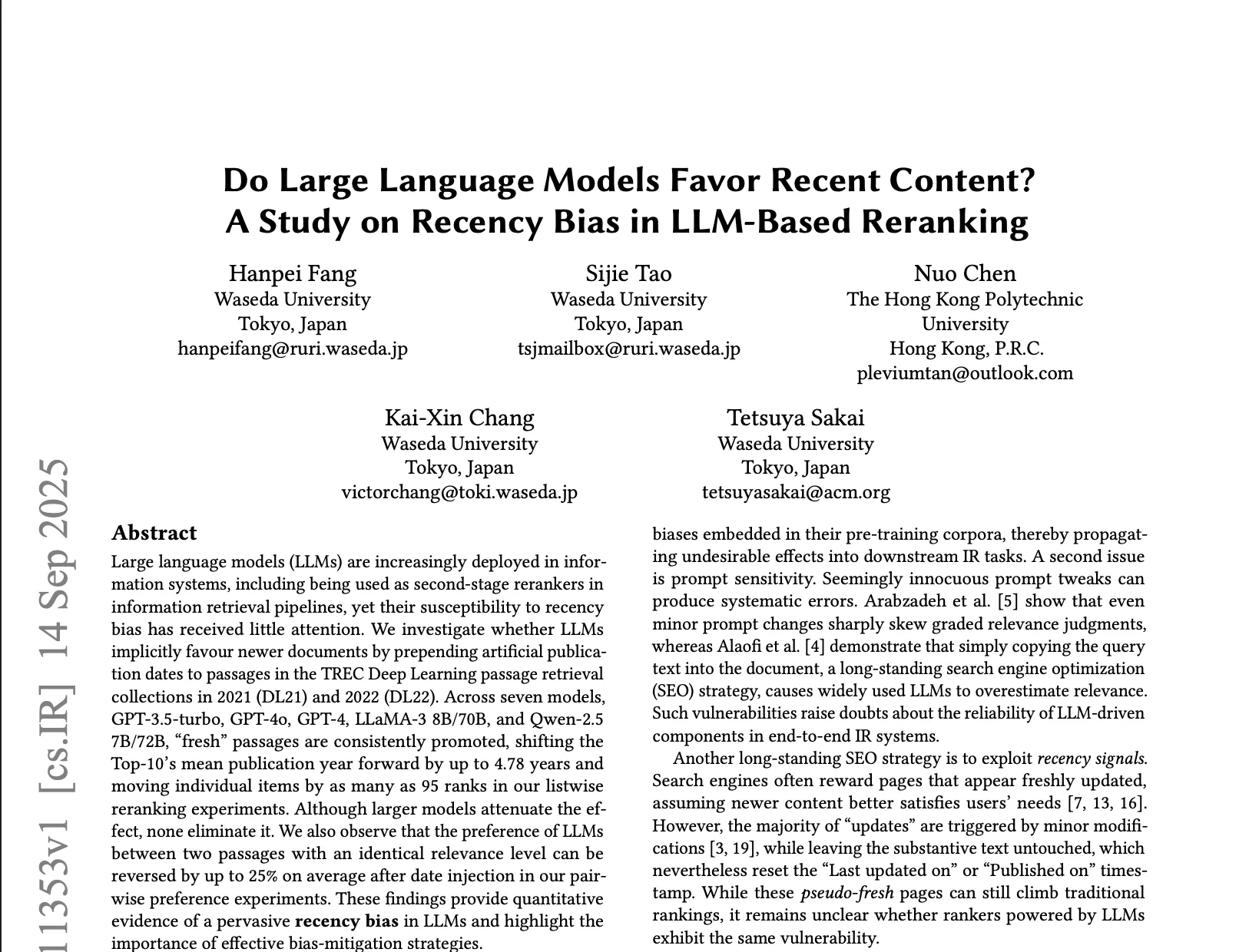

2. Fejkowe daty = lepsza widoczność w wyszukiwarkach AI? Analiza

Nowe badanie zespołu z Uniwersytetu Waseda w Tokio ujawniło, że duże modele językowe – w tym GPT-4, LLaMA-3 czy Qwen-2.5 – można łatwo zmanipulować, zmieniając daty publikacji contentu. Potwierdzono, że AI wyżej ocenia treści oznaczone jako nowsze, nawet jeśli są identyczne ze starszymi wersjami.

W eksperymencie badacze zmieniali jedynie daty publikacji tych samych materiałów, pozostawiając treść bez zmian. Następnie testowali, które wersje będą uznane przez modele AI za bardziej trafne.

Efekt? W większości przypadków nowsze daty przesuwały materiały na wyższe pozycje rankingowe – czasem nawet o kilkadziesiąt miejsc w górę. W niektórych modelach (np. LLaMA-3) aż 25% ocen trafności zostało odwróconych tylko z powodu różnicy w dacie.

Zjawisko to potwierdza istnienie tzw. recency bias – „uprzedzenia” modeli w stosunku do treści postrzeganych jako mniej aktualne. Jak wskazują badacze, OpenAI i inne firmy mogą stosować wewnętrzne mechanizmy premiujące świeżość contentu, co potwierdza wpis „use_freshness_scoring_profile: true” w konfiguracjach ChatGPT.

Choć w praktyce może to poprawiać jakość wyników, badanie zwraca uwagę na potencjalne zagrożenie – fałszywe aktualizacje dat mogą stać się łatwym sposobem na podbicie widoczności treści w systemach opartych o AI.

Tutaj sprawdzicie pełne badanie: Do Large Language Models Favor Recent Content? A Study on Recency Bias in LLM-Based Reranking.

3. Technologia S2R od teraz w wyszukiwaniu głosowym Google

Google ogłosił wprowadzenie nowego systemu obsługi wyszukiwania głosowego o nazwie Speech-to-Retrieval (S2R), który zastępuje dotychczasowy model zamiany mowy na tekst (ASR – automatic speech recognition).

Nowe rozwiązanie pozwala wyszukiwarce pomijać etap tłumaczenia wypowiedzi użytkownika na tekst i bezpośrednio interpretować znaczenie zapytania na podstawie dźwięku.

Do tej pory wyszukiwanie głosowe działało kaskadowo: najpierw mowa była zamieniana na tekst, a dopiero później analizowana jako zapytanie. Taki system był podatny na błędy – niewłaściwe rozpoznanie słowa mogło całkowicie zmienić sens pytania i w efekcie dać nietrafione wyniki.

S2R ma wyeliminować ten problem, przetwarzając mowę w sposób semantyczny – bez pośrednictwa tekstu.

Jak wyjaśnia Google, nowa technologia opiera się na zaawansowanych modelach, które tworzą wektorowe reprezentacje dźwięku (tzw. embeddingi audio). Na ich podstawie system bezpośrednio dopasowuje najbardziej adekwatne treści w wyszukiwarce, dzięki czemu proces jest szybszy i bardziej precyzyjny.

Pierwsze testy pokazują, że S2R znacząco poprawia dokładność wyników w porównaniu z klasycznym podejściem ASR. System jest już wdrażany w wybranych językach i stopniowo pojawi się u kolejnych użytkowników.

Ta zmiana może mieć duże znaczenie dla pozycjonowania i voice marketingu. Na pewno jeszcze większą rolę odegra naturalność wypowiedzi, kontekst mówiony i sposób, w jaki ludzie faktycznie zadają pytania głosowo.

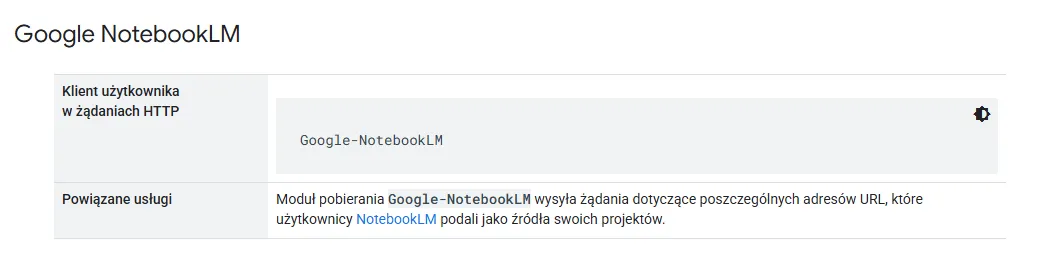

4. Google: NotebookLM ignoruje robots.txt

Google po cichu zaktualizował swoją dokumentację, potwierdzając, że narzędzie NotebookLM – system do analizy treści i generowania podsumowań na podstawie podanych źródeł – ignoruje reguły pliku robots.txt.

Oznacza to, że nawet jeśli właściciel strony zablokował dostęp robotom w pliku, NotebookLM wciąż może pobrać i przetworzyć treść witryny.

Zmiana dotyczy tzw. user-triggered fetchers, czyli agentów działających na wyraźne żądanie użytkownika. W przypadku NotebookLM użytkownik wkleja link do strony, a narzędzie pobiera jej zawartość, by wygenerować streszczenie lub odpowiedzi na pytania.

Google tłumaczy, że takie działania są inicjowane przez człowieka, a nie automatyczne crawlowanie – dlatego reguły z robots.txt nie są w tym kontekście stosowane.

Jeśli jednak z jakiegoś powodu chcielibyście zablokować dostęp NotebookLM, możecie to zrobić na kilka sposobów – np. wykorzystując Wordfence do stworzenia niestandardowej reguły blokującej (dla użytowników WordPressa) albo ograniczając dostęp dla agenta Google-NotebookLM w pliku .htaccess.

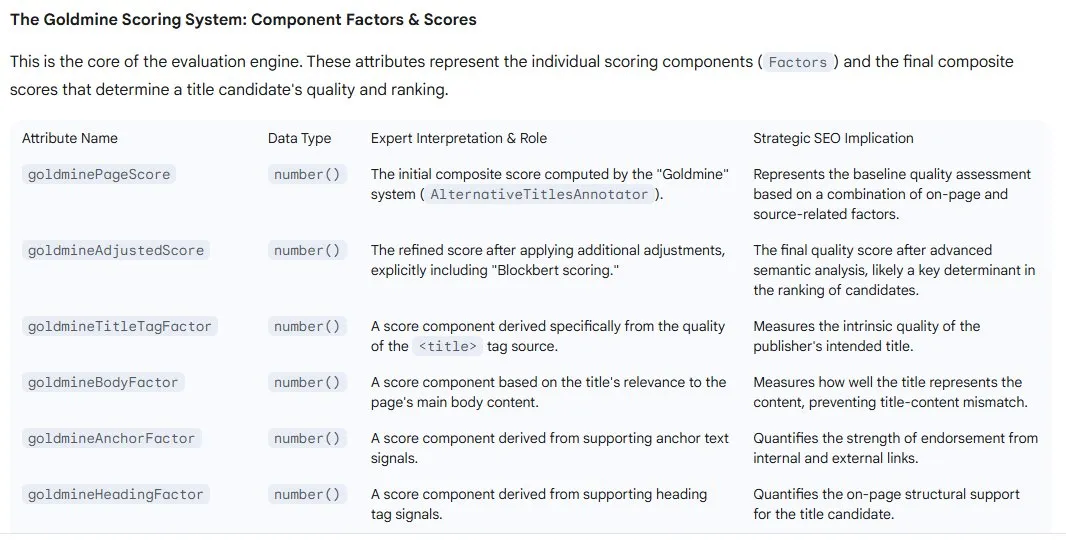

5. Google Goldmine Scoring System i jego wpływ na ocenę strony

W sieci pojawiły się nieoficjalne informacje o systemie Google o nazwie Goldmine, który ma odpowiadać za analizę treści stron i wybór najbardziej trafnych tytułów wyświetlanych w wynikach wyszukiwania.

Doniesienia pochodzą z analiz wewnętrznych danych Google udostępnionych przez eksperta SEO Shauna Andersona.

Z przecieków wynika, że Goldmine to złożony system rankingowy, który ocenia witryny na podstawie wielu czynników takich jak tytuł strony, nagłówki (H1, H2), treść właściwa oraz anchory.

Każdy z tych elementów ma swój własny współczynnik – m.in. goldmineTitleTagFactor, goldmineBodyFactor czy goldmineAnchorFactor – które razem tworzą tzw. goldminePageScore.

Celem systemu jest wybranie najlepszego wariantu tytułu do wyświetlenia w SERP-ach. Oznacza to, że Google nie zawsze pokazuje tytuł ustawiony w znaczniku title, lecz ten, który jego algorytmy uznają za bardziej trafny dla użytkownika.

Goldmine Scoring System nie został oficjalnie potwierdzony przez Google, ale wpisuje się w szerszy trend automatycznego „przepisywania” tytułów przez wyszukiwarkę i coraz głębszej analizy kontekstu treści.

Eksperci SEO zwracają uwagę, że jeśli informacje o Goldmine się potwierdzą, może to zmienić sposób, w jaki należy projektować treści.

Spójność między tytułem, nagłówkami i kontekstem strony stanie się kluczowa – wszystkie te elementy mogą wpływać na ostateczny wygląd i ranking strony w wyszukiwarce.

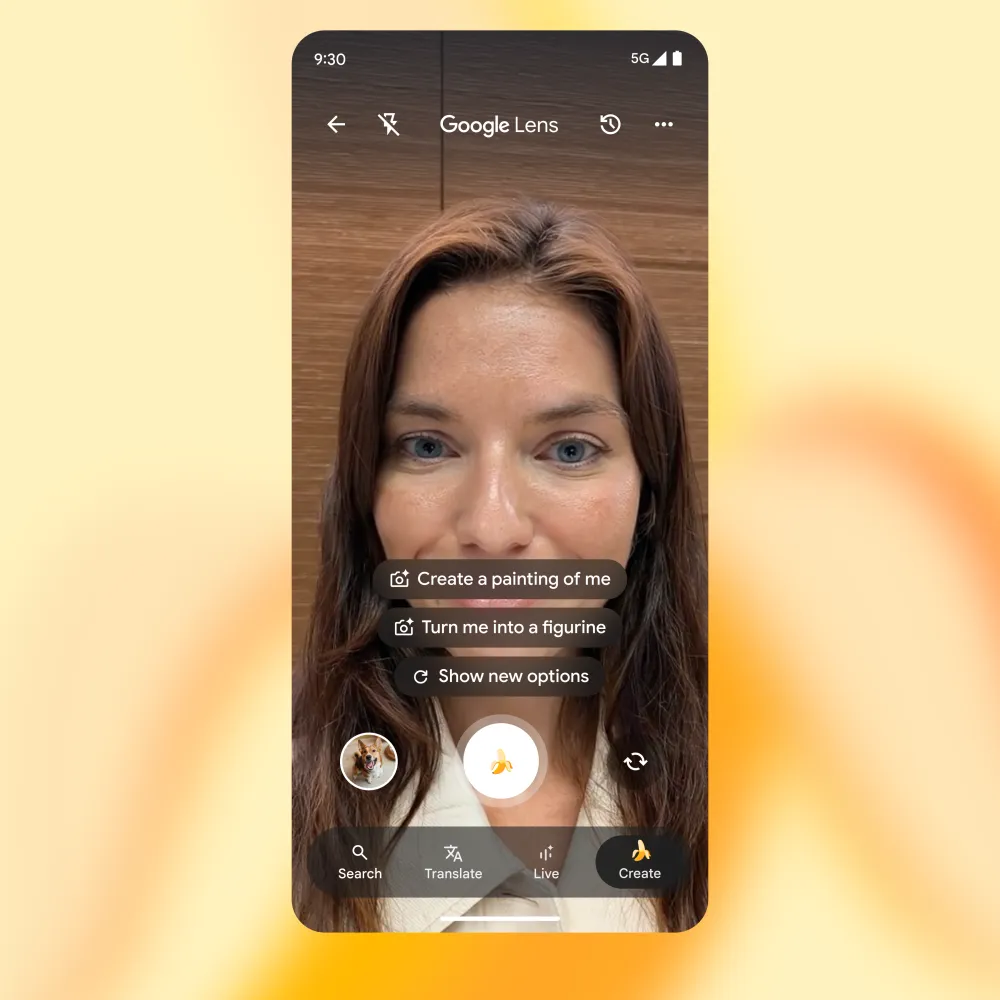

6. Nano Banana w Google Lens

Google rozszerza możliwości Google Lens o nową funkcję opartą na sztucznej inteligencji. Dzięki niej użytkownicy mogą tworzyć lub modyfikować obrazy bezpośrednio w wyszukiwarce, korzystając z Nano Banana – funkcji generowania realistycznych zdjęć, która stosunkowo niedawno pojawiła się w aplikacji Gemini.

Nowa opcja dostępna jest w trybie „Create” w Google Lens i pozwala tworzyć obrazy na podstawie opisu lub istniejącego zdjęcia.

Użytkownik nie musi już przełączać się między aplikacjami – wystarczy otworzyć Lens w wyszukiwarce Google, by stworzyć grafikę, ilustrację czy fotomontaż w czasie rzeczywistym.

To ewidentnie kolejny krok w kierunku połączenia wyszukiwania, analizy obrazu i generatywnej AI w jednym ekosystemie.

Google konsekwentnie integruje swoje narzędzia i technologie, tworząc spójne środowisko, w którym użytkownik nie tylko szuka, ale i tworzy treści wizualne.