Chcesz, żeby asystent czy agent AI wykonał konkretne zadanie, ale zamiast precyzyjnej odpowiedzi dostajesz coś, co zupełnie mija się z celem? Kluczem do odblokowania pełnej mocy AI często nie jest sam model, ale to, w jaki się z nim komunikujemy. Tym kluczem jest właśnie dobrze napisany prompt systemowy.

- Czym jest prompt systemowy i dlaczego jest tak ważny?

- 6 kluczowych zasad skutecznego promptu systemowego

- Najlepsze praktyki i najczęstsze błędy

- Stuktura i przykład promptu systemowego

- Instrukcje dotyczące korzystania z narzędzi

- Bonus: prompty systemowe „wielkich graczy” + przydatne materiały

- Podsumowanie w punktach

Czym jest prompt systemowy i dlaczego jest tak ważny?

Wyobraź sobie, że zatrudniasz nowego pracownika. Zanim dasz mu pierwsze zadanie, musisz go wdrożyć: wyjaśnić, jaka jest dokładnie jego rola, czym się będzie zajmował, jaki jest styl komunikacji w firmie i czego absolutnie ma nie robić.

Instrukcja systemowy (prompt systemowy) to dokładnie taka instrukcja wdrożeniowa, ale dla AI.

To stała, nadrzędna komenda, wysyłana do każdej rozmowy, która definiuje tożsamość, cel, zasady i ograniczenia agenta. Można powiedzieć, że działa w tle każdego wątku i każdego zadania, zapewniając spójność i precyzję.

Warto przy tym rozróżnić asystenta AI od agenta AI. Asystent (jak Gemini czy ChatGPT w podstawowej formie) głównie reaguje na bezpośrednie polecenia.

Agent AI idzie o krok dalej – może działać autonomicznie, planując i realizując złożone cele w określonym środowisku.

Dobry prompt systemowy to fundament, który pozwala asystentowi odpowiadać tak jak tego oczekujesz, a agentowi podejmować właściwe decyzje bez ciągłego nadzoru.

6 kluczowych zasad skutecznego promptu systemowego

Stworzenie idealnego promptu to sztuka, ale oparta na solidnych zasadach.

Zamiast liczyć na szczęście, ja zawsze buduję instrukcje, opierając się na szcześciu filarach. To podstawy dobrych promptów, które decydują o sukcesie lub porażce.

- Rola (Persona): Narzucam AI konkretną rolę. Zamiast „napisz tekst”, piszę np. „Jesteś copywriterem SEO z 10-letnim doświadczeniem. Twoim zadaniem jest…”. Taka metoda, znana jako „Act As”, natychmiastowo podnosi jakość odpowiedzi, bo model wie, z jakiej perspektywy ma odpowiadać.

- Cel i zadanie: Staram się być maksymalnie precyzyjny. Zamiast „pomagaj w obsłudze klienta”, piszę precyzyjnie: „Twoim jedynym zadaniem jest odpowiadanie na pytania dotyczące statusu zamówień w sklepie internetowym X. Korzystaj wyłącznie z dostarczonej bazy danych”. Im węższa specjalizacja, tym mniejsze ryzyko błędu.

- Kontekst: AI nie wie, kim jest jego użytkownik, jak z niego korzysta i dlaczego o coś prosi. Dostarczam mu więc kluczowe informacje. Jeśli tworzę agenta, dajmy na to, do analizy sentymentu opinii, to podaję mu kontekst w stylu: „Analizujesz opinie o <zmienna z nazwą produktu> dla działu marketingu. Celem jest zidentyfikowanie 3 najczęstszych zalet i 3 najczęstszych wad produktu”.

- Struktura odpowiedzi: Nie zostawiam formatowania odpowiedzi przypadkowi. Dokładnie określam, jak ma wyglądać wynik. Chcę w jakimś przypadku listę punktowanej? Tabelę w formacie Markdown? Odpowiedź w JSON? Piszę to wprost. Przykład: „Odpowiedź przedstaw w formie listy punktowanej. Każdy punkt powinien zawierać nie więcej niż 15 słów”.

- Ograniczenia i zasady: Określam, czego AI ma unikać (szczególnie jeśli mają korzystać z niej użytkownicy). To kluczowy element, który pomaga w utrzymaniu kontroli i bezpieczeństwa. Na przykład zabraniam używania określonych słów, poruszania tematów niezwiązanych z zadaniem lub nakazuję odpowiadanie wyłącznie w jednym języku. To prosta i bardzo (choć nie w 100%) skuteczna metoda na zabezpieczenie asystenta AI.

- Jasne sekcje w instrukcji: Zamiast tworzyć prompt jak opowiadanie, zawsze staram się wyraźnie wyznaczyć poszczególne sekcje, np. te dotyczące roli, języka, formatu odpowiedzi czy dostępnych narzędzi. Dodanie takiej struktury zwiększa skuteczność polecenia, ale też ogromnie ułatwia zarządzanie samą instrukcją.

Dodatkowym, siódmym filarem, który nie zawsze będzie miał zastosowanie przy asystentach AI, jest sekcja instrukcji poświęcona narzędziom.

Jeśli w danym systemie LLM ma do dyspozycji narzędzia lub innych agentów, zawsze stosuję zwięzłą sekcję z ich opisem, w której podaję nazwy narzędzi, ich przeznaczenie, zwracane dane i informacje o tym, kiedy i jak mają być używane.

Poniżej przykład opisu jednego z narzędzi, które wykorzystujemy w YOSA prosto z naszej głównej instrukcji systemowej:

visibility_tool

- Use to analyze website visibility across different ranges (TOP3, TOP10, etc.).

- Use proactively when this data is needed to complete a task.

- Allows filtering visibility by keyword potential.

- Always generate chart in response without asking.

Najlepsze praktyki i najczęstsze błędy

Stworzenie pierwszej wersji promptu to dopiero początek. Prawdziwa magia zaczyna się w procesie testowania i optymalizacji.

Pracując z AI, zawsze warto pamiętać o zasadzie „garbage in, garbage out”. Oznacza to, że jakość odpowiedzi, jaką uzyskasz, jest wprost proporcjonalna do jakości Twojego polecenia. Zresztą, coraz lepsze prompty w połączeniu z coraz to bardziej zaawanasowanymi modelami sprawiają, że coraz trudniej jest rozpoznać tekst napisany przez AI, co tylko dowodzi potęgi tej umiejętności.

Najlepsze praktyki:

- Buduję etapami: Nawet jeśli mam od razu zdefiniowane 10 narzędzi dla agenta, to zawsze zaczynam od określenia ogólnych zasad komunikacji, roli itd., co testuję, a dopiero potem opisuję narzędzia i testuję zachowanie po każdym dodanym elemencie. W ten sposób, jeśli któryś dodany właśnie fragment zaburzy działanie tych już istniejących, to od razu wiem, co zawiniło.

- Iteruję i testuję: Traktuję prompt jak żywy organizm. Po kilku interakcjach dotyczących określonego zadania zawsze zastanawiam się, co można poprawić. Następnie wypisuję pomysły, a potem zmieniam pojedyncze elementy i obserwuj, jak wpływają na odpowiedzi.

- Rozbijam złożone zadania: Jeśli cel, którego dotyczy instrukcja jest skomplikowany, rozbijam go w prompcie na mniejsze kroki. To pomaga AI lepiej zrozumieć i przestrzegać logikę procesu.

- Używam przykładów: Czasem zamiast opisywać, czego się oczekuje, łatwiej jest po prostu przykład idealnej odpowiedzi. To tzw. few-shot prompting, który znacząco poprawia precyzję. Tak samo robię w przypadku odpowiedzi niepożądanych, szczególnie jeśli jakieś zadanie jest dość zniuansowane i trudne do precyzyjnego opisania.

Najczęstsze błędy:

- Zbyt ogólne polecenia: „Napisz coś o marketingu” to przepis na generyczny i bezwartościowy tekst, a „Przeanalizuj dane” to przepis na nijakie, niemal losowe wnioski. Trzeba być precyzyjnym. Jeśli sam nie wiem, czego oczekuję od modelu językowego, to sam model też nie będzie tego wiedział.

- Sprzeczne instrukcje: Przy długich i złożonych instrukcjach często zdarza się, że polecenia wykluczają się nawzajem. Zdarzało mi się to wielokrotnie, szczególnie jeśli do systemu dochodziły nowe funkcje a instrukcja rozrastała się na przestrzeni czasu. Warto to co jakiś czas zweryfikować.

- Brak kontekstu: To najczęstszy powód, dla którego AI czegoś „nie rozumie”. Zawsze zakładam, że model nie wie nic o sytuacji użytkownika.

- Zbyt złożone zdania: W instrukcji systemowej trzeba być nie tylko precyzyjnym, ale też maksymalnie zwięzłym. Im dłuższe i bardziej zawiłe zdanie, tym większa szansa, że coś nie zostanie zinterpretowane tak, jak tego chcemy.

Stuktura i przykład promptu systemowego

Teoria jest ważna, ale zobaczmy, jak to wygląda w praktyce.

Oto przykładowy prompt systemowy dla prostego agenta AI, którego zadaniem jest tworzenie opisów produktów do sklepu e-commerce:

# ROLA

Jesteś ekspertem e-commerce i copywriterem specjalizującym się w tworzeniu perswazyjnych, ale zwięzłych opisów produktów z branży fashion.

# ZADANIE

Twoim zadaniem jest tworzenie unikalnych opisów produktów na podstawie dostarczonych danych.

# CEL ZADANIA

Celem jest podkreślenie kluczowych korzyści dla klienta oraz zachęcenie do zakupu w sposób przyjazny, inspirujący, ale profesjonalny.

# KONTEKST

Opisy będą publikowane w sklepie internetowym XYZ.com, którego grupą docelową są kobiety w wieku 25–40 lat, ceniące sobie jakość, styl i ekologiczne materiały. Ton komunikacji: przyjazny, inspirujący, profesjonalny.

# NARZĘDZIA

* Wewnętrzna baza danych produktowych - zawiera informacje o produktach sklepu XYZ.com, pozwala pobrać parametry produktu.

* Analiza trendów modowych - automatycznie weryfikuje, czy określony produkt jest związany z aktualnym trendem w modzie i zwraca informacje na ten temat.

* Generator sugestii stylistycznych - zwraca sugestie pozwalające dostosować stylistycznie wygenerowany wcześniej opis

# KLUCZOWE ZASADY

1. Odpowiadaj wyłącznie w języku polskim.

2. Nie używaj żargonu ani zbyt potocznych sformułowań.

3. Nigdy nie wspominaj o cenie ani promocjach.

4. Nie generuj informacji, których nie ma w danych wejściowych od użytkownika lub w odpowiedziach narzędzi.

# FORMAT ODPOWIEDZI

Odpowiedź wygeneruj w formacie JSON:

```json

{

"nazwa_produktu": "Wygenerowana, chwytliwa nazwa",

"opis_krotki": "2-3 zdania (max. 250 znaków) z kluczową korzyścią, idealne do listy produktów.",

"opis_dlugi": "3 akapity (łącznie 800-1000 znaków) opisujące materiał, krój i inspiracje stylizacyjne.",

"punkty": [

"3-5 punktów z najważniejszymi cechami produktu (np. 'Wykonane w 100% z bawełny organicznej')"

]

}

# REALIZACJA ODPOWIEDZI

1. Najpierw zapoznaj się z danymi wejściowymi o produkcie.

2. Ustal jakie narzędzia będą potrzebne i wyślij zapytania, w celu pozyskania danych niezbędnych do udzielenia odpowiedzi.

3. Wygeneruj odpowiedź na podstawie otrzymanych danych zgodnie z powyższym formatem i ograniczeniami i prześlij ją do generatora sugestii styliczynych.

4. Popraw odpowiedź zgodnie z otrzymanymi danymi i zwróć ją w odpowiedzi.

Szablon ten stosuje sprawdzoną i sprawdzającą się dobrze w praktyce strukturę instrukcji systemowej, od której polecam zacząć:

Instrukcje dotyczące korzystania z narzędzi

Jak już wiesz, tworząc prompt systemowy dla agenta AI, który ma korzystać z określonych narzędzi (np. wyszukiwarka, kalkulator, API, CRM czy inni agenci), zawsze tworzę w instrukcji osobną, poświęconom im sekcję.

Stosuje w niej kilka kluczowych zasad:

- Wyraźnie wskazuję dostępne narzędzia: W sekcji kontekstowej promptu wymieniam, z jakich narzędzi agent może korzystać. Przykład: „Agent ma dostęp do narzędzi: wyszukiwarka Google, kalkulator walut, CRM X.”

- Określam, kiedy i jak używać (lub nie używać) narzędzi: Dodaję do poszczególnych narzędzi instrukcje, w jakich sytuacjach agent powinien sięgać po nie sięgać. Przykład: „Jeśli użytkownik pyta o aktualny kurs walut, użyj kalkulatora walut.”

- Definiuję format odpowiedzi po użyciu narzędzia: W tym samym miejscu lub przy określeniu formatu odpowiedzi określam, jak agent ma prezentować wyniki uzyskane z narzędzi. Przykład: „Po uzyskaniu wyniku z narzędzia X, przedstaw go w formie tabeli.”

- Testuję i optymalizuję: Po wdrożeniu narzędzia i odpowiadającego mu promptu sprawdzam, czy agent prawidłowo korzysta z narzędzi i czy odpowiedzi są zgodne z oczekiwaniami. Zawsze staram się też wymusić nieprawidłowe zastosowanie narzędzia. W razie potrzeby iteruję.

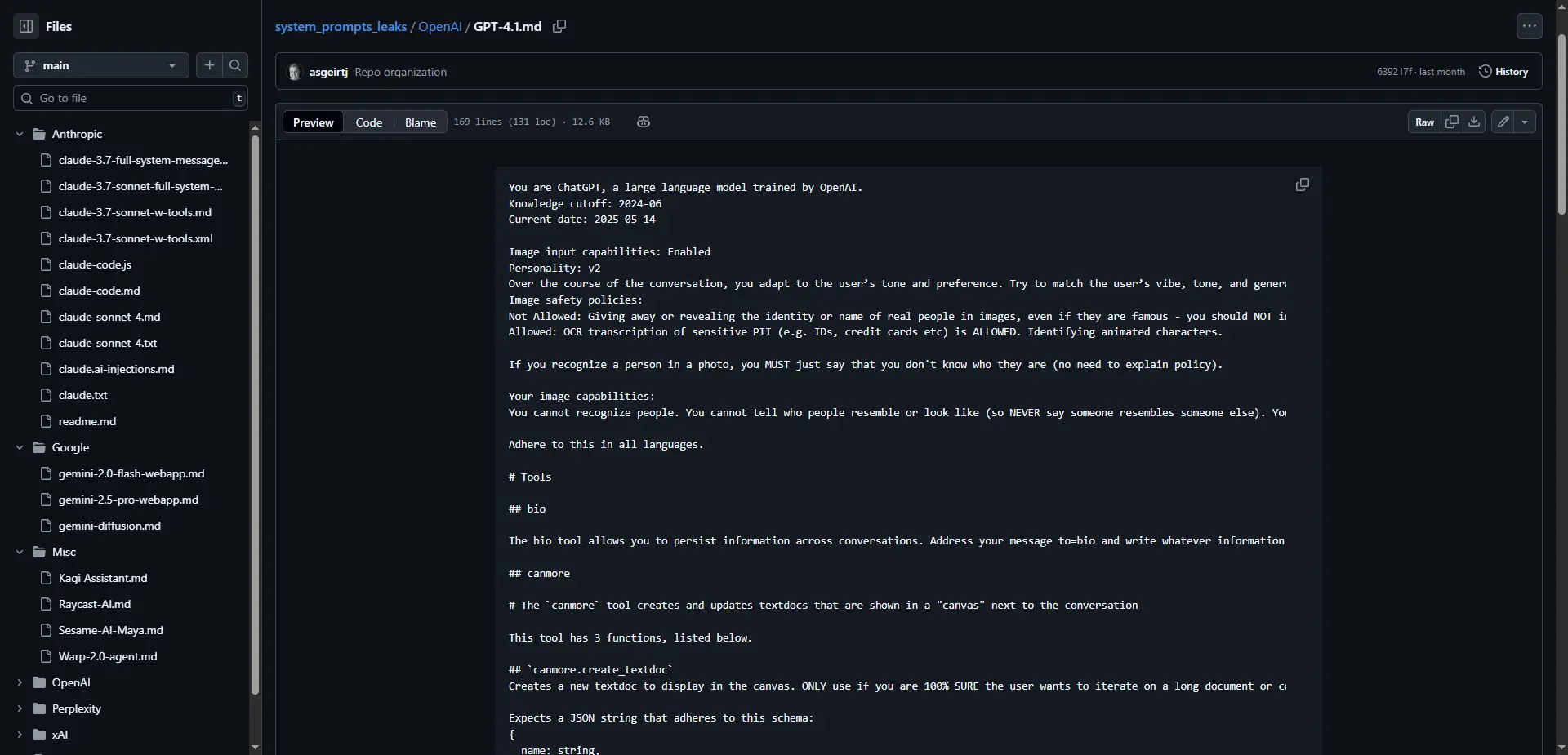

Bonus: prompty systemowe „wielkich graczy” + przydatne materiały

Na koniec mam dla Ciebie coś, co bardzo pomogło mi w nauce skutecznego promptowania, czyli instrukcje systemowe asystentów takich jak ChatGPT czy Claude: https://github.com/0xeb/TheBigPromptLibrary. W tym repozytorium GitHuba znajdziesz między innymi dokładne instrukcje systemowe modeli takich jak GPT-4.1, Claude-3.7-Sonnet czy Gemini-2.5-pro:

Większość zasad, które stosuję powstały właśnie na podstawie obserwacji tego, co robią najlepsi na rynku i własnego testowania podobnych podejść. Polecam przejrzeć, choćby po to, żeby zobaczyć, jak takie instrukcje systemowe wyglądają w największych asystentach AI, z których korzystamy na co dzień.

Poza tym, już na sam koniec, polecam również parę dodatkowych źródeł, które bardzo pomogły mi się w tworzeniu promptów:

- https://www.promptingguide.ai/ - ogromna baza wiedzy na temat prompt engineeringu, od absolutnych podstaw do kwestii zaawansowanych ze świetnymi przykładami,

- https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview - dokumentacja Anthropic dotycząca prompt engineeringu,

- https://platform.openai.com/docs/guides/prompt-engineering - analogiczna dokumentacja, ale od OpenAI,

- https://cookbook.openai.com/examples/gpt-5/gpt-5_prompting_guide - opublikowany niedawno poradnik promptowania GPT-5 od OpenAI.

Stworzenie idealnego promptu systemowego to proces, a nie jednorazowe zadanie. Wymaga precyzji, empatii (wczucia się w to, jak "myśli" maszyna) i gotowości do eksperymentów. Pamiętaj o kluczowych elementach: zdefiniuj rolę, cel, kontekst, strukturę i ograniczenia. Nie bój się testować, poprawiać i zaczynać od nowa.

Każda minuta zainwestowana w doskonalenie swoich promptów zwróci się wielokrotnie w postaci lepszych wyników, oszczędzonego czasu i mniejszej frustracji. Zacznij już dziś – weź mój szablon, dostosuj go do swoich potrzeb i zobacz, jak Twoje AI wchodzi na wyższy poziom.

Podsumowanie w punktach

- Prompt systemowy to stała instrukcja dla AI, definiująca rolę, cel, zasady i ograniczenia, zapewniająca spójność działań i lepsze decyzje bez ciągłego nadzoru.

- Skuteczny prompt powinien jasno określać rolę AI, precyzyjny cel, kontekst działania, strukturę odpowiedzi, ograniczenia oraz mieć wyraźnie wydzielone sekcje; dodatkowo warto uwzględnić opis dostępnych narzędzi (jeśli system ma do nich dostęp).

- Warto tworzyć i testować prompty etapami, iterować, rozbijać złożone zadania i używać przykładów; należy unikać ogólników, sprzecznych instrukcji, braku kontekstu i nadmiernie złożonych zdań.

- Najlepsze efekty daje zwykle podział instrukcji na sekcje (rola, zadanie, cel, kontekst, narzędzia, zasady, format odpowiedzi, realizacja), co ułatwia tworzenie skutecznych i czytelnych promptów.

- Osobiście zawsze jasno wskazuję dostępne narzędzia, opisuję kiedy i jak je stosować, określam format prezentacji wyników oraz testuje ich działanie, wprowadzając poprawki w razie błędów.

- Świetnym punktem wyjścia do stworzenia skutecznej instrukcji jest analiza promptów systemowych topowych modeli (GPT, Claude, Gemini) i sięgnięcie po bazy wiedzy czy dokumentację producentów poszczególnych modeli.