Czy samo pozyskiwanie linków lub sama optymalizacja techniczna daje gwarancję podniesienia pozycji strony? Przebadaliśmy 100 tysięcy wyników Google, żeby znaleźć odpowiedź!

Spis treści:

Zobacz też:

1. Skąd pomysł na badanie?

Przeprowadziliśmy zaawansowaną analizę 100 tysięcy wyników wyszukiwania, co stanowi jedną z największych tego typu inicjatyw w naszej historii.

To próba odpowiedzi na pytanie: Czy można stworzyć model AI, który przewiduje pozycję strony na podstawie konkretnych czynników SEO?.

Badanie to miało na początku służyć wyłącznie tworzeniu zaawansowanego asystenta SEO — naszego Smart SEO Assistant.

Chcieliśmy sprawdzić, czy któreś z czynników zewnętrznych ewidentnie wpływają na pozycję.

Po to, by dowiedzieć się, czy jeśli np. mamy klienta na frazie na pozycji 50, to czy zmiana jakiegokolwiek czynnika (pozyskanie linków lub zmiana czegoś w optymalizacji technicznej) może dać nam gwarancję, że się dostaniemy się do TOP10.

Nasz asystent miał to ostatecznie podpowiedzieć użytkownikowi. Właśnie po to zrobiliśmy badanie.

Wyniki okazały się jednak na tyle ciekawe, że postanowiliśmy podzielić się nimi z branżą — aby rzucić światło na niektóre mity i mechanizmy pozycjonowania stron.

SEO stało się z czasem bardziej skomplikowane, a na sukces wpływa ogromna liczba czynników. Naszym celem było zrozumienie, czy można wskazać te najważniejsze i najskuteczniejsze w kontekście TOP10 wyników wyszukiwania.

Warto wiedzieć

Przeprowadziliśmy kilka badań, na razie publikujemy pierwsze z nich — pozostałe jeszcze ciągle analizujemy.

2. Cel i metodologia

Główne założenia:

- Sprawdzenie czy istnieje korelacja między zewnętrznymi czynnikami SEO (niedotyczącymi konkretnej podstrony, a całego serwisu, np. liczba linków, czas ładowania, wielkość strony, optymalizacja pod konkretne frazy) a pozycją strony w wyszukiwarce.

- Sprawdzenie czy poprawa konkretnego elementu, np. linkowania zewnętrznego lub skracanie czasu ładowania na pewno przełoży się na pozycję w Google? I co to za element.

Długofalowy cel:

- Budowa asystenta, który będzie nie tylko wskazywał obszary do poprawy, ale także dostarczał trafne rekomendacje dla użytkowników, maksymalizując skuteczność ich działań SEO.

- Uczenie się wykorzystania zaawansowanych technologii (ML) do badania zależności — bo w przyszłości tylko w taki sposób będziemy w stanie skutecznie doradzać naszym klientom.

Analizowana próbka danych:

- 100 tysięcy wyników — po 100 wyników dla 1000 różnych fraz, zebranych z różnych branż i dotyczących różnych typów stron internetowych.

- Jako, że jest to nasze pierwsze tego typu zaawansowane badanie, skupiliśmy się na ograniczonej liczbie elementów — głównie zewnętrznych, takich jak: liczba linków zewnętrznych, czas ładowania strony, wielkość plików, częstotliwość słów kluczowych oraz jakość opisów meta.

Narzędzia i techniki:

- Analiza korelacji liniowej pomiędzy danymi występującymi w zbiorze za pomocą współczynnika korelacji liniowej Pearsona.

- Wizualizacja danych (macierz korelacji).

- Wykorzystanie trybu o1-pro w ChatGPT do wtórnej analizy korelacji i weryfikacji naszych wniosków.

Wyzwania:

- Weryfikacja możliwości modelowania danych za pomocą regresji liniowej.

3. Dlaczego badamy korelację?

Dlaczego badamy akurat korelację (i tylko ją) i jak ma się ona do wpływu poszczególnych czynników na pozycję w Google?

Korelacja opisuje związek między dwiema zmiennymi, wskazując, czy zmiany jednej współwystępują ze zmianami drugiej, ale nie oznacza przyczynowości.

W kontekście czynników rankingowych i pozycji w Google badanie korelacji pozwala określić, które czynniki mogą być powiązane z lepszymi wynikami.

Taka analiza korelacji jest więc punktem wyjścia do dalszych badań nad wpływem.

Jeśli występuje znacząca korelacja, można przeprowadzić eksperymenty lub analizy przyczynowe, aby sprawdzić, czy dany czynnik rzeczywiście wpływa na pozycję w wyszukiwarce.

Nie warto zaczynać od razu od badania wpływu, ponieważ jest to proces złożony, czasochłonny i przez to też po prostu drogi. Badanie korelacji jest prostsze, a przez to szybsze do sprawdzenia — no i pozwala wstępnie określić, czy istnieje jakiś bezpośredni związek między zmiennymi.

Zazwyczaj dopiero silna korelacja informuje, że warto inwestować czas i pieniądze w dalsze badania nad wpływem. Brak korelacji zazwyczaj oznacza z kolei brak wpływu, ale są wyjątki.

Mimo braku korelacji może wystąpić wpływ przy zależnościach nieliniowych lub ukrytych zmiennych (czemu - tutaj od razu zdradzę: przyglądamy się w kolejnych badaniach, bo zapewne tak właśnie jest w przypadku Google).

Tutaj badaliśmy jednak, zgodnie z założeniami: to, czy zmiana pojedynczego czynnika może wpłynąć na pozycję: np. czy samo pozyskanie linków w określony sposób lub wdrożenie optymalizacji technicznej pozwoli zdobyć wysoką pozycję.

4. Wyniki badania

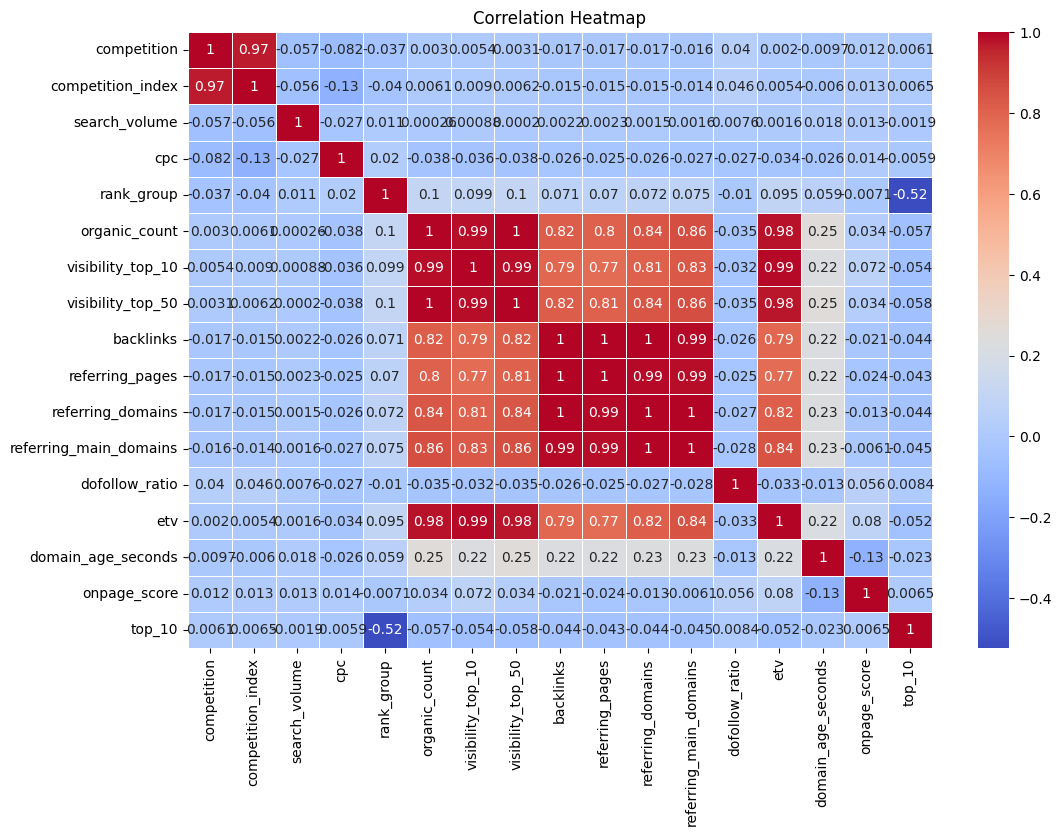

Poniżej macierz korelacji czynników, które wzięliśmy pod uwagę w naszym badaniu:

Macierz korelacji wykazała, że współczynniki dla kluczowych zmiennych były bliskie 0. Oznacza to brak silnej zależności liniowej między czynnikami zewnętrznymi a pozycją strony.

Przykład: Liczba linków zewnętrznych, która kiedyś decydowała o sukcesie, nie gwarantuje obecnie pojawienia się strony w TOP10.

Korelacja dodatnia występuje, ale na poziomie 0.01 - 0.1 na czynnik. Wynika z tego, że najprawdopodobniej podstawowe czynniki badane tutaj nie mają znaczącego samodzielnego wpływu na pozycję.

Minimalna korelacja wskazuje jednak, że dane mają znaczenie, ale jest ono bardzo rozproszone i musi być “wzmacniane” przez inne czynniki, np. analizę treści czy kliknięć.

Czynniki wykorzystane w badaniu

competition— konkurencyjność badanego słowa kluczowego,competition_index— konkurencyjność badanego słowa kluczowego na podstawie zajętych slotów reklamowych,search_volume— potencjał słowa kluczowego (liczba zapytań miesięcznie),cpc— cost per click badanego słowa kluczowego,rank_group— pozycja zajmowana przez stronę w wyszukiwarce na badane słowo kluczowe,organic_count— liczba zindeksowanych podstron serwisu, którego pozycja była badana,visibility_top_10/50— widoczność serwisu w TOP10/50 (liczba fraz, na które widać stronę w danym przedziale pozycji),backlinks— liczba linków zewnętrznych przychodzących do domeny,referring_pages— liczba podstron odsyłających od domeny za pomocą linków zewnętrznych,referring_domains— liczba domen i subdomen odsyłających do domeny za pomocą linków zewnętrznych,referring_main_domains— liczba domen odsyłających do domeny,dofollow_ratio— proporcja linków przychodzących oznaczonych jako rel=dofollow do tych oznaczonych jako rel=nofollow,etv— szacowany ruch organiczny w całej domenie,domain_age_seconds— wiek domeny w sekundach (data pobrania minus data rejestracji w DNS),onpage_score— ocena ogólnej optymalizacji technicznej podstrony, na którą składają się meta tagi, atrybuty ALT, linki kanoniczne itd.,top_10— oznaczenie czy badana strona zajmuję pozycję w TOP10 na frazie.

5. Wnioski

Oprócz tego, że programista ML przekazał mi swoje wnioski i sam przeanalizowałem dane, do analizy przetestowałem także udostępniony ostatnio przez OpenAI ChatGPT Pro. Oferuje on dostęp do trybu o1-pro, który wykorzystuje większą moc obliczeniową, aby udzielać odpowiedzi na najtrudniejsze pytania.

1. Domeny o dużej widoczności mają dużo backlinków, ale backlinki te nie przekładają się wyraźnie na pozycje.

Z badania wynikła silna dodatnia korelacja pomiędzy visibility_top_10/50 a liczbą backlinków i innych powiązanych metryk (np. referring_domains). Oznacza to, że domeny o większej widoczności mają zwykle więcej linków przychodzących.

Jednocześnie top_10 (czyli fakt bycia w top 10 dla konkretnej frazy) i rank_group (pozycja) nie koreluje istotnie z liczbą backlinków.

Możemy więc wnioskować, że liczba backlinków sama w sobie nie przekłada się wyraźnie na obecność w TOP10 czy zajmowaną pozycję.

2. Wiek domeny nie oddziałuje bezpośrednio na pozycję

Korelacja między domain_age_seconds a rank_group jest bardzo niska (ok. 0,0668), co oznacza praktycznie brak liniowej zależności wieku domeny z konkretną pozycją.

Zauważalna jest natomiast lekka dodatnia korelacja pomiędzy wiekiem domeny a jej ogólną widocznością (ok. 0,23 z visibility_top_10 i visibility_top_50).

Wskazuje to, że starsze domeny mają nieco większą widoczność i więcej zindeksowanych podstron (bo dłużej istnieją, więc często są po prostu bardziej rozbudowane), ale sam ten fakt niekoniecznie przekłada się to na lepszą pozycję dla pojedynczych fraz.

3. Większa konkurencyjność frazy nie sprawia, że strony w wynikach mają więcej backlinków.

Zależność między competition/competition_index a liczbą backlinków jest bliska zeru (-0,015/-0,017).

Na podstawie tego można przypuszczać, że linki zewnętrzne same w sobie nie są dla Google sygnałem o wysokim autorytecie czy wiarygodności serwisu.

Brak korelacji między tymi danymi wskazuje też na fakt, że pozycjonowanie na bardziej konkurencyjną frazę wcale nie oznacza, że trzeba mieć więcej (lub mniej) backlinków.

4. Liczba domen odsyłających nie świadczy o “jakości” linków zwrotnych.

Korelacja rank_group z referring_domains lub referring_main_domains jest bardzo niska (ok. 0,07), co sugeruje brak istotnego wpływu liczby domen odsyłających (domen, które linkują do strony) na pozycję.

5. Rosnący stosunek linków dofollow do nofollow również nie wiąże się z rosnącą pozycją.

Korelacja dofollow_ratio z rank_group jest bliska zeru (-0,01). Można więc stwierdzić, że proporcja linków dofollow do linków nofollow nie ma praktycznie żadnego związku z pozycja.

6. Ze wzrostem pozycji nie jest także powiązana bezpośrednio sama optymalizacja techniczna.

Korelacja onpage_score z rank_group jest praktycznie zerowa (ok. 0,007). Wynika z tego, że podobnie jak przy backlinkach, sam ogólny poziom optymalizacji technicznej podstrony również nie wiąże się ze wzrostem jej pozycji.

Sama optymalizacja techniczna to więc za mało żeby zdobyć wysoką pozycję. To zresztą zrozumiałe, bo elementy te są obecnie często zautomatyzowane w CMS’ach. No i w dużej mierze nie stanowią wartości dla użytkownika.

Dodatkowo zauważyłbym też, mało która strona dzisiaj ma bardzo mocno odbiegającą od normy ocenę optymalizacji technicznej (praktycznie w wynikach nie ma stron poniżej wyniku 85). O wiele aspektów (np. canonicale) dbają już platformy, albo sam Google (dynamiczne description).

7. Większy potencjał słowa kluczowego nie zawsze oznacza większą konkurencyjność

Co może zaskakiwać na pierwszy rzut oka, korelacja pomiędzy search_volume a competition jest bliska zeru, a nawet delikatnie ujemna (ok. -0,059). Oznacza to, że większy potencjał frazy niekoniecznie wiąże się z większą konkurencyjnością.

Na ten wniosek składa się kilka czynników.

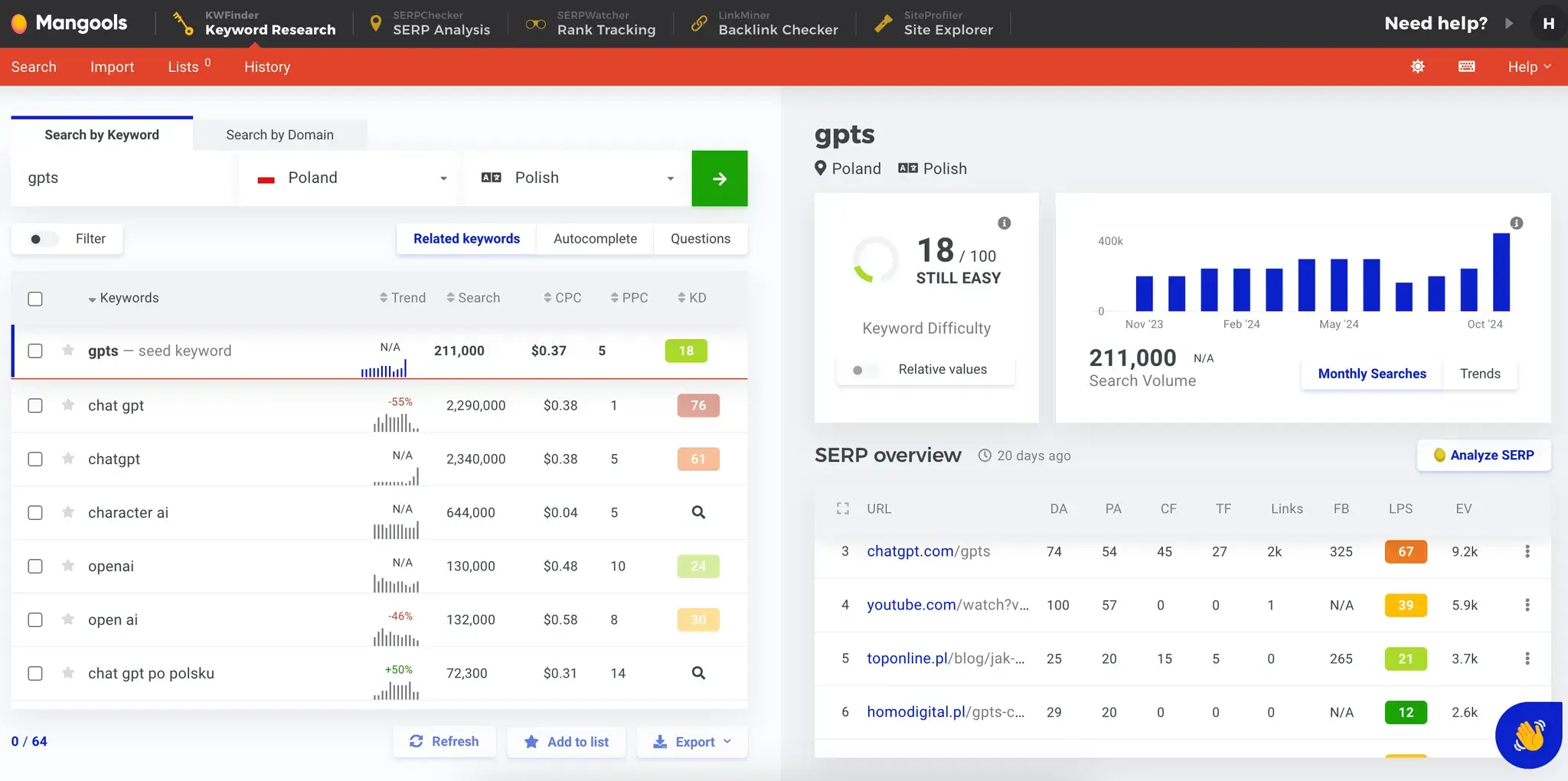

Po pierwsze dobór fraz do badania — który był losowy, a przez to bardziej reprezentatywny, bo nie zawiera np. połowy fraz o dużym potencjale, a połowy fraz long tail.

Po drugie fakt, że narzędzia określają czasami ogólne lub dosyć nowe frazy jako łatwe do wypozycjonowania się lub mało konkurencyjne.

Przykładem takiej frazy jest “gpts”, czyli fraza o przepotężnej liczbie wyszukiwań, ale również dosyć niskiej konkurencyjności (według narzędzi):

No i po trzecie: kwestia samego wzrostu potencjału w zestawieniu z wzrostem konkurencyjności.

O ile np. fraza o potencjale 100 tys. wyszukiwań miesięcznie będzie zwykle bardziej konkurencyjna niż fraza o potencjale 100 wyszukiwań miesięcznie, o tyle różnica konkurencyjności pomiędzy 100, 200, 1000, albo 5000 wyszukiwań zwykle nie wzrasta już liniowo.

8. Im więcej fraz na wysokich pozycjach, tym większy całkowity ruch.

Ten punkt nie jest odkryciem, ale potwierdza, że dane nie są błędne.

Pomiędzy etv a visibility_top_10 oraz visibility_top_50 występuje bardzo silna korelacja dodatnia (ok. 0,99). Ten związek jest bardzo wyraźny.

9. Im większy serwis (więcej zaindeksowanych stron) tym większy przewidywany ruch (etv) i większa widoczność.

To również żadne odkrycie, ale również potwierdza poprawność danych.

Silna dodatnia korelacja tych danych jest jak najbardziej właściwa — bo właśnie tak działa pozycjonowanie — zazwyczaj im więcej podstron, tym większa widoczność i większy ruch.

O ile oczywiście te podstrony są zoptymalizowane, a nie tylko utworzone, ale to już oczywiste.

10. Nie trzeba mieć dużej widoczności, żeby zdobywać pozycje w TOP10.

Korelacja pomiędzy top_10 a visibility_top_10 jest bardzo słaba (ok. -0,054).

W naszym badaniu wychodzi więc na to, że w TOP10 równie dobrze może znaleźć się landing page, mała firmowa strona-wizytówka, jak i ogromny sklep internetowy. Co jest w sumie bardzo logiczne.

Kwestia tego, jak sama widoczność serwisu może oddziaływać na pozycję na frazie wymaga jeszcze dodatkowego przebadania — bo tutaj skupiliśmy się na losowych frazach, w których znalazły się serwisy z wielu różnych branż, nisz i tematyk.

Na to, że warto przeprowadzić takie dodatkowe badanie, np. na frazach z tylko jednej branży, wskazuje niewielka dodatnia korelacja widoczności (visibility_top10/50) z pozycją (rank_group) — wynosząca około 0,1.

6. Co nam to wszystko mówi?

- Zmiana jednego czynnika nie gwarantuje sukcesu.

- Intencja, kontekst i rozwój konkurencji w wyszukiwarce mają ogromne znaczenie.

- Skupienie na widoczności i dostarczeniu wartości jest kluczowe

- Brak inwestycji w (odpowiednie) SEO może sprawić, że w długim terminie (nawet pomimo dobrej widoczności teraz) nasze produkty czy usługi będą mniej widoczne (innymi słowy, konkurencja Cię wyprzedzi).

- Brak dostosowania strategii SEO do nowych trendów może mocno ograniczyć widoczność serwisu w przyszłości (znowu: konkurencja Cię wyprzedzi).

- OnPage score, czyli ogólny wynik technicznej optymalizacji danej podstrony też nie ma korelacji z wynikami — to oznacza, że na 100 pozycji może być bardzo dobrze zoptymalizowana strona, która jednak jest oceniona jako ta zawierająca słabszą odpowiedź według wyszukiwarki. Dodatkowo większość platform zapewnia już dosyć dobrą, podstawową optymalizację techniczną.

Inwestowanie głównie w jeden czynnik, np. linkowanie zew. może nie być dobrą strategią SEO.

Mówiąc inaczej: co działa dla jednej frazy, może być zupełnie nieskuteczne dla innej.

Brak wyraźnych korelacji wynika pewnie również z faktu, że o ile dawniej w Google było kilkadzisiąt czynników, tak teraz teraz jest ich tysiące, a AI sprawi, że będzie ich znaaaacznie więcej (patrz: hiperpersonalizacja).

Stąd bezpośredni wpływ czynników zewnętrznych na pozycję po prostu zmniejszył się w porównaniu z latami 2008-2012.

Algorytmy coraz lepiej rozumieją intencje użytkownika i dostarczają mu precyzyjne, wartościowe treści.

Wydaje się, że to właśnie na tych aspektach trzeba się skupić i w tym kierunku głównie inwestować... czyli precyzyjnie odpowiadać na wiele pytań i intencji użytkownika.

Tutaj muszę zaznaczyć, że nasze badanie dotyczy głównie czynników zewnętrznych, ale chyba już i tym jasno pokazuje, że wartość jest wewnątrz — ale to będziemy sprawdzać w kolejnych badaniach już niebawem :)

7. Luźne, dodatkowe przemyślenia z którymi Was zostawię…

- Zmiana reguł gry:

- Technologia daje przewagę:

- Intencja użytkownika to przyszłość SEO

W dobie multimodalności i dążenia do hiperpersonalizacji czynniki zew. przestały być tak bardzo istotne — a na pewno nie są już tak istotne jak dekadę temu.

Dziś liczy się dostarczenie wartości użytkownikowi i to jest głównie oceniane przez wyszukiwarki. Pytanie tylko, jak ją dostarczyć, i co to oznacza w praktyce? Mam nadzieję, że następne badania nam to pokażą!

Systemy rankingowe są coraz bardziej skomplikowane, ale samo SEO jest coraz prostsze dzięki automatyzacja podstaw SEO. Każda platforma dba już o elementy, które kiedyś musieliśmy uzupełniać ręcznie — ale co też dawało kiedyś ogromną przewagę.

To jednak pozwala skupić się na strategicznych elementach — czyli właśnie dostarczeniu wartości w formie treści (nie tylko pisanej, bo multimodalność sprawi, że wyszukiwarki będą coraz lepiej indeksować inne formy contentu).

Ten temat postaram się dokładnie opisać w jednym z kolejnych artykułów.

W dobie transformacji i podążania w kierunku hiperpersonalizacji to właśnie intencja użytkownika (a właściwie jej odpowiednie spełnienie) staje się ważniejsza niż sama fraza, czynniki zewnętrzne czy optymalizacja techniczna.

8. Co dalej? Kontynuacja badań

Nie zamierzamy się zatrzymywać. Już przeprowadziliśmy kolejne analizy (ta jest pierwszą, którą zdecydowaliśmy się opublikować). W planach mamy też dogłębne badanie czynników wewnętrznych, takich jak jakość treści, struktura strony i dopasowanie do intencji użytkownika.

Twórz badania razem z nami!

Na koniec zachęcam ekspertów SEO (i nie tylko) do współpracy. Wasze pomysły mogą pomóc w planowaniu kolejnych badań.

Podsumowując: Masz pomysł na ciekawe badanie? Dołącz do SEO Samodzielnych i pomóż nam rozwijać przyszłość SEO.

Podsumowanie w punktach

- Nasze badanie powstało na potrzeby tworzenia Smart SEO Assistant – miało na celu sprawdzić, czy istnieją czynniki zewnętrzne, których poprawa gwarantuje wzrost pozycji.

- Przebadaliśmy 100 tys. wyników z użyciem wsp. korelacji liniowej Pearsona, skupiając się na czynnikach takich jak liczba backlinków, wiek domeny, widoczność strony w TOP10/50, szybkość ładowania czy ogólny poziom optymalizacji technicznej.

- Analiza korelacji wykazała, że czynniki takie jak liczba linków zewnętrznych, wiek domeny, ogólny poziom optymalizacji technicznej, czy liczba domen odsyłających mają minimalny wpływ na pozycję.

- Pozwala to wnioskować, że inwestowanie w jeden obszar, np. samo linkowanie lub samą optymalizację aspektów technicznych nie daje gwarancji sukcesu.

- Systemy rankingowe coraz lepiej rozumieją kontekst treści, dlatego Intencja użytkownika oraz wartość treści odgrywają w SEO coraz większą rolę.

- Ponadto SEO ewoluuje – tradycyjne czynniki zewnętrzne tracą na znaczeniu, a przyszłość należy do treści odpowiadających trafnie na intencje użytkownika.

- Wnioski z badania pokazują więc, że SEO to proces wielowymiarowy, wymagający strategicznego podejścia.

- “Zmiany zacznij od siebie i na sobie poprzestań” > można by powiedzieć, że zmiany zacznij od swojej strony, i na niej poprzestań.

- To pierwsze z naszych badań, które zdecydowaliśmy się opublikować – w zanadrzu mamy już kolejne, a planujemy też badania na czynnikami wewnętrznymi, takimi jak jakość treści czy struktura strony.

- Jeśli masz pomysł na ciekawe badanie, podziel się nim z nami na grupie SEO Samodzielnych na Facebooku!