Ponad połowa wyszukiwań w USA kończy się bez kliknięcia w wynik. GSC wysyła fałszywe powiadomienia. Google zaleca dwa pliki robots.txt przy korzystaniu z CDN. Oprócz tego: co robić, gdy Twoja strona rankinguje na losowe słowa kluczowe, co z tym Negative SEO i dłuższy pasek wyszukiwania w Google.

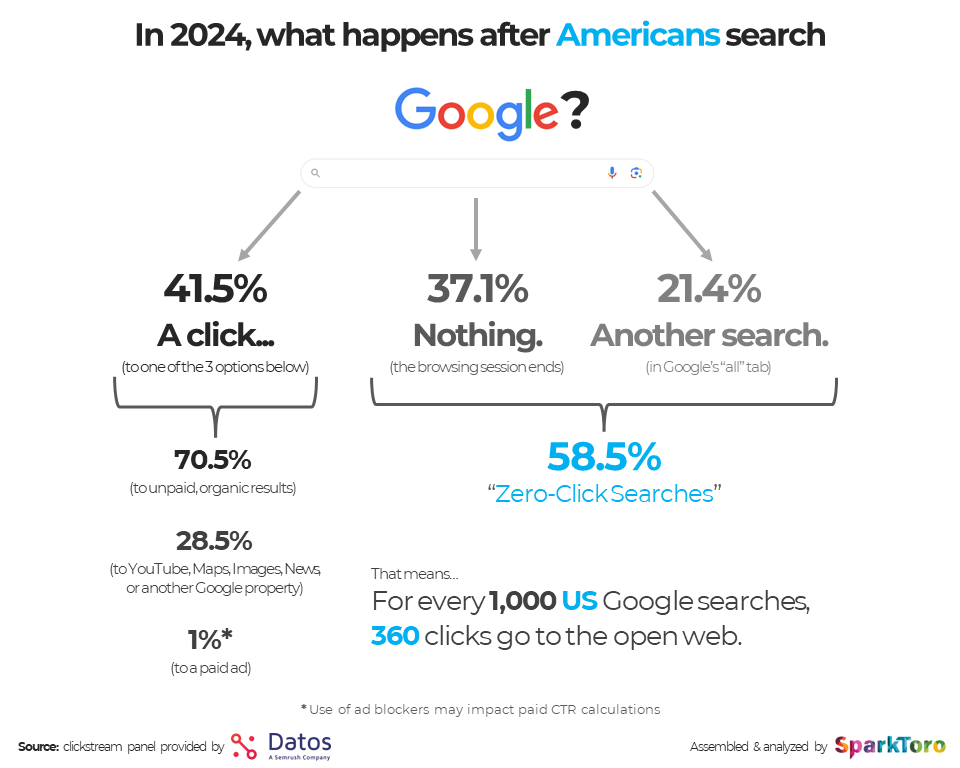

1. Ile wyszukiwań kończy się bez odwiedzenia strony?

58,5% – dokładnie taki jest udział wyszukiwań bez kliknięć w Google w Stanach Zjednoczonych.

Nieco ponad 37% wyszukiwań nie prowadzi do żadnej akcji (zamknięcie przeglądarki), a tylko 41,5% kończy się kliknięciem. To dane zebrane w ramach badania Zero-Click Search Study wykonanego przez Randa Fishkina.

Co ciekawe – badanie jasno wskazuje na poprawę zaangażowania użytkowników w stosunku do poprzedniego raportu z 2021. Odsetek wyszukiwań bez kliknięć wynosił wówczas 65%.

Fishkin zauważył też, że na każde 1000 wyszukiwań w USA tylko 360 kliknięć odsyła do witryn, które nie są powiązane z Google (np. YouTube) i system Google Ads.

Czego jeszcze się dowiadujemy? 70,5% użytkowników, którzy klikają w wyniki, przechodzi do stron wyświetlanych w bezpłatnych wynikach wyszukiwania. Do witryn w ekosystemie Google (Youtube, Google Maps itd.) przechodzi 28,5%, a tylko 1% klika w płatne reklamy w wyszukiwarce.

Dane z najnowszego raportu pokazują też pewne trendy związane z AI Overviews:

- liczba wyszukiwań na komputerach nieznacznie wzrosła,

- wyszukiwania na urządzeniach mobilnych drastycznie zmalały,

- zwiększyła się liczba wyszukiwań z kliknięciem na urządzeniach mobilnych,

- liczba wyszukiwań z kliknięciem na komputerach utrzymała się na tym samym poziomie.

W badaniu są również dostępne dane dotyczące aktywności użytkowników wyszukiwarki Google w Unii Europejskiej. Warto rzucić na nie okiem.

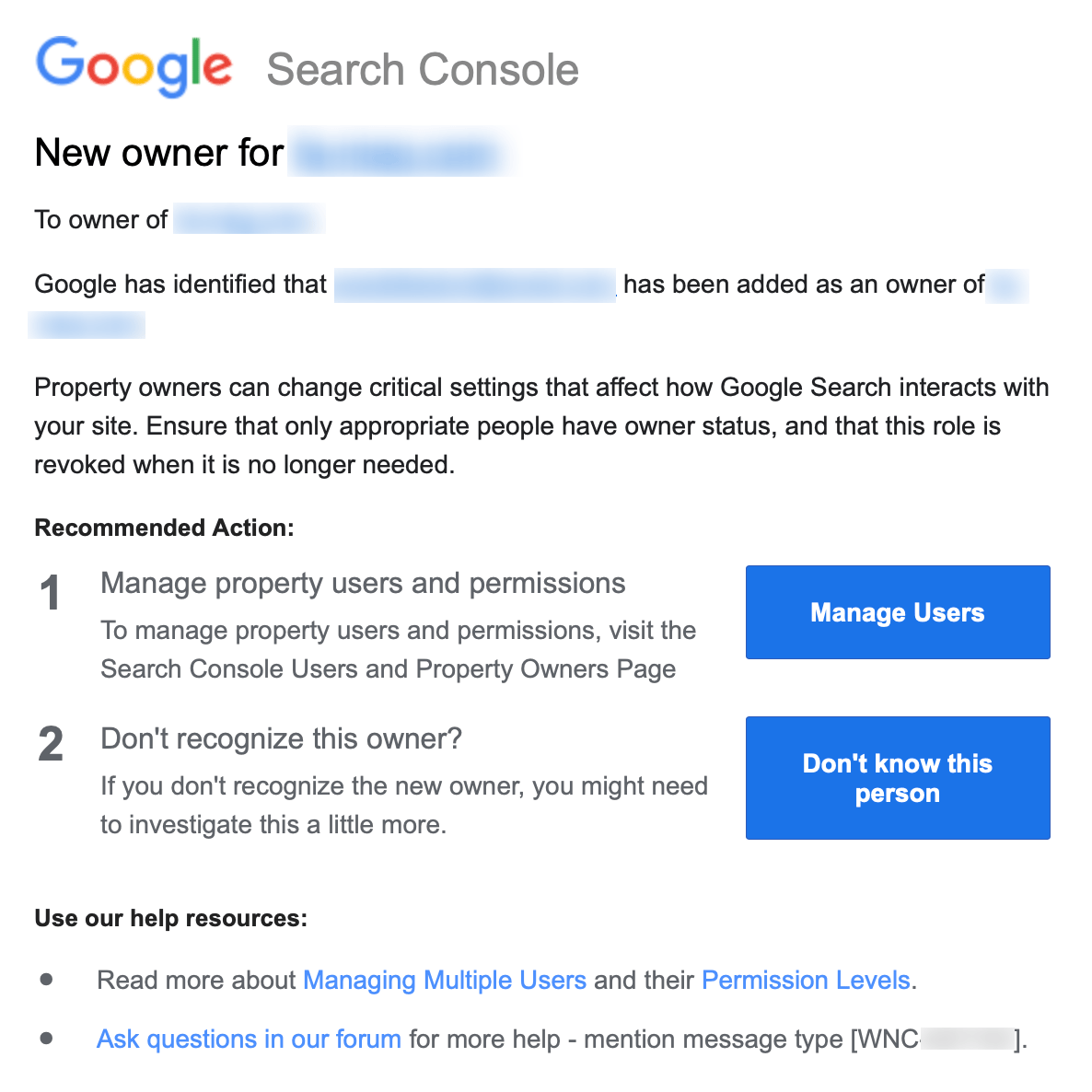

2. Błąd GSC związany z dodawaniem nowych (starych) użytkowników

Od zeszłego piątku pojawia się coraz więcej zgłoszeń od użytkowników, którzy otrzymują powiadomienia od Google dotyczące dodania nowych właścicieli do profili Google Search Console.

Nie byłoby w tym nic dziwnego, gdyby nie to, że powiadomienia są rozsyłane nawet kilka razy dziennie , a „nowi użytkownicy” to tak naprawdę osoby, które zostały dodane do profili GSC znacznie wcześniej – nawet kilka lat temu.

Tak wygląda powiadomienie mailowe, które otrzymują użytkownicy:

Dave Smart, czołowy komentator na forach Google, napisał, że te masowo wysyłane powiadomienia wydają się być częścią jakiegoś błędu. Zapewnił, że przekazał informację dalej. Póki co Google nie wypowiedziało się na ten temat.

3. Robots.txt w sieciach CDN, a nie na głównej domenie

Gary Illyes podzielił się nietypową, ale zgodną z najnowszymi standardami metodą centralizacji reguł robots.txt w obrębie CDN (content delivery network).

Gary wywołał na LinkedIn niemałą burzę dotyczącą prawidłowej lokalizacji plików robots.txt. Jak się bowiem okazuje, przy korzystaniu z CDN, wcale nie muszą być one umieszczane na głównej domenie – co zaprzecza powszechnej wiedzy o SEO.

Dopuszczalne jest posiadanie dwóch oddzielnych plików robots.txt – jednego na stronie głównej, a drugiego w sieci CDN.

Strona internetowa może posiadać więc 2 odrębne pliki robots.txt, np. pod takimi adresami:

- https://www.example.com/robots.txt

- https://cdn.example.com/robots.txt.

Jakie są plusy takiego rozwiązania?

Sprawniejsze aktualizacje i zarządzanie dyrektywami mniejsze ryzyko wystąpienia konfliktu dyrektyw między główną domeną a CDN-em.

Takie podejście umożliwia też bardziej elastyczną konfigurację w przypadku bardziej złożonych witryn.

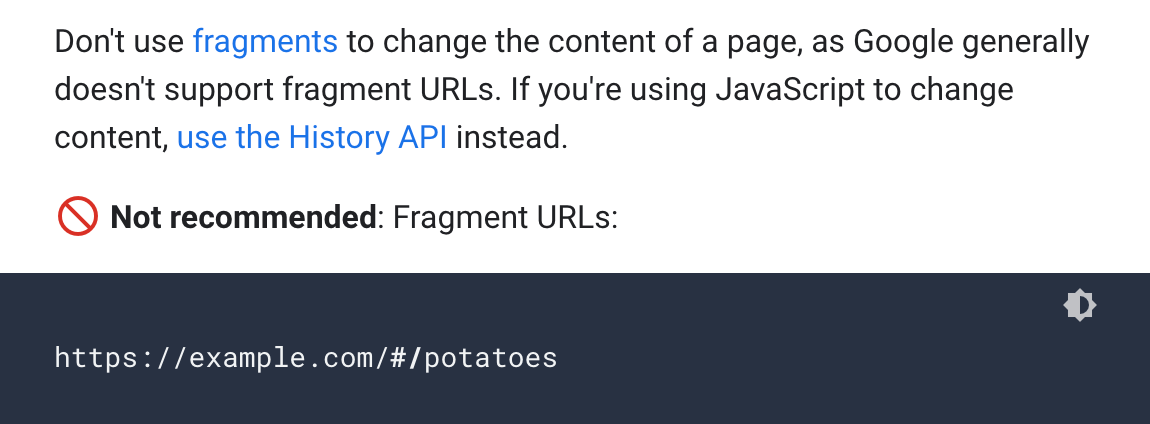

4. Google radzi, by nie używać fragmentów adresów URL do zmiany treści na stronach

Google zaktualizowało wytyczne dotyczące zalecanej struktury adresów URL, dostępne w oficjalnej dokumentacji wyszukiwarki.

Teraz mówią one, by „nie używać fragmentów do zmiany zawartości strony, ponieważ Google generalnie nie obsługuje fragmentów adresów URL”. Pada w nich też wzmianka o tym, by wykorzystywać History API zamiast JavaScipt w celu zmiany treści.

Zalecenia nie są nowe – w zmianach chodzi bardziej o uzupełnienie informacji dostępnych dla użytkowników.

Do tej pory zalecenia były widoczne tylko w dokumentacji JavaScript oraz witryn mobilnych. Teraz wytyczne są lepiej poukładane, co w teorii powinno ułatwić ich znalezienie.

Wspomnianą dokumentację znajdziesz tutaj.

5. John Mueller: wyświetlasz się na niepowiązane słowa kluczowe? Zoptymalizuj title i treść

Strona internetowa wyświetla się na dziwne, czasami zupełnie losowe i niezwiązane z branżą słowa kluczowe? Właśnie taki przypadek opisał jeden z użytkowników LinkedIn’a, który zapytał, co powinien zrobić, by temu zapobiec.

Pomoc nadeszła ze strony Johna Muellera z Google. Zaznaczył on, że w takiej sytuacji warto przyjrzeć się bliżej tytułowi i treści na stronie, i w miarę możliwości je zmienić. A mówiąc ściślej – sprawić, by były maksymalnie precyzyjne i jasne dla robotów indeksujących.

Mueller dodał, że czasami strony rankują na nieoczekiwane słowa kluczowe i nie da się temu zapobiec. Co jednak ważne, nie wpływa to negatywnie na pozycjonowanie. Równie dobrze można więc… nic z tym nie robić.

6. Dlaczego praktyki Negative SEO nie działają?

W świecie SEO wciąż istnieje wiele niedomówień w zakresie Negative SEO. Czy faktycznie jest się czego bać?

Wątpliwości rozwiał ostatnio Gary Illyes w wywiadzie na SERP Conf 2024. Mianowicie: Google mocno zaostrzyło wytyczne dotyczące oceny jakości linków.

Wyszukiwarka od dawna już bada kontekst linkującej oraz linkowanej witryny. Jeśli nie ma między nimi zgodności, to link nie jest brany pod uwagę w rankingu. Negative SEO nie ma więc prawa działać.

Jak mówi sam Gary:

“Na przykład, jeśli ktoś linkuje do twojej strony z kwiatami z kanadyjskiego kasyna, które sprzedaje viagrę bez recepty, to dlaczego mielibyśmy zaufać temu linkowi? Powiedziałbym, że nie przejmowałbym się tym.".

Link do wywiadu z Garym Illyesem znajdziesz tutaj.

7. Google testuje dłuższy pasek wyszukiwania

W Google testuje dłuższy pasek wyszukiwania, a także różne jego wariacje – w tym wypełnienie paska w kolorze szarym. Zmiany spostrzegli użytkownicy konta SERP Alerts i podzielili się nimi na X.

Dla porównania:

Google potwierdza, że dłuższy pasek wyszukiwania jest odpowiedzią na coraz bardziej rozbudowane zapytania użytkowników wyszukiwarki, co – jakby nie było – ma sens. Podejrzewam, że takie rozwiązanie może szybko się przyjąć.

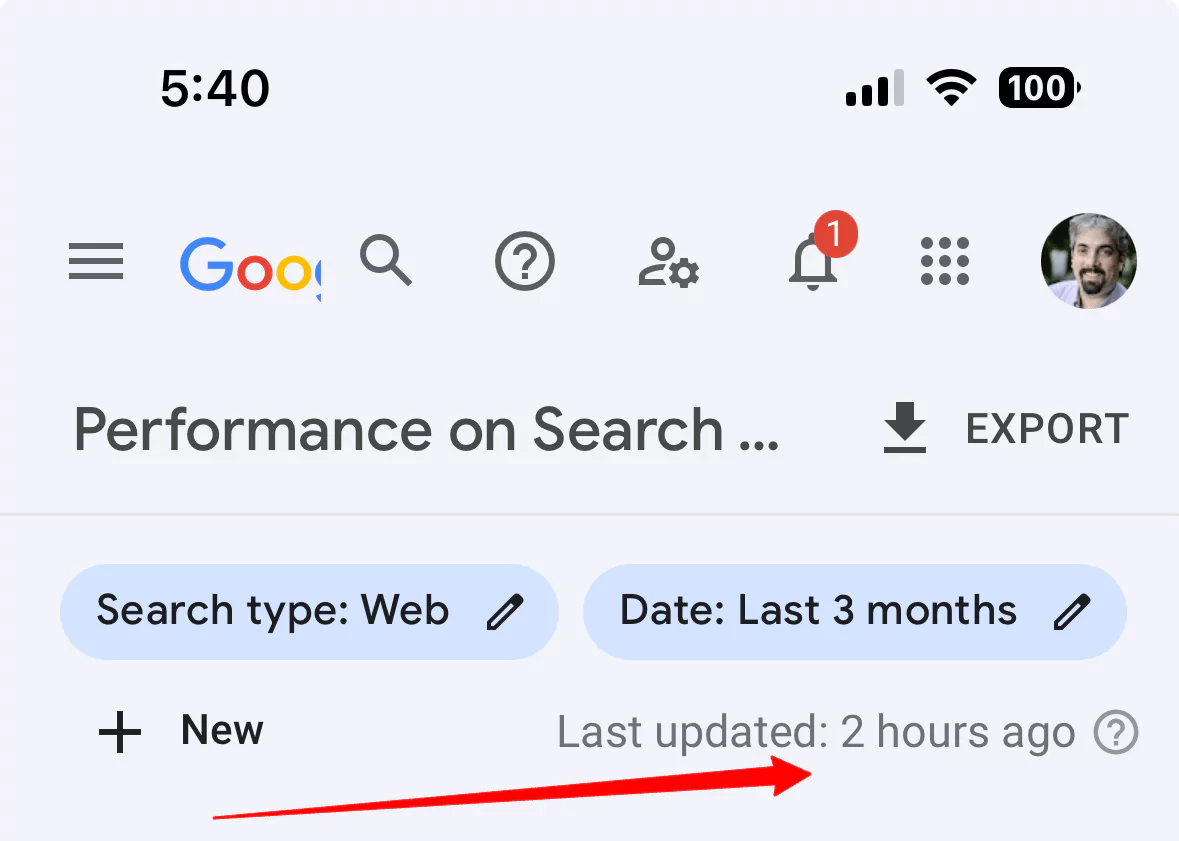

8. Raport Skuteczności wrócił do normy

W ostatnim wydaniu newsów (SEO News #142) pisałem o opóźnieniach w odświeżaniu raportu Skuteczności w GSC, które zaczęły pojawiać się od 30 czerwca.

Teraz wszystko wskazuje na to, że Google opanowało sytuację. Raporty zostały naprawione, zaktualizowane i są gotowe do analiz. Potwierdza to między innymi Search Engine Roundtable: