Google z oskarżeniami o monopol w Stanach Zjednoczonych. Mała liczba wyników AIO dla newsów. Konkurencyjne wyszukiwarki AI przegrywają z Google. Poza tym: Reddit blokuje dostęp dla Microsoftu, update algorytmów dotyczący deepfake’ów, funkcja Rekomendacji w GSC i problemy z autouzupełnianiem w wyszukiwarce.

1. Google naruszyło amerykańskie prawo antymonopolowe

Google zostało oskarżone o nielegalny monopol na rynku wyszukiwarek i reklam online w Stanach Zjednoczonych. Według sędziego federalnego Amita Mehty naruszono Sekcję 2. Ustawy Shermana.

Monopol Google na ogólne wyszukiwania wzrósł z ok. 80% w 2009 roku do 90% w 2020 roku.

Jednym z ważniejszych aspektów tej sprawy jest umowa między Google i Apple, w ramach której firma z nadgryzionym jabłkiem w logo otrzymuje rocznie 20 miliardów dolarów za promowanie Google jako domyślnej wyszukiwarki na iPhone’ach.

Orzeczenie Departamentu Sprawiedliwości uważane jest za pierwszy krok w kierunku ograniczenia monopoli technologicznych stosowanych przez gigantów tej branży – o co wnioskował już wcześniej rząd USA.

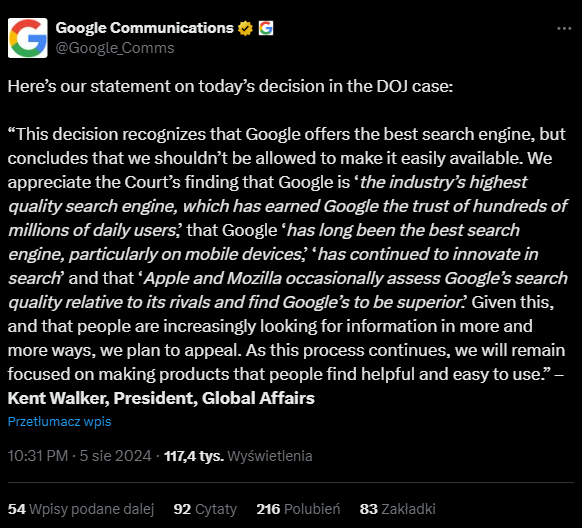

Google zamierza odwołać się od decyzji. Na platformie X pojawił się wpis, w którym firma argumentuje, że oferuje najlepszą wyszukiwarkę na rynku i nie powinna być karana za udostępnianie jej każdemu w łatwy sposób.

Czy w dłuższej perspektywie czasu zmieni się coś, jeśli chodzi o pozycjonowanie stron w Google? Czas pokaże – sprawa jest rozwojowa i zdecydowanie warto być z nią na bieżąco.

2. Mała liczba wyszukiwań Google AIO dla popularnych newsów

Wyniki Google AI Overviews pojawiają się jedynie na 3,9% zapytań dotyczących wiadomości krajowych i sportowych w USA. Takie wnioski płyną z analizy przeprowadzonej przez NewzDash.

Przez 9 tygodni badano ponad 10 000 słów kluczowych związanych z najczęściej wyszukiwanymi newsami z różnych kategorii.

Co jeszcze wiadomo? Wszystkie obserwowane wyniki AIO z kategorii „biznes” zostały wygenerowane automatycznie. Zapytania związane z branżą zdrowotną stosunkowo często wyzwalały odpowiedzi wspierane sztuczną inteligencją (widoczność na poziomie 29,6%).

Wnioski z badania pokrywają się z podejściem Google dotyczącym ograniczania wyników AI Overviews dla tematów informacyjnych, gdzie dokładność i aktualność danych są kluczowe.

To podejście wydaje się też odpowiadać na wcześniejszą krytykę dotyczącą potencjalnego rozpowszechniania dezinformacji przez funkcję AI Overviews.

3. Konkurencyjne wyszukiwarki AI przegrywają z Google

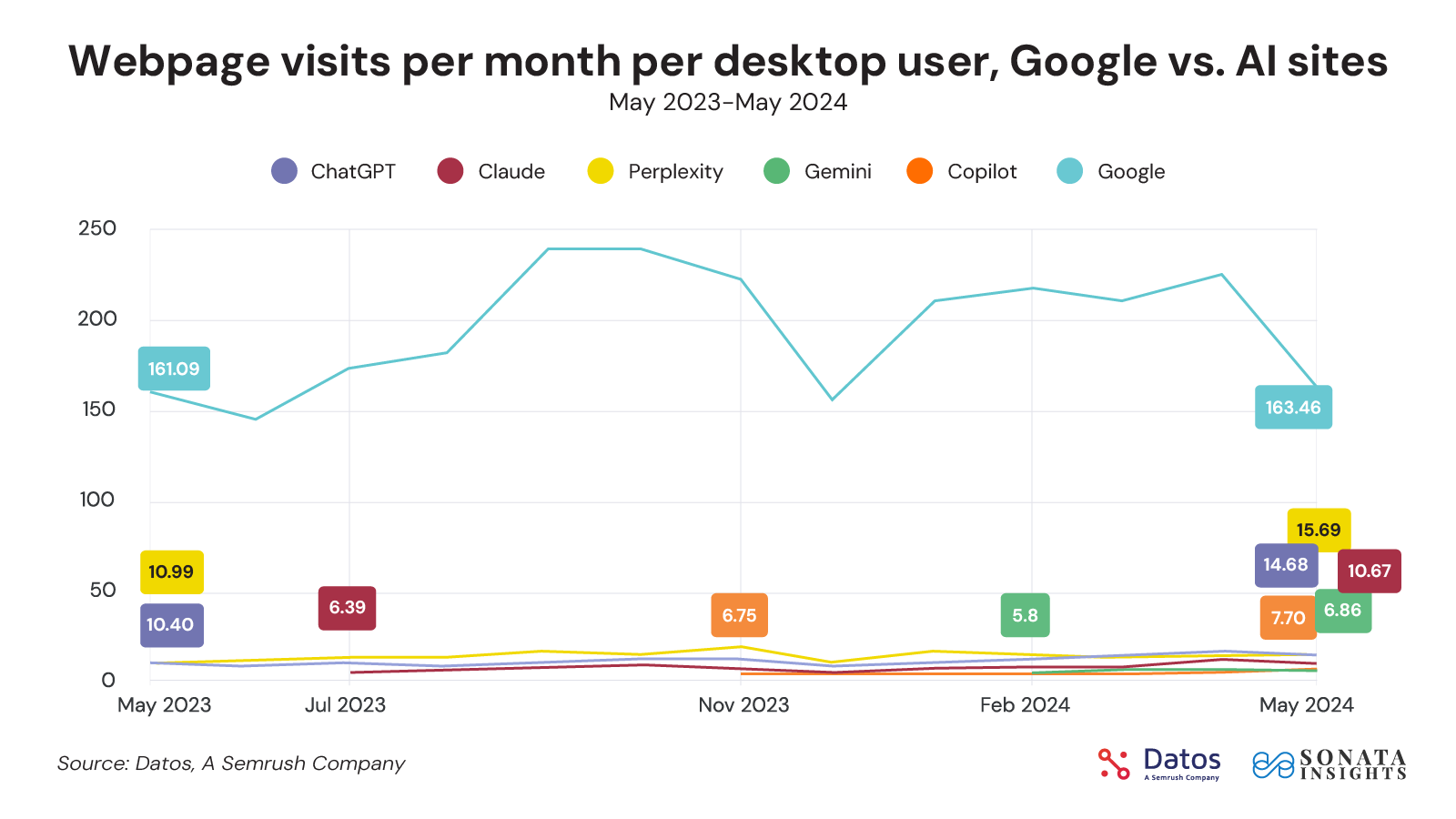

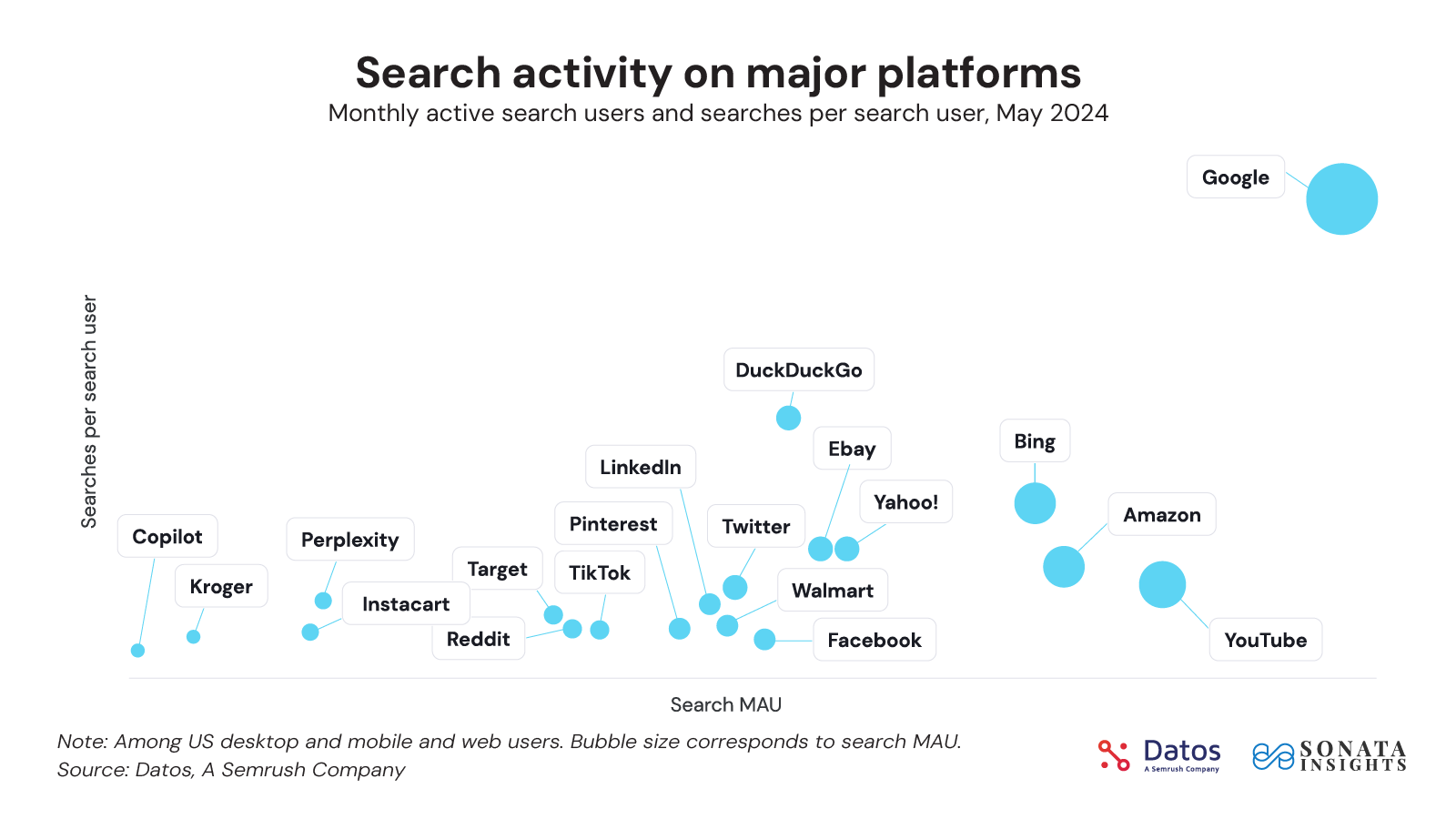

Ruch i zapytania w wyszukiwarce Google utrzymują się na wysokim poziomie pomimo coraz większej konkurencji ze strony narzędzi AI takich jak ChatGPT, Perplexity czy Copilot od Microsoftu.

Rand Fishkin na blogu Sparktoro przedstawił analizę danych dotyczących zachowań i preferencji użytkowników w zakresie wyszukiwania w erze AI. Informacje zostały zebrane przez firmę Sonata Insights.

Fishkin podkreślił, że w maju b.r. Google miało ponad 290 razy więcej użytkowników aktywnie korzystających z wyszukiwarki niż Perplexity, czyli jeden z największych rywali. Na jednego użytkownika w Google przypadało ok. 200 wyszukiwań miesięcznie, podczas gdy w Perplexity – 15.

Wyniki badania są ciekawe, bo pokazują, że nawet przy wszystkich dostępnych funkcjach wyszukiwania AI i zaawansowanych narzędziach wykorzystujących sztuczną inteligencję Google wciąż jest w stanie utrzymać dominującą pozycję na rynku.

4. Reddit blokuje Microsoft oraz wyszukiwarki AI przed skanowaniem swoich treści

Reddit nadal będzie blokować dostęp do swoich treści dla Microsoftu oraz narzędzi i wyszukiwarek AI – powiedział magazynowi The Verge Steve Huffman, CEO serwisu.

Reddit zablokował możliwość skanowania zawartości strony za pośrednictwem zaktualizowanego pliku robots.txt. Stało się to dokładnie 1 lipca tego roku.

Według Huffmana treści na Reddicie nie są darmowe, a podmioty, które chcą uzyskać do nich pełny dostęp, powinny zawrzeć odpowiednie umowy licencyjne.

„Bez tych umów nie mamy nic do powiedzenia ani wiedzy o tym, jak nasze dane są wyświetlane i do czego są wykorzystywane, co postawiło nas w sytuacji, w której musimy blokować tych, którzy nie byli skłonni dojść do porozumienia w sprawie tego, jak chcielibyśmy, aby nasze dane były wykorzystywane lub nie.”

Z tym twierdzeniem nie zgadza się szef działu AI Microsoftu Mustafa Suleyman, który określił wszystkie treści internetowe mianem „freeware” – dostępnych dla każdego za darmo.

Blokada Reddita dotyczy nie tylko Microsoftu, ale również takich narzędzi AI jak Anthropic czy Perplexity.

Problem nie dotyka jednak Google, które zawarło z Redditem umowę licencyjną opiewającą na kwotę 60 milionów dolarów rocznie (SEO News #124).

Pełny wywiad CEO Reddita z magazynem The Verge znajdziesz tutaj.

5. Nowe aktualizacje algorytmów wyszukiwania Google dotyczące deepfake’ów

Google wyjaśnia zmiany w działaniu algorytmów, których celem jest skuteczniejsza walka z deepfake’ami.

O aktualizacjach systemów rankingowych poinformowała Emma Higham (Product Manager w Google). Ich celem jest obniżenie pozycji stron zawierających deepfake’i. Wprowadzono również możliwość ręcznego usuwania takich treści z wyszukiwarki.

Zmiany w algorytmach dotyczą:

- Promowania witryn informacyjnych w wynikach wyszukiwania nad stronami z deepfake’ami.

- Rozróżniania prawdziwych zdjęć prezentujących nagie sceny od sfabrykowanej pornografii.

- Uczenia się na podstawie analizy wzorców – jeśli dana witryna zawiera dużo podstron z podejrzanym contentem, będzie to sygnał dla Google, że nie jest to strona wysokiej jakości i prawdopodobnie spadnie w rankingu.

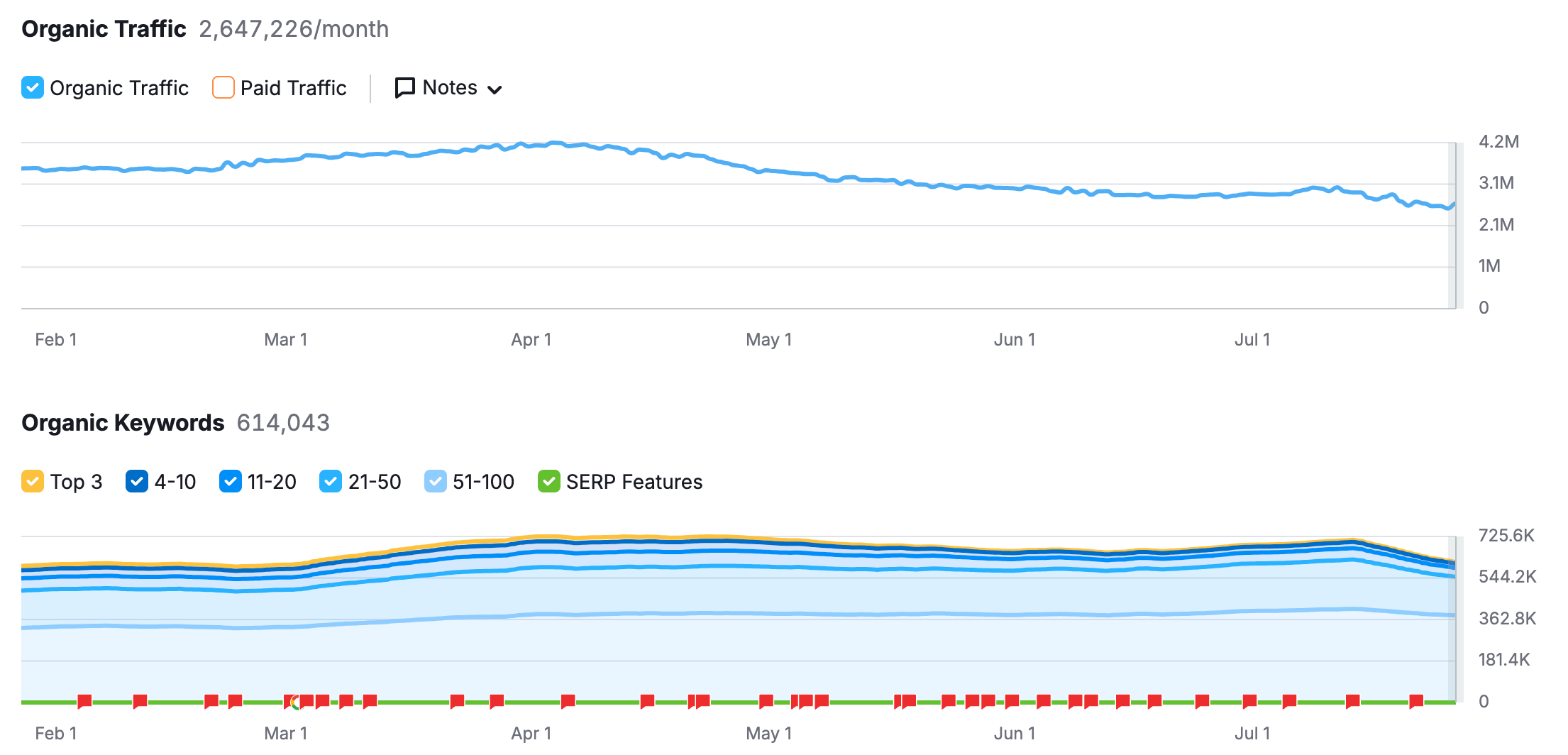

Przykładem witryny, która mocno ucierpiała w wyniku tych aktualizacji jest Mrdeepfakes.com. Odnotowała ona spadek widoczności o ok. 40% w porównaniu z wynikami z kwietnia tego roku.

Google usprawniło również proces wnioskowania o usunięcie fałszywych zdjęć. Wyniki będą filtrowane nie tylko na zgłoszonej stronie, ale również w innych witrynach zawierających tę grafikę. Wnioski można składać na oficjalnej stronie pomocy Google.

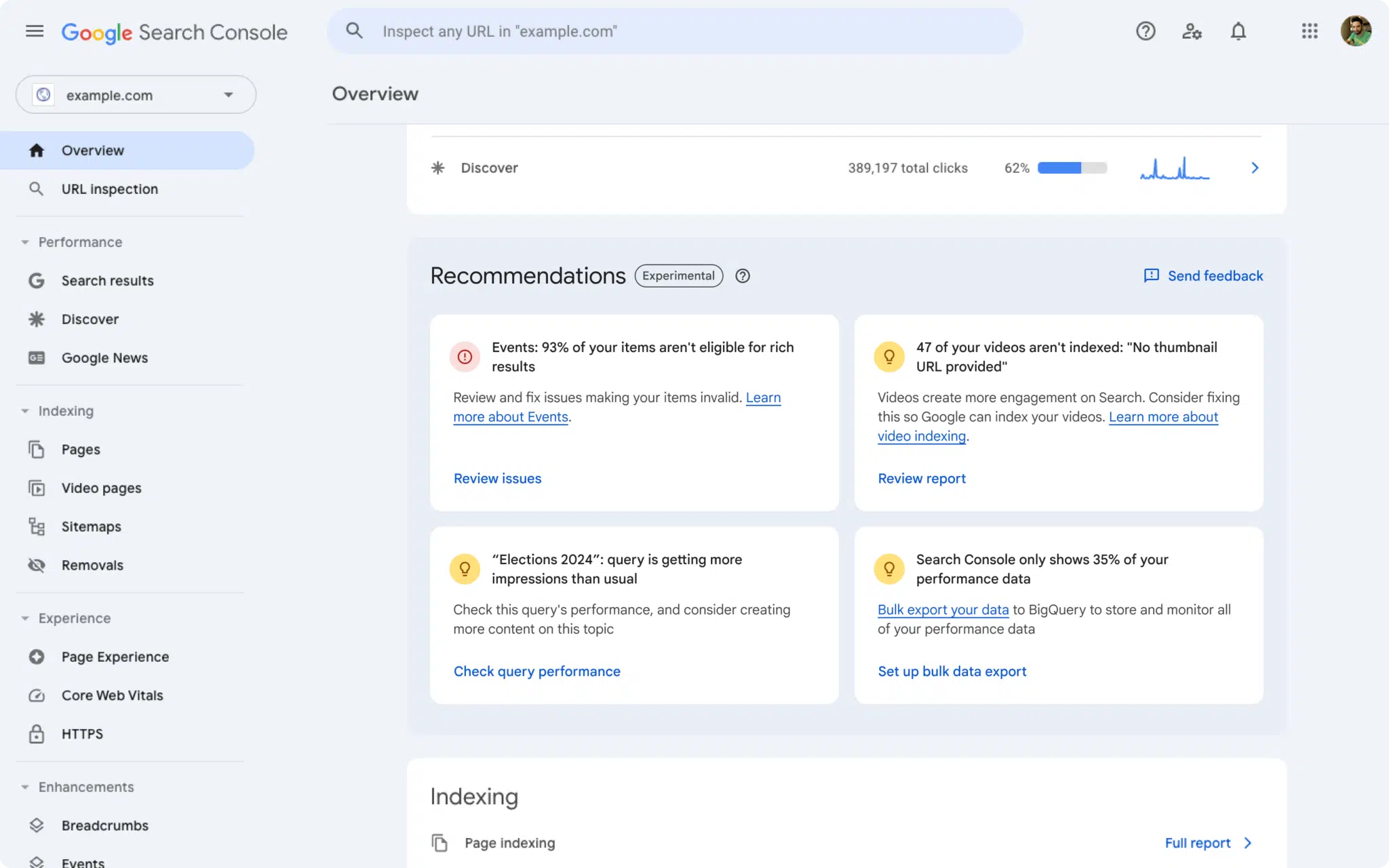

6. Funkcja Rekomendacje w GSC

Google eksperymentuje z nową funkcją w GSC. Opcja o nazwie „Rekomendacje” umożliwia podgląd sugestii, które mają pomóc stronom w osiągnięciu lepszych wyników w wyszukiwarce.

Dzięki Rekomendacjom użytkownicy otrzymają porady dotyczące możliwości optymalizacyjnych oraz propozycje działań, które mogą wykonać, aby poprawić pozycje swojej strony w Google.

Sugestie zbierane i wyświetlane są na podstawie danych z GSC. Google zamierza prezentować je teraz w bardziej przystępny sposób, wykorzystując do tego wspomniane narzędzie.

Rekomendacje to funkcja eksperymentalna i nie jest na razie dostępna dla każdego. Więcej informacji znajdziecie w centrum pomocy Google.

7. Autouzupełnianie w wyszukiwarce i obawy użytkowników

Google odpowiedziało na zarzuty niektórych użytkowników, którzy przypomnieli ostatnie problemy z działaniem funkcji autouzupełniania w kontekście zapytań o tematyce politycznej w USA.

Problemy były 2: brak wyświetlanych podpowiedzi dla wybranych polityków oraz brak sugestii dla zapytań związanych z niedawnym zamachem na byłego prezydenta Donalda Trumpa.

Google podkreśla, że opcja autouzupełniania to tylko narzędzie pozwalające szybko uzupełnić wyszukiwanie – i jako takie ma swoje bolączki. Każdy użytkownik zawsze może wyszukać interesujące go zapytanie, bez względu na działanie tej funkcji.

Problemy mogły być związane z wbudowanymi zabezpieczeniami w kontekście tematów dotyczących przemocy politycznej. Aktualnie trwają prace nad aktualizacjami algorytmów odpowiedzialnych za działanie funkcji autouzupełniania. Część z nich została już wdrożona.

8. Google potwierdza, że robots.txt nie chroni przed nieuprawnionym dostępem

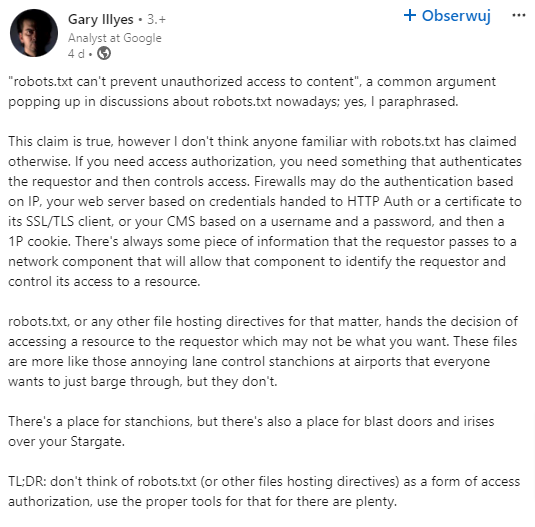

Gary Illyes z Google opublikował na LinkedIn wpis, w którym odniósł się do powszechnej teorii dotyczącej plików robots.txt w kontekście blokowania dostępu do stron.

Illyes zaznaczył, że robots.txt ma ograniczoną kontrolę nad nieautoryzowanym dostępem przez roboty sieciowe.

„Robots.txt nie może zapobiec nieautoryzowanemu dostępowi do treści – to powszechny argument pojawiający się w dyskusjach na temat robots.txt w dzisiejszych czasach; tak, sparafrazowałem. To twierdzenie jest prawdziwe, jednak nie sądzę, aby ktokolwiek zaznajomiony z robots.txt twierdził inaczej.”

W poście pada stwierdzenie, że proces blokowania zasobów poprzez pliki robots.txt działa na zasadzie kontroli dostępu, podobnie jak firewalle czy ochrona hasłem.

Według Illyesa nie można traktować robots.txt ani żadnych innych plików z dyrektywami hostingowymi jako formy autoryzacji dostępu do witryny. W tym celu warto skorzystać z odpowiednich narzędzi, działających np. na poziomie serwera.