Cloudflare proponuje nowe dyrektywy w robots.txt, które mają pozwolić wydawcom blokować wykorzystanie treści przez AI. OpenAI buduje zespół do stworzenia ekosystemu reklamowego w ChatGPT. Google rozwija AI Mode o funkcje agentowe. Poza tym – poprawne schema zwiększają szanse strony na pojawienie się w AIO, optymalizacja indeksacji poprawia widoczność strony w wyszukiwarkach AI, a także czy stosowanie wielkich liter w meta title zapewnia wyższy CTR.

1. Cloudflare chce dać możliwość zablokowania AI Overviews

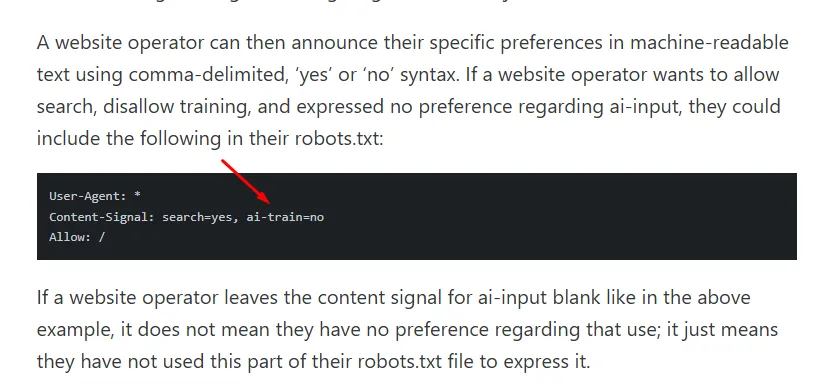

Cloudflare zaprezentował nowe rozszerzenia do pliku robots.txt, które mają pomóc wydawcom w kontrolowaniu wykorzystania ich treści przez narzędzia AI. Dzięki tym nowym dyrektywom można osobno określić, czy materiały mogą być:

- Indeksowane i wykorzystywane w klasycznym wyszukiwaniu (search).

- Używane jako dane wejściowe do generowania odpowiedzi przez modele AI (ai-input).

- Wykorzystywane do trenowania modeli AI (ai-train).

Firma planuje automatycznie wdrożyć nowe zasady dla milionów stron. Propozycja została udostępniona na licencji CC0, aby zwiększyć szanse na przyjęcie jej jako branżowego standardu.

Problem w tym, że nie ma pewności, czy najwięksi gracze – w tym Google – będą respektować te sygnały. Pamiętajmy, że robots.txt jest w zasadzie tylko dobrowolnie przyjętym standardem.

W efekcie wydawcy zyskują nowe narzędzie, ale nie gwarancję, że ich treści faktycznie nie zostaną wykorzystane do zasilania AI Overviews czy trenowania modeli LLM.

Cloudflare podkreśla, że ruch botów może wkrótce przewyższyć ruch użytkowników, a kontrola nad tym, jak wykorzystywane są treści, staje się coraz ważniejsza.

Pojawiają się sugestie, żeby obok nowych sygnałów stosować także zarządzanie botami i reguły firewall, by skuteczniej chronić swoje zasoby.

To nie pierwszy raz, kiedy Cloudflare stara się ograniczyć wpływ narzędzi AI na skanowanie i indeksowanie stron ich klientów. Niedawno pisałem o tym, że Perplexity dostało od nich bana za rzekome ignorowanie reguł blokujących dostęp botom PerplexityBot i Perplexity-User.

2. OpenAI szuka nowych pracowników – specjalistów od ekosystemów reklamowych

OpenAI coraz wyraźniej stawia na monetyzację swojego flagowego narzędzia AI. Potwierdzają się więc zapowiedzi z kwietnia tego roku, kiedy pisałem o planach wprowadzenia reklam w ChatGPT dla użytkowników darmowego planu.

Firma prowadzi obecnie rekrutację specjalistów, którzy mają pomóc w przekształceniu najpopularniejszego na świecie czata AI w pełnoprawną platformę reklamową.

Z ofert pracy wynika, że nowy zespół zajmie się budową infrastruktury marketingowej: od API i systemów pomiarowych, przez narzędzia do prowadzenia kampanii, aż po integracje z zewnętrznymi platformami reklamowymi.

Cel wydaje się oczywisty – wykorzystanie ogromnej bazy użytkowników. Z ChataGPT korzysta dziś ok. 700 milionów osób tygodniowo, a reklamy mogłyby stać się głównym źródłem przychodów, zwłaszcza w darmowej wersji narzędzia.

Na razie nie wiadomo, jak będą wyglądały same formaty reklamowe ani jak zostanie rozwiązana kwestia przejrzystości wyników i ogólnie UX.

Jedno jest pewne – wejście OpenAI w świat reklamy może otworzyć dla marek zupełnie nowy kanał komunikacji. Z drugiej strony pojawią się też pewnie pytania o etykę, skuteczność i wpływ na odbiór samego ChatGPT jako kolejnego narzędzia reklamowego.

3. W AI Mode pojawiają się funkcje agentowe

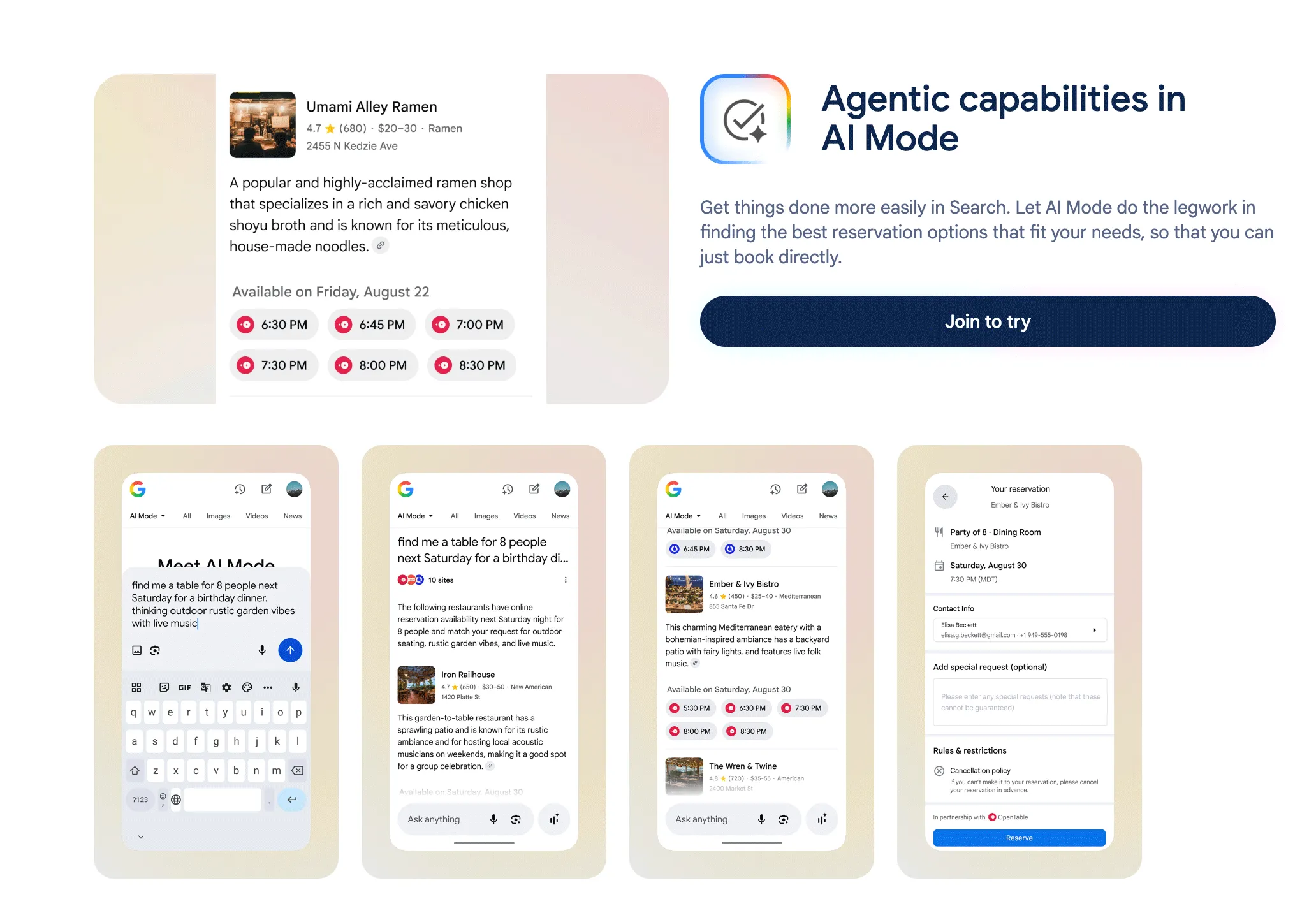

Google ogłosiło kolejne rozszerzenie funkcji AI Mode w Search Labs. Nowością jest opcja agenta, która pozwala wyszukiwarce nie tylko odpowiadać na pytania, ale także wykonywać zadania w imieniu użytkownika.

Może to wyglądać tak: załóżmy, że chcesz zrobić rezerwację w restauracji. Wystarczy, że wpiszesz zapytanie w stylu „znajdź stolik dla 2 osób w piątek po 18:00 w okolicach [X], najlepiej ramen”.

Tryb AI przeanalizuje dostępne opcje, sprawdzi systemy rezerwacyjne i wyświetli Ci bezpośredni link do dokonania rezerwacji.

Nowe rozwiązanie jest dostępne na razie tylko w USA dla użytkowników pełnoletnich, którzy korzystają z konta Google z włączoną historią aktywności.

Google zapowiada, że w przyszłości taki agent AI będzie mógł obsługiwać również inne typy zadań, np. rezerwacje usług lokalnych (fryzjer, kosmetyczka itp.) czy zakup biletów na różnego rodzaju wydarzenia.

4. Badanie: Czy schema poprawiają widoczność w AIO?

Czy dobrze wdrożone schema mogą pomóc stronie znaleźć się w odpowiedziach generowanych przez AI Overviews? Eksperci od pozycjonowania z USA postanowili to sprawdzić i podzielili się wynikami na łamach serwisu Search Engine Land.

Analiza zaczęła się od stworzenia 3 niemal identycznych stron typu one page, które różniły się tylko jakością danych strukturalnych:

- jedna miała pełne, poprawne schema;

- druga zawierała schema z błędami;

- trzecia nie miała ich wcale.

I teraz tak – tylko strona z dobrze wdrożonymi schema pojawiła się w AI Overviews, a do tego uzyskała najwyższą pozycję w klasycznych wynikach wyszukiwania.

Witryna ze słabymi schema była widoczna w SERP-ach, ale nie w AIO; ta bez danych strukturalnych w ogóle nie została zindeksowana.

Choć to pojedynczy eksperyment, wnioski są obiecujące. Dane strukturalne wydają się pomagać Google lepiej rozumieć treści i wybierać je do generowanych odpowiedzi.

Autorzy planują kolejne testy, aby potwierdzić tę zależność, m.in. zamieniając schema między stronami.

5. Prawidłowa indeksacja a widoczność w AI

I mamy kolejną analizę, tym razem dotyczącą związku między optymalizacją strony pod kątem dostępności dla botów (czyli „crawlability”) a możliwym zwiększeniem widoczności w narzędziach AI.

Zbadano witrynę, która miała ok. 2 000 stron zindeksowanych i aż 45 000 nieindeksowanych, z czego kilka tysięcy to były duplikaty lub błędne przekierowania wpisane do mapy strony.

Po oczyszczeniu sitemapy i ogarnięciu indeksowania (czytaj: zmniejszeniu tzw. crawl waste) liczba problematycznych adresów spadła z ponad 4 000 do mniej niż 200.

W efekcie widoczność strony wzrosła średnio o 3,5% we wszystkich platformach AI (m.in. Google AI Mode, Gemini, Perplexity), a w niektórych przypadkach nawet o 10%. Jedynie w ChatGPT odnotowano lekki spadek, co autorzy tłumaczą opóźnieniami w aktualizacji danych.

Wychodzi więc na to, że optymalizacja techniczna pod kątem indeksacji ma jakieś przełożenie na obecność w wyszukiwarkach AI.

Usuwanie zbędnych adresów i dbanie o jakość mapy witryny sprawia, że algorytmy AI łatwiej znajdują i wykorzystują wartościowe treści, na których nam zależy.

6. Czy używanie wielkich liter w title ma sens?

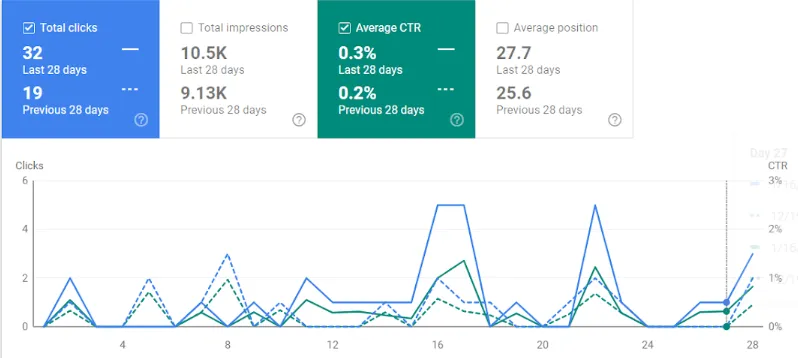

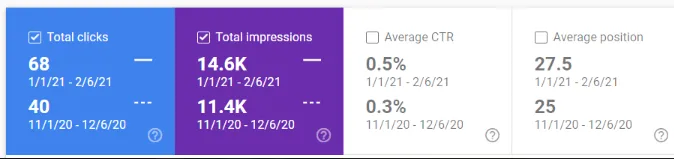

Według testów opisanych przez specjalistkę z agencji Sterling Sky wykorzystanie wielkich liter w tytułach stron (meta title) może zwiększać liczbę kliknięć.

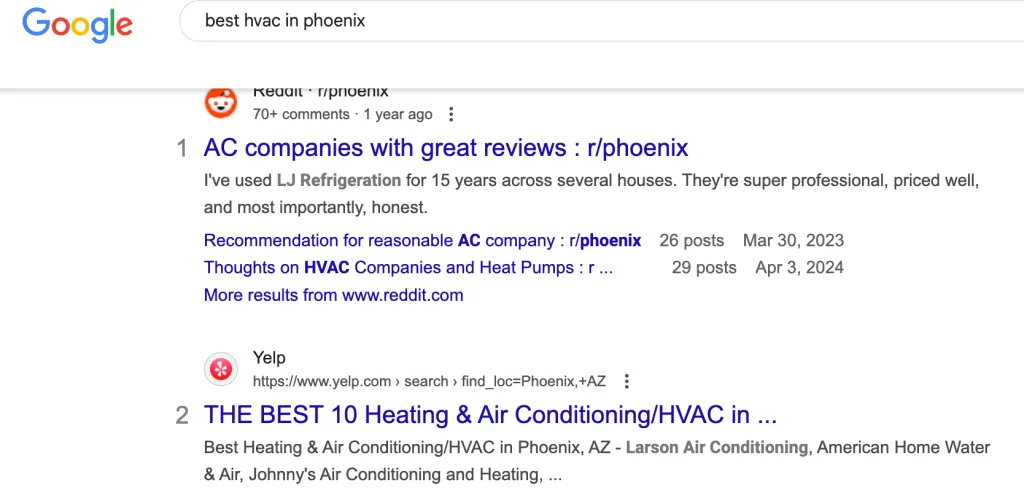

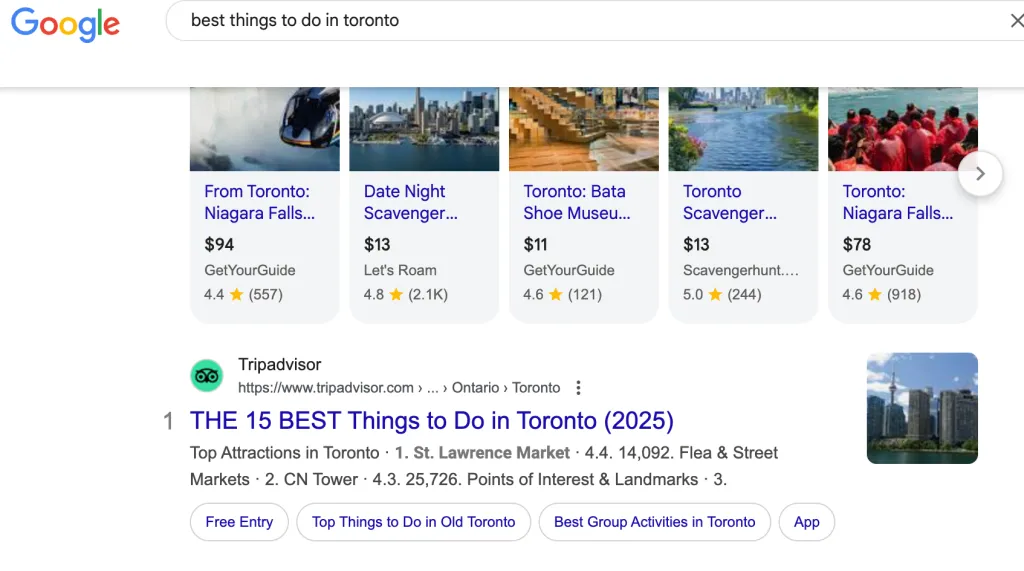

Zacznijmy od początku – autorka badania zauważyła, że portale takie jak Yelp czy TripAdvisor systematycznie stosują “all caps” w swoich tytułach.

Z doświadczenia wiedziała, że jeśli duże serwisy robią coś regularnie, być może mają ku temu powód – i postanowiła to sprawdzić na stronach, którymi zarządzała.

Eksperyment pokazał, że już drobna zmiana, np. z „Best” na „BEST”, potrafiła wyraźnie podnieść współczynnik klikalności dla wybranych podstron.

W jednym przypadku CTR wzrósł o 0,05% – pozornie niewiele, ale w praktyce dało to 159 dodatkowych kliknięć w ciągu pół roku.

Z kolei inne testy (m.in. SEMrush i SearchPilot) wskazują, że tytuły z fragmentami pisanymi wielkimi literami notują nawet 7-14% wyższy CTR.

Dlaczego to działa? Duże litery po prostu przyciągają wzrok w zatłoczonych wynikach wyszukiwania i podkreślają ważne słowo. Warunek jest jeden – nie można z tym przesadzać.

Cały tytuł w caps locku raczej nie będzie wyglądał zbyt zachęcająco, ale pojedyncze mocne słowa („BEST”, „GUIDE”, „FREE”) mogą realnie zwiększyć widoczność i klikalność strony.

Tutaj możecie sprawdzić całe badanie wykonane przez Sterling Sky: Using ALL CAPS in Title Tags: The SEO Tactic You’re Ignoring.