Google opisuje UCP – protokół, który ma uprościć zakupy agentowe. Microsoft wprowadza dwie świeżutkie funkcje do Copilota, także związane z zakupami. Apple podpisuje gigantyczny deal z Google dotyczący rozwoju Siri i Apple Intelligence. Co jeszcze? Robby Stein potwierdza, że odpowiedzi AI nadal bazują na tych samych sygnałach jakości co klasyczne wyniki, Google planuje udoskonalić rekomendacje w swoich narzędziach, a także testy AIO – jeśli użytkownicy je ignorują, mogą przestać się wyświetlać.

1. Google publikuje dokumentację Universal Commerce Protocol dla zakupów agentowych

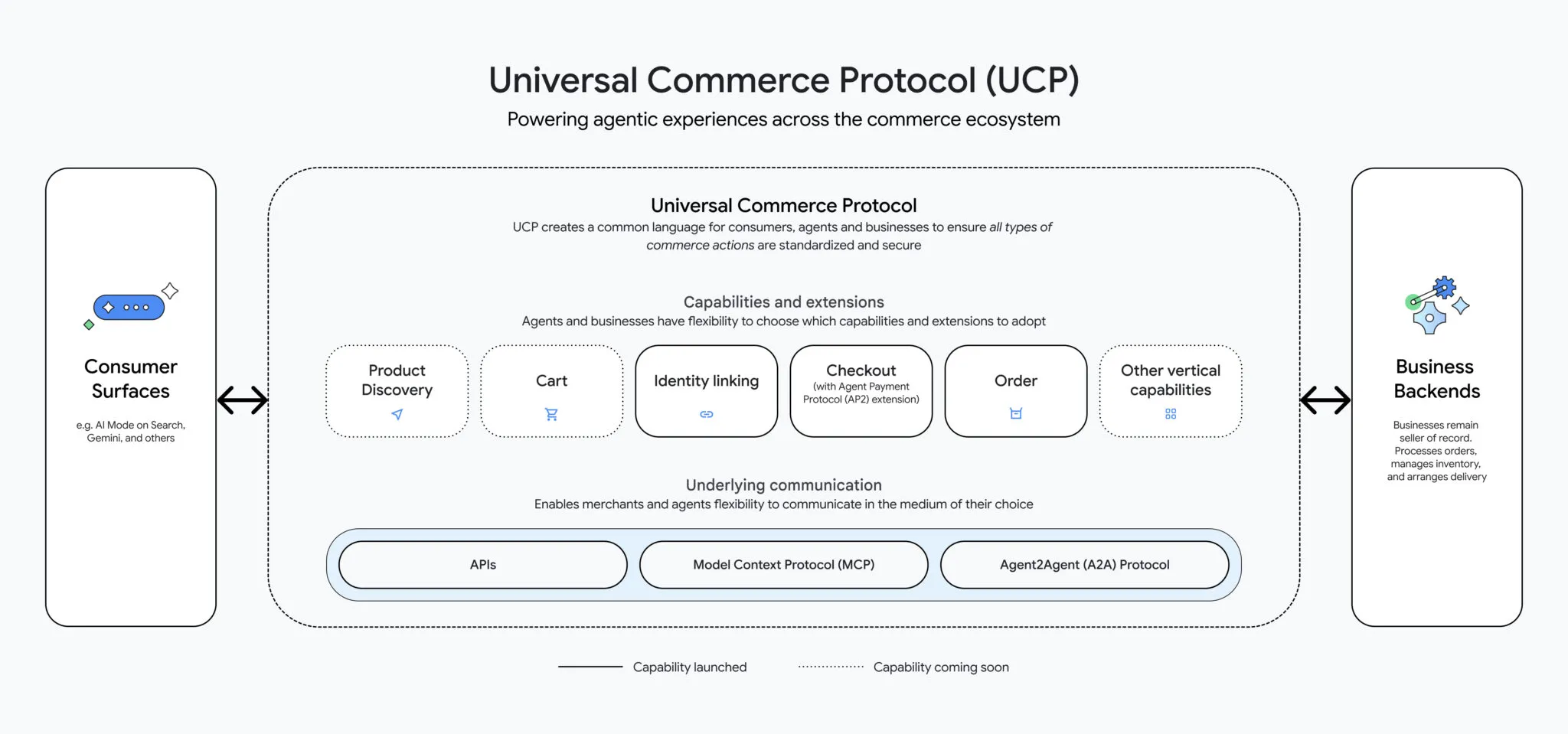

Google robi kolejny krok w stronę nowej rzeczywistości e-commerce – w której nie tyle ludzie kupują w sklepach, co agenci AI kupują w imieniu ludzi. A Universal Commerce Protocol ma być tym, co pozwoli im dogadać się ze wszystkimi sklepami jednym, wspólnym protokołem.

UCP ma celu uproszczenie i ujednolicenie całego procesu, od wyszukania produktu aż po zapłacenie, bez konieczności ogarniania dziesiątek osobnych integracji.

Do tej pory każdy sklep, system płatności czy platforma musiały się łączyć osobno z różnymi narzędziami. UCP ma to ułatwić – to wspólny „język” dla sklepów, płatności i agentów AI. Jeśli sklep się nim posługuje, to dowolny agent AI może sprawdzić cenę, dostępność, warianty, a nawet sfinalizować zakup.

Google chce to wpiąć głównie w swoje środowisko: AI Mode w wyszukiwarce i aplikację Gemini. W praktyce ma to wyglądać tak, że użytkownik może nie tylko zapytać „jaki laptop do 4000 zł”, ale też powiedzieć „kup mi ten najlepszy”.

W następnym kroku AI:

- porówna oferty,

- wybierze konkretną opcję,

- zapłaci (np. przez Google Pay),

- i ogarnie cały proces bez wchodzenia na stronę sklepu.

Przy okazji Google pokazuje też inne elementy tej układanki. Jest np. Business Agent – czyli agent AI, który działa jak sprzedawca konkretnej marki: odpowiada na pytania, tłumaczy ofertę i pomaga się zdecydować.

Mamy również Direct Offers. To wyjątkowe oferty i promocje, które mogą się pojawiać bezpośrednio w konwersacji w AI Mode – gdy system wykryje, że klient jest bliski sfinalizowania transakcji.

Największa zmiana jest taka, że zakup może wydarzyć się, zanim ktoś w ogóle wejdzie na stronę sklepu. Cała decyzja i transakcja może się zamknąć w rozmowie z AI.

Więcej w tym temacie przeczytacie na blogu Google: New tech and tools for retailers to succeed in an agentic shopping era

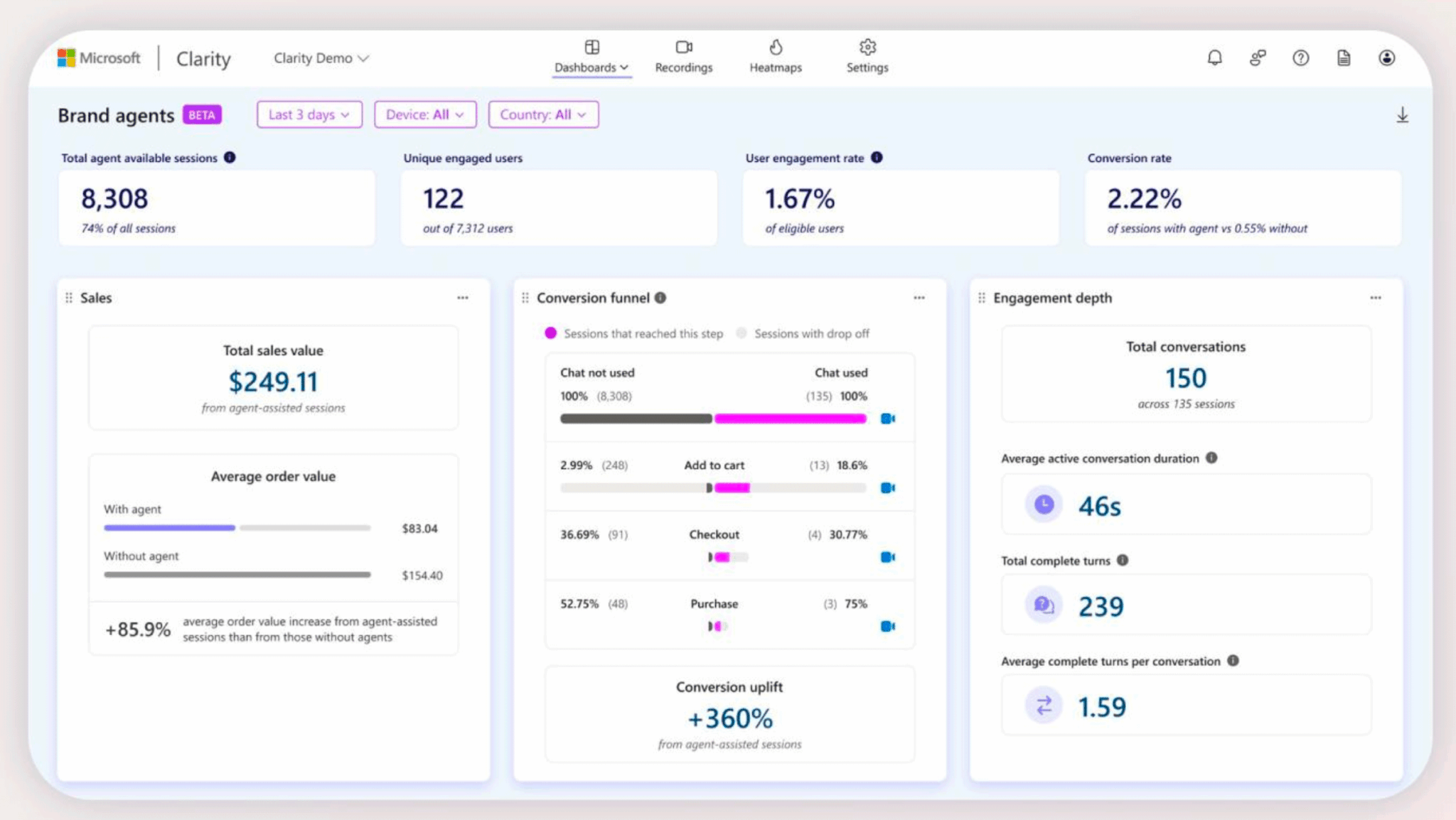

2. Copilot z nowymi funkcjami: Checkout oraz Brand Agents

Microsoft ewidentnie nie chce zostać w tyle w wyścigu o funkcje agentowe i dorzuca do swojego asystenta AI dwie nowe opcje: Copilot Checkout i Brand Agents.

Copilot Checkout działa następująco: pytasz Copilota np. o słuchawki, on je porównuje, podaje opcje, a jeśli zdecydujesz się na konkretny model, możesz go od razu kupić w tym samym oknie rozmowy.

Płatność, dane do wysyłki – wszystko dzieje się w czacie. Microsoft współpracuje tu m.in. z Shopify, PayPalem, Stripe’em i Etsy, więc sporo sklepów ma być „z automatu” dostępna w tym systemie.

Warto wiedzieć

Zobacz też: Instant Checkout w ChatGPT

Drugie narzędzie o nazwie Brand Agents to w zasadzie odpowiednik Business Agents od Google, o którym pisałem wyżej. Marka może wrzucić takiego agenta AI na swoją stronę, a on (znając ofertę, ceny i warianty produktów) może rozmawiać z klientem 24/7 i pomagać mu w zakupach.

Microsoft podkreśla, że to nadal sklep obsługuje zamówienie, wysyłkę i klienta – Copilot jest tylko nowym kanałem sprzedaży, takim jak kiedyś wyszukiwarka albo porównywarka cen.

3. Apple rozwija Siri, bazując na możliwościach Gemini

Apple przestaje udawać, że samodzielnie ogarnia swoje narzędzia AI. Dowód? Właśnie podpisali wieloletni kontrakt z Google, które będzie im dostarczać gotową technologię (czytaj: model Gemini) do dalszego rozwijania m.in. asystenta Siri.

To ma być duży skok jakościowy. Siri w obecnej formie kojarzy się raczej z ustawianiem budzika i sprawdzaniem pogody niż z sensowną rozmową. Nowa odsłona, oparta na Gemini, będzie:

- lepiej rozumieć pytania,

- ogarniać kontekst rozmowy,

- łączyć informacje z różnych aplikacji,

- w końcu odpowiadać jak nowoczesny asystent AI, a nie automat z 2015 roku.

Apple planuje wykorzystać Gemini w swoim systemie Apple Intelligence, czyli pakiecie funkcji AI na iPhonie, iPadzie i Macu. Oczywiście opakują to w swoje rozwiązania i interfejs.

Według nieoficjalnych informacji Apple ma za to płacić Google nawet około miliarda dolarów rocznie, więc widać, że traktują temat poważnie.

Nowa Siri ma trafić do użytkowników w 2026 roku, pewnie wraz z jedną z większych aktualizacji iOS.

4. Google integruje sygnały klasycznego wyszukiwania z odpowiedziami AI

No i znowu mamy potwierdzenie, że klasyczne SEO nie umiera z powodu rozwoju narzędzi AI.

Google po raz kolejny podkreśla, że AI Overviews czy AI Mode wykorzystują core search signals, czyli te same podstawowe sygnały rankingowe, które od lat decydują o tym, jakie strony pojawiają się u góry wyników w tradycyjnym wyszukiwaniu.

Ostatnio mówił o tym Robby Stein z Google w podcaście Terms of Service. Możecie go odsłuchać tutaj: The best way to search for info online in the AI era | Terms of Service.

W skrócie można więc powiedzieć, że kiedy asystent AI udziela odpowiedzi użytkownikowi, to nie wymyśla jej od zera, tylko korzysta z tego, co Google już wcześniej uznało za wartościowe: stron, treści i źródeł, które dobrze wypadały w normalnych wynikach wyszukiwania.

Stein tłumaczy, że są ku temu dwa powody:

- Odpowiedzi AI są bardziej trafne, bo bazują na sprawdzonych danych.

- Asystenci mają mniej halucynować – podkreślono, że nadal mogą zdarzać się błędy, ale system cały czas uczy się na podstawie sygnałów i opinii od użytkowników.

5. Lepsze rekomendacje w Discover, YouTube i Google News dzięki spersonalizowanej semantyce

Google po cichu opublikowało pracę badawczą, w której opisuje nowy sposób ulepszania systemów rekomendacyjnych takich jak YouTube, Google Discover czy Google News.

Docelowo mają one być bardziej ludzkie. Chodzi o to, żeby system nie tylko patrzył, co użytkownik klika i ogląda, ale też rozumiał, co ma na myśli, kiedy mówi, że coś jest „fajne”, „śmieszne” albo „ciekawe”.

Do tej pory algorytmy działały dość prosto: użytkownik kliknął film → obejrzał do końca → dostał więcej podobnych propozycji. Te stare sygnały określane jako primitive user feedback mierzyły m.in. kliknięcia czy czas przeglądania treści.

Google chce to zmienić dzięki czemuś, co nazywa się „semantic intent”, czyli intencja znaczeniowa. W praktyce AI ma się uczyć, co dla konkretnej osoby oznaczają takie określenia jak „relaksujące”, „inspirujące” czy „dziwne”.

Wykorzystywana jest do tego specjalna technika, która tłumaczy ludzkie opisy na język, który rozumie model matematyczny.

Efekt ma być taki, że rekomendacje będą mniej mechaniczne i bardziej dopasowane do stylu i gustu użytkownika.

Podrzucam link do pełnego artykułu od Google: Discovering Personalized Semantics for Soft Attributes in Recommender Systems using Concept Activation Vectors.

6. Czy AIO się wyświetlą? To zależy od naszego zaangażowania – testy nowego rozwiązania

Google testuje mechanizm, który sprawdza, jak użytkownicy reagują na AI Overviews. Nie chodzi jednak tylko o kliknięcia, ale też o to, czy ludzie je rozwijają, przewijają i wchodzą w interakcję, czy kompletnie je ignorują.

Jeśli dane pokazują, że przy konkretnym typie zapytań AI Overview nie wnosi nic wartościowego, to Google uczy się tego i przestaje go wyświetlać dla podobnych pytań.

Warto wiedzieć

Zobacz też: AIO nie zawsze rankują na 1. pozycji

To ważna informacja dla specjalistów od pozycjonowania i wydawców – widoczność w AIO nie jest dana raz na zawsze. Można się tam pojawić, ale jeśli użytkownicy nie uznają tego formatu za pomocny, Google może go wyłączyć i wrócić do bardziej klasycznych wyników.

Z punktu widzenia użytkownika to akurat dobra wiadomość. Google nie chce na siłę wciskać funkcji AI tam, gdzie mogą one przeszkadzać. Jeśli podsumowanie od AI nie pomaga w znalezieniu odpowiedzi, to algorytm po prostu z niego zrezygnuje.