Twoja strona zaliczyła ostatnio spadek ruchu z wyszukiwarki i podejrzewasz, że przyczyną może być coś związanego z SEO? W tym artykule pokażę Ci, jak radzę sobie z takimi przypadkami!

Spis treści:

Zobacz też:

Co sprawdzam?

Pozycjonowanie to często karuzela, a z racji tego, że występują w nim te „zielone”, wzrostowe okresy, to zdarzają się także te czerwone, gorsze momenty.

Co robię, kiedy widzę, że ruch w serwisie klienta spada? Analizuje stronę oczywiście, i teraz podzielę się z Tobą check-listą elementów, które biorę na warsztat w takich sytuacjach.

Bez wchodzenia w szczegóły – oto lista tego, co sprawdzam, gdy zauważę spadek ruchu:

- wykres widoczności,

- statystyki z GA/GSC (szczególnie uwzględniając sezonowość),

- widoczność na konkretne adresy URL,

- widoczność na konkretne frazy kluczowe,

- czy na stronie w ostatnim czasie prowadzone były jakieś zmiany,

- czy ostatnio była jakaś aktualizacja algorytmów Google,

- kwestie bezpieczeństwa strony,

- indeksowanie serwisu,

- problemy po stronie serwera,

- błędy techniczne,

- czy nie doszło do jakiegoś błędu / awarii po stronie Google,

- czy profil linków uległ zmianie,

- czy zaszły jakieś zmiany na stronach wyników,

- co zrobiła w tym czasie konkurencja w wyszukiwarce.

No to bez zbędnego przedłużania, czas przyjrzeć się temu, co wymieniłem z osobna i pokazać jak to wygląda na realnych przykładach :)

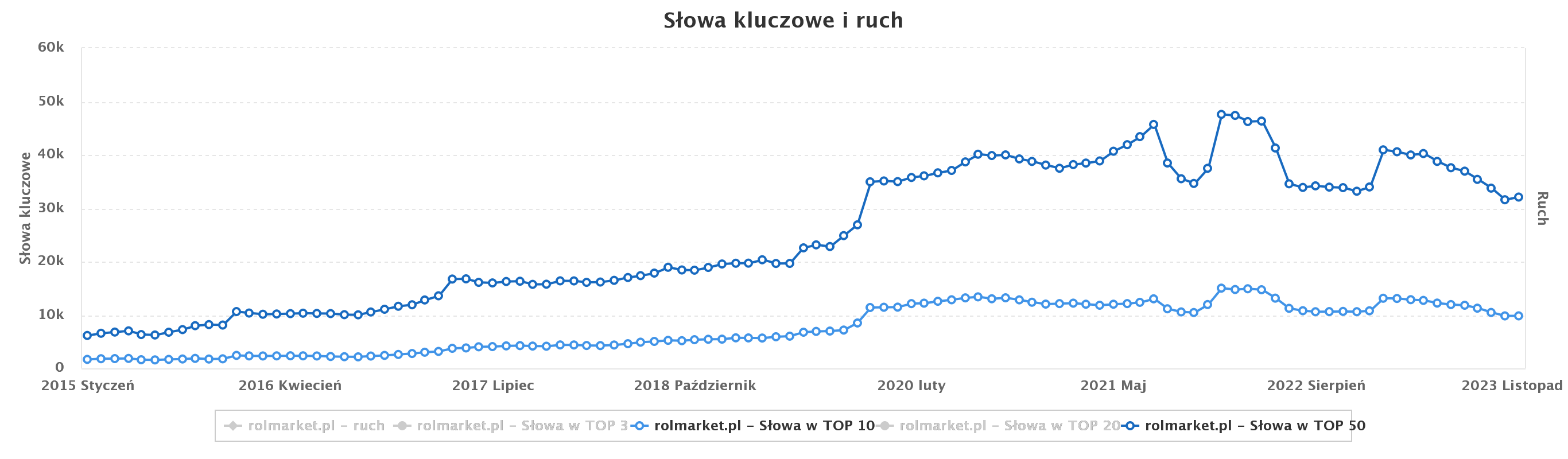

Wykres widoczności

Jeśli ruch spadł, to na pierwszy ogień idzie wykres widoczności. Ja traktuję go tylko poglądowo i tak też zawsze polecam czytać go Klientom.

Z doświadczenia wiem jednak, że takie podejście nie zawsze spotyka się z pełnym zaufaniem, więc muszę to podeprzeć konkretnymi przykładami :)

Ja podam Ci dwa przykłady z życia wzięte, ale jeśli temat jest Ci obcy, to od razu polecam też artykuł Grzegorza: Dlaczego przestałem ufać wykresom widoczności.

Pierwszy przykład:

Interesuje nas tu okres od stycznia 2023 do października 2023 (ostatnie 10 kropek po prawej stronie wykresu). Na pierwszy rzut oka widoczność spada, wygląda to nieciekawie. O wiele ciekawiej robi się już jednak na „drugi rzut”, czyli przy analizie.

Gdy zagłębiłem się w to, jakie słowa kluczowe traci domena, to wyszły tutaj niezłe kwiatki.

Na początku spadków serwis tracił głównie nietrafione frazy, na które Google wyświetlił chwilowo stronę w wynikach mimo tego, że nie była on na nie optymalizowania. Jakieś totalnie losowe zapytania bez potencjału i tym bardziej bez ruchu.

Apogeum spadków miało jednak miejsce w drugiej połowie tego okresu. Tam zaczęły pokazywać się frazy innych brandów lub zawierające nazwy innych marek i produktów. Kompletnie niezwiązane z profilem działalności Klienta.

W skrócie: doszło do błędu Google lub Semstorma. W efektach nic się nie zmieniło, ale wykres mocno raził.

Przy analizie tych samych okresów w GA i GSC wyszło, że notujemy 30% wzrostu w sesjach, 35% w użytkownikach i 70% w przychodach. Całkiem nieźle, jak na spadki widoczności, nie? :)

Drugi przykład:

Sytuacja, w której wykres widoczności pokazywał frazy kompletnie nieistotne.

Klient sprzedaje porcelanę i naczynia, i w nazwach produktów, a nawet kategoriach pojawiają się ich pojemności. Na przykład nazwa kubka ma w sobie frazę „330 ml”. No a skoro jest ona w nazwie to i jest i w adresie URL, w meta title, w nagłówku H1, w opisie produktu…

Koniec końców Google pokazał Klienta w TOP20 na taką frazę, a po paru miesiącach, przy okazji jednej z aktualizacji algorytmów poprawił swój błąd i wyczyścił te „śmieciowe frazy”.

Efekt? Wykres widoczności poleciał w dół, a ruch jak rósł, tak rośnie.

Reasumując, sprawdzam wykres, ale nigdy nie zakładam od razu, że widoczny na nim spadek = przyczyna spadku ruchu. Jeśli w widoczności też jest „w dół”, to szukam dalej, a jeśli nie, to możliwe, że mniejszy ruch wcale nie jest problemem, o czym więcej w kolejnym punkcie.

Warto wiedzieć

Wykres widoczności może, ale wcale nie musi być związany z ruchem na stronie – spadek jednego nie zawsze oznacza tutaj spadek drugiego.

Dane z GA i GSC

Wykres widoczności sprawdzony, więc czas na analizę danych z Google Analytics (GA) i Google Search Console (GSC).

Co jest tutaj bardzo istotne i często zapominane moim zdaniem? To jakie okresy porównujemy!

Gdy chce się dowiedzieć, czy obecny spadek ruchu na stronie faktycznie jest czymś, czym trzeba się martwić, to zawsze muszę porównywać rok do roku.

Przykładowo, jeśli mam spadek w grudniu 2023, to porównuję dane z grudniem 2022, nie z listopadem, czy innym miesiącem. A już na pewno nie z miesiącem wcześniej.

Wiesz, dlaczego to tak istotne? Odpowiedź brzmi: sezonowość ruchu organicznego.

Warto wiedzieć

Nie zawsze spadek ruchu w danym miesiącu w porównaniu z poprzednim oznacza problem – często spada po prostu sezonowe zainteresowanie – czyli mniej ludzi szuka Twoich fraz.

Czas na kolejny przykład.

Jeden z naszych Klientów działa w branży motoryzacyjnej, a konkretnie z jednośladami oraz quadami. Kategoria ewidentnie: sport lub środek transportu typowo na „ciepłe dni”.

Biznes w tej branży ma taką specyfikę, że gdy tylko za oknem psuje się pogoda, to na stronie „psuje” się też ruch. Wrzesień to ostatni „szczytowy” miesiąc dla tego Klienta, a od października co roku notujemy gigantyczne spadki ruchu miesiąc do miesiąca.

No i teraz tak: jeżeli zestawimy sobie tutaj październik do września, to wyjdzie nam, że strona ma poważne kłopoty. Dane mówią wtedy wprost: spadamy, jest źle, pojawiają się wątpliwości, czy to SEO na pewno jest dobrze robione.

Jeśli jednak porównamy sobie wrzesień do września rok wcześniej, a październik do października rok wcześniej, to zobaczymy, że wzrosty ruchu są na poziomie 100% rok do roku. Dlatego tak istotny jest kontekst analizy.

Co więcej, jak sprawdzimy sobie poziom wyszukiwań fraz w poszczególnych miesiącach, czy ich popularność w Google Trends, to ta różnica w sezonie i poza nim idealnie nałoży się na wykresy z GA i GSC.

No dobra, ale co jeśli jednak okaże się, że ruch/kliknięcia/wyświetlenia spadają nam rok do roku? Wtedy znowu wchodzę głębiej i sprawdzam, jakie adresy URL wypadły z wyników lub tracą ruch oraz jakie frazy notują straty.

Zmiany na stronie?

Ruch z wyszukiwarki faktycznie spada rok do roku. Czas więc przyjrzeć się bliżej stronie. Pierwszy aspekt, od którego zaczynam, to ustalenie, czy na stronie wprowadzano ostatnio jakieś zmiany.

Tutaj do gry wchodzi prosta logika: jeśli coś miało zmienić się w wynikach z naszej winy, to musieliśmy coś zmienić. Trzeba więc ustalić co to było, dlaczego wywołało taki, a nie inny efekt i spróbować to „odkręcić”.

W tej kwestii zawsze sprawdzam, co działo się z naszej strony, a potem dopytuję Klienta i szukam w samym serwisie. Skoro spadło, to istnieje spora szansa, że ktoś coś po prostu usunął.

Kiedyś mieliśmy w Top Online przypadek, że jeden z Klientów usunął przypadkowo sporą część kategorii w swoim sklepie. Gdyby Google zdążył to zauważyć, to skończyłoby się gigantycznymi konsekwencjami, ale wykryliśmy to wcześniej. Za pomocą IGNAS’ia, który regularnie bada zmiany w mapach stron naszych Klientów.

Innym przykładem takiej sytuacji, w której usunięcie może poskutkować spadkiem ruchu, może być usunięcie części asortymentu, który się sprzedał, czy też został wycofany z jakiegoś innego powodu.

Gdy serwis generuje już stabilny ruch, to każda wprowadzana w nim zmiana może okazać się istotna. Nieważne, czy jest to dodanie, czy usunięcie czegoś. Wszystko może rzutować na wyniki.

Nie wspomnę już nawet o migracji serwisu, bo to w ogóle jest gigantyczna operacja i możliwości błędów jest ogrom.

Bardzo często zdarza się wtedy np. nieściągnięcie meta tagu „noindex” ze strony głównej w wersji produkcyjnej i potem trafia ona na serwer właśnie z „noindexem”. W efekcie cała domena może zostać usunięta z wyników Google.

Gdy ustalę co się zmieniło przed spadkiem, to rozwiązaniem jest zwykle cofnięcie tych zmian. Tutaj trzeba jednak uważać, bo nie zawsze jest to takie oczywiste.

Wprowadzenie zmiany, która blokuje indeksację czy tam np. usunięcie podstron to przypadki banalne – trzeba przywrócić sytuację i tyle.

Zdarza się jednak, że spadki pojawiają się po optymalizacji, np. po dodaniu tekstu. Czy wtedy trzeba go od razu usunąć? Nie zawsze – to już wymaga dodatkowej analizy.

Miniaudyt techniczny serwisu

Skoro były jakieś zmiany, ale nie udało mi się wskazać niczego większego, to być może miały one miejsce w obszarze technicznym.

Kolejno robię więc taki miniaudyt techniczny serwisu i sprawdzam:

- poprawność przekierowań HTTP/HTTPS w obrębie całej strony (np. w WordPressie często zdarza się, że działają one tylko na stronie głównej),

- poprawność przekierowań z WWW na bez WWW,

- trailing slash, którego przekierowanie mogło przestać działać i wygenerować duplikaty adresów,

- zmiany w adresach URL,

- brak przekierowań / zepsute przekierowania (czyli sprawdzam kody 3xx oraz 4xx, a także 5xx),

- poprawność wdrożenia canonicali,

- dyrektywy index oraz follow,

- pliki robots.txt i sitemap.xml,

- weryfikuję także paginację, jeżeli jest w serwisie.

Jak zrobić audyt SEO bez płatnych narzędzi opisałem szczegółowo w artykule i to tam Cię odsyłam, jeśli potrzebujesz sprawdzić coś konkretnego.

Jeśli coś znajdę na tym etapie, to od razu działam nad optymalizacją i czekam na efekty, a dalej przechodzę dopiero wtedy, gdy po jakimś czasie nic się nie zmieni.

Aktualizacje Google

Jeśli nic nie wskazuje na to dlaczego serwis miałby spaść, to przyczynę mogą wskazać też aktualizacje algorytmów Google. Ten temat, mimo że często wyśmiewany, może mieć kluczowe znaczenie.

Jeśli np. ostatnio odbywał się update, który skupiał się na contencie, a serwis stoi wzdłuż i wszerz treścią skopiowaną, to już mam bardzo dobrą wskazówkę, że obszaru do poprawy powinienem szukać właśnie w tekstach.

W kwestii aktualizacji już zakończonych można po prostu zerknąć do naszego artykułu podlinkowanego wyżej, który staramy się aktualizować na bieżąco.

W kwestii aktualizacji w trakcie warto jednak prześledzić te wydarzenia, poszukać informacji, czego dany update dotyczył, czy jakich branż lub obszarów dotknął najbardziej. Warto śledzić też zmienność wyników w Google.

O tym wszystkim na bieżąco informuje Adam w naszych SEO News, do których Cię zapraszam :).

Teoretycznie, jeżeli Twoja strona jest zrobiona „legitnie” (czyli zgodnie z wytycznymi Google) to spadki przy aktualizacji powinny być chwilowe. W praktyce bywa jednak różnie.

Nie da się wskazać jednego sposobu na „dźwignięcie” strony po spadkach wywołanych aktualizacją algorytmu. Najczęściej jest to dopracowanie tego, przez co spadliśmy – sztuka w tym, żeby ustalić, co tak naprawdę było nie tak.

Zmiany na stronach wyników

Zmiany w SERP (czyli na stronach wyników) to kolejna rzecz, której warto przyjrzeć się bliżej. Obecnie sam wygląd strony może znacząco wpłynąć na ruch. Często dochodzą też nowe funkcje wyników (snippety), które „zabierają” użytkowników stronom.

Nie raz widziałem już przypadki, w których pojawienie się snippetów sprawiało, że 2. lub 3. pozycja wizualnie spadły tak nisko, że wyglądały jak wynik w TOP20/TOP30.

Przykładowo: od góry strony wyników możemy mieć tak: najpierw wyniki Ads, potem snippet Google Shopping, potem pozycja 1, potem snippet z mapą, kolejne 2 wyniki, jeszcze snippet z Google Grafika, i dopiero kolejne wyniki!

Pomimo bycia prawie na samym szczycie według pozycji, na przykład na 4 czy 5 miejscu możemy wtedy nie mieć prawie żadnego ruchu!

Inny przykład: obecność map na frazie i układ: 1 pozycja - snippet z mapami - kolejne wyniki organiczne.

Wtedy realna pozycja numer 1 w wynikach jest odbierana przez użytkowników (z przyzwyczajenia) jako wynik sponsorowany (Adsy). Realnie najwięcej kliknięć pozyskują więc wyniki 2-4.

Jak więc widzisz, czasem nawet wskoczenie na pierwszą pozycję może poskutkować spadkiem ruchu. A czasami Google po prostu wyświetli jakąś funkcję, która zepchnie nas wizualnie niżej, przez co użytkownicy przestaną do nas trafiać.

Warto to obserwować i brać pod uwagę przy analizie. Przy pojawieniu się funkcji wyników, które „spychają” nas niżej rozwiązaniem jest tylko optymalizacja pod kątem obecności w tych funkcjach. Z Google nie wygramy.

Bezpieczeństwo serwisu

Przez bezpieczeństwo strony rozumiem głównie sprawdzenie tego, czy nasz serwis nie stał się celem ataku. To szczególnie ważne w kontekście WordPressa, na którym najczęściej dochodzi do włamów przez liczne luki w systemie/wtyczkach.

Najczęściej taki wirus będzie generował nam spamowe podstrony. Często będą to dosłownie tysiące adresów „krzaczków”. Taka sytuacja może nieźle namieszać, szczególnie gdy realnie nasz serwis powinien mieć np. mniej niż 10 podstron (bo jest tylko wizytówką).

Jak sprawdzić, czy nie doszło do czegoś takiego? Najszybciej będzie sprawdzić raport Indeksowanie > Strony w Google Search Console. Pod kątem tego, czy Google nie wykrył gigantycznego wzrostu podstron.

Można też skorzystać z komendy „site:” w wyszukiwarce, ale nie jest ona dokładna, o czym trzeba pamiętać.

Jeżeli wykryjemy jakieś zagrożenie, to trzeba jak najszybciej wyczyścić cały serwis i przywrócić poprzedni, właściwy stan.

Niestety, taka sytuacja może mieć wpływ na wyniki, nawet wtedy gdy uda nam się ją sprawnie opanować, dlatego róbcie backupy, pamiętajcie o bezpieczeństwie i aktualizujcie swoje WordPressy i wtyczki.

W tym temacie nie zaszkodzi też sprawdzić w GSC sekcji „Bezpieczeństwo i ręczne działania”. Co prawda, działań w ramach tej sekcji jest podejmowanych coraz mniej, ale nadal potrafią się zdarzyć.

Osobiście byłem świadkiem takiego ataku na jednej z prowadzonych przeze mnie stron. Witryna została zaatakowana przez wirusa, a co więcej, ten próbował rozlać się na cały serwer. Na szczęście firma hostingowa to wykryła i odłączyła całkowicie dostęp.

Sprzątania przy tym było co niemiara, bo strona ta (był to blog na WordPressie) nie miała żadnych kopii zapasowych – więc trzeba było ją postawić kompletnie od nowa.

I wtedy faktycznie, w GSC pojawiło się ostrzeżenie i nałożone zostały blokady. Po naprawieniu sytuacji wypełniłem jednak formularz Google i opisałem w nim podjęte działania. Dzień później problem był rozwiązany.

Koniec końców wyniki nie ucierpiały, ale pracy i stresu było sporo :)

Dostęp do strony

Kolejny punkt, czyli dostęp Google do strony, a właściwie problem z tym dostępem, który może utrudniać indeksowanie. Jeśli roboty Google „odbijają się od strony”, to spadek ruchu i widoczności jest tylko kwestią czasu.

Tutaj przyczyn może być wiele, np. zmiany w pliku robots.txt, włączenia „noindex”, problemy z PageSpeedem serwisu, problemy po stronie firmy hostingowej, niezoptymalizowany szablon strony…

Tak czy inaczej, zwykle chodzi o omyłkowe ograniczenie dostępu Googlebotom, zwracanie błędu serwera lub tak długi czas ładowania, że w końcu zwrócony zostanie właśnie ten błąd.

Żeby sprawdzić, czy to nie w tym leży problem musimy sprawdzić plik robots, przetestować PageSpeed strony, np. w Google Lighthouse. No i przeskanować ją crawlerem imitującym zachowanie Googlebota, np. w ScreamingFrog.

W niektórych przypadkach, gdy wina leży po stronie hostingu lub konfiguracji serwera, obie te metody mogą jednak nie pokazać prawdy.

Jeśli jako przyczynę spadków ruchu podejrzewasz problem z dostępem do serwisu, ale nic „z zewnątrz” na to nie wskazuje, to konieczna będzie analiza logów serwera. Tylko ona da Ci 100% pewności – bo tylko w niej zobaczysz, co faktycznie dzieje się wtedy, gdy Google odwiedza Twój serwis.

Tutaj działania naprawcze zależą już bezpośrednio od tego, co jest powodem.

Moja wskazówka jest taka, że w przypadkach nieoczywistych (np. wzrost czasu ładowania bez wyraźnej przyczyny po stronie serwisu) najlepiej kontaktować się od razu z dostawcą hostingu / supportem.

Bugi i błędy

Odnośnie bugów i błędów, to wbrew pozorom zdarzają się one w Google, i to wręcz coraz częściej. Stąd warto też zadać sobie pytanie, czy dany spadek ruchu nie jest przypadkiem właśnie bugiem lub błędem.

W Google Search Console takich potknięć jest ostatnimi czasy naprawdę sporo. Czy to w samym raportowaniu, czy nawet ostatnio z działaniem całego narzędzia.

W dużym skrócie: może być tak, że w raportach GSC wszystko leci w dół, a tak naprawdę wynika to tylko z błędu śledzenia i jest to po prostu fałszywy alarm. Na to także warto być więc wyczulonym. Szczególnie jeśli spadki są nagłe, nienaturalne, ogólnie „dziwne”.

Potwierdzenia, że dany spadek jest efektem błędu raportowania możesz szukać na oficjalniej podstronie anomalii danych w Search Console. Adam pisze też o nich na bieżąco w SEO Newsach.

Profil linków

No ale jedźmy dalej. Przekopaliśmy się już przez prawie wszystko, co mogło wpłynąć na spadek ruchu z Google na stronie. Jeśli chodzi stricte o SEO, to do przejrzenia zostaje nam jeszcze profil linków.

Może w ostatnim czasie wypadła nam spora część odnośników i mają one teraz status zepsutych, bo np. ktoś je usunął, albo linkująca strona przestała działać? Takie przypadki też mogą rzutować na wyniki, ale to już raczej sytuacje rzadkie.

Jeśli jednak nic z powyższych elementów nie wskazało na przyczynę, to nie zaszkodzi sprawdzić. Najłatwiej w raporcie Linki w Search Console, a dokładniej w narzędziach takich jak Ahrefs.

Co robi konkurencja

Ostatni punkt mojej listy to konkurencja. Może działamy w bardzo konkurencyjnej branży i ostatnimi czasy nasi współtowarzysze wyników hurtowo ruszyli z działaniami SEO?

Tak też się zdarza, a jeśli nie prowadziliśmy wielu działań ostatnimi czasy lub je trochę akurat zaniedbaliśmy, to i to może powodować spadki w wynikach, a co za tym idzie spadki ruchu z Google.

Jeśli jednak powodem faktycznie jest konkurencja, to myślę, że na tym etapie, już o tym wiesz. Wskażą na to przede wszystkim spadki pozycji na frazach, a czasem nawet spadki widoczności.

Tutaj nie pozostaje już nic innego, jak tylko dalsza optymalizacja i walka o straconą pozycję.

Podsumowanie w punktach

- Jeśli na stronie spadł ruch z Google, to na początek rzucam okiem na wykres widoczności – który traktuję poglądowo, jako wskazówkę.

- Niezależnie od tego co wskazuje widoczność, sięgam kolejno po GA i GSC – żeby wykluczyć spadki naturalne, sezonowe.

- Kolejny krok to sprawdzenie i ewentualne cofnięcie tego, co ostatnio zostało zmienione na stronie.

- Jeśli nic nie znalazłem, przeprowadzam miniaudyt techniczny serwisu, co często pozwala znaleźć zmiany odpowiedzialne za spadki.

- Dalej nic? Sprawdzam, czy ostatnio nie miały miejsca (lub właśnie nie trwają) jakieś aktualizacje algorytmów Google.

- Kolejno przyglądam się stronom wyników na najważniejsze frazy – może akurat Google dodał jakieś funkcje, które „zabrały” mi ruch?

- Następny krok: bezpieczeństwo serwisu, czyli głównie liczba zindeksowanych podstron i zakładka bezpieczeństwa w GSC.

- Wszystko gra? Jeśli tak, to analizuję, czy roboty Google nie mają przypadkiem z jakiegoś powodu ograniczonego dostępu do serwisu.

- Dalej sprawdzam bugi i błędy po stronie Google i w Search Console (może spadek to tylko chwilowy błąd albo i całkiem fałszywy alarm?).

- Jeśli nadal nic nie znalazłem, na warsztat biorę profil linków, a konkretnie to, czy strona nie straciła ostatnio większej liczby odnośników.

- Na koniec pozostaje jeszcze wziąć pod uwagę to, co robi konkurencja w wynikach (czasem przyczyną spadków może być intensywne SEO konkurentów).

- Osobiście nie zdarzyło mi się jeszcze przeanalizować wszystkich tych elementów i nie znaleźć przyczyny spadającego ruchu na stronie – jeśli jednak masz taki problem, napisz do nas na grupie SEO Samodzielni na Facebooku.

![[object Object] - Top Online](

https://cdn.toponlineapp.pl/6979-logo-toponline-partner.png)

![[object Object] - Top Online](https://cdn.toponlineapp.pl/7474-hubert.png)