AI Overviews są już oficjalnie dostępne w Polsce. Google zdradza, że jeśli strona nie ma interakcji, to może nawet wypaść z indeksu. Trzy nowe funkcje w GA4. Dostęp do nowych danych w interfejsie API GSC. AI może podawać nie tylko błędne informacje, ale również nieistniejące linki. Na koniec trochę o Google jako (wciąż) najpotężniejszym graczu na rynku wyszukiwania.

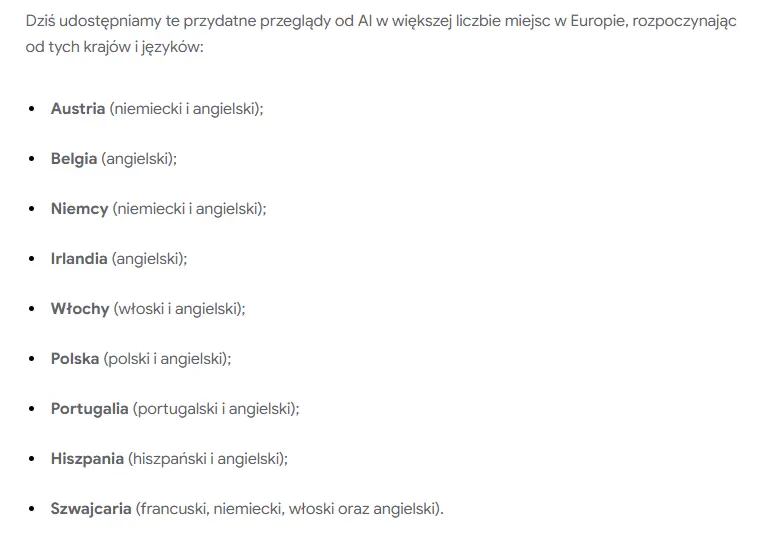

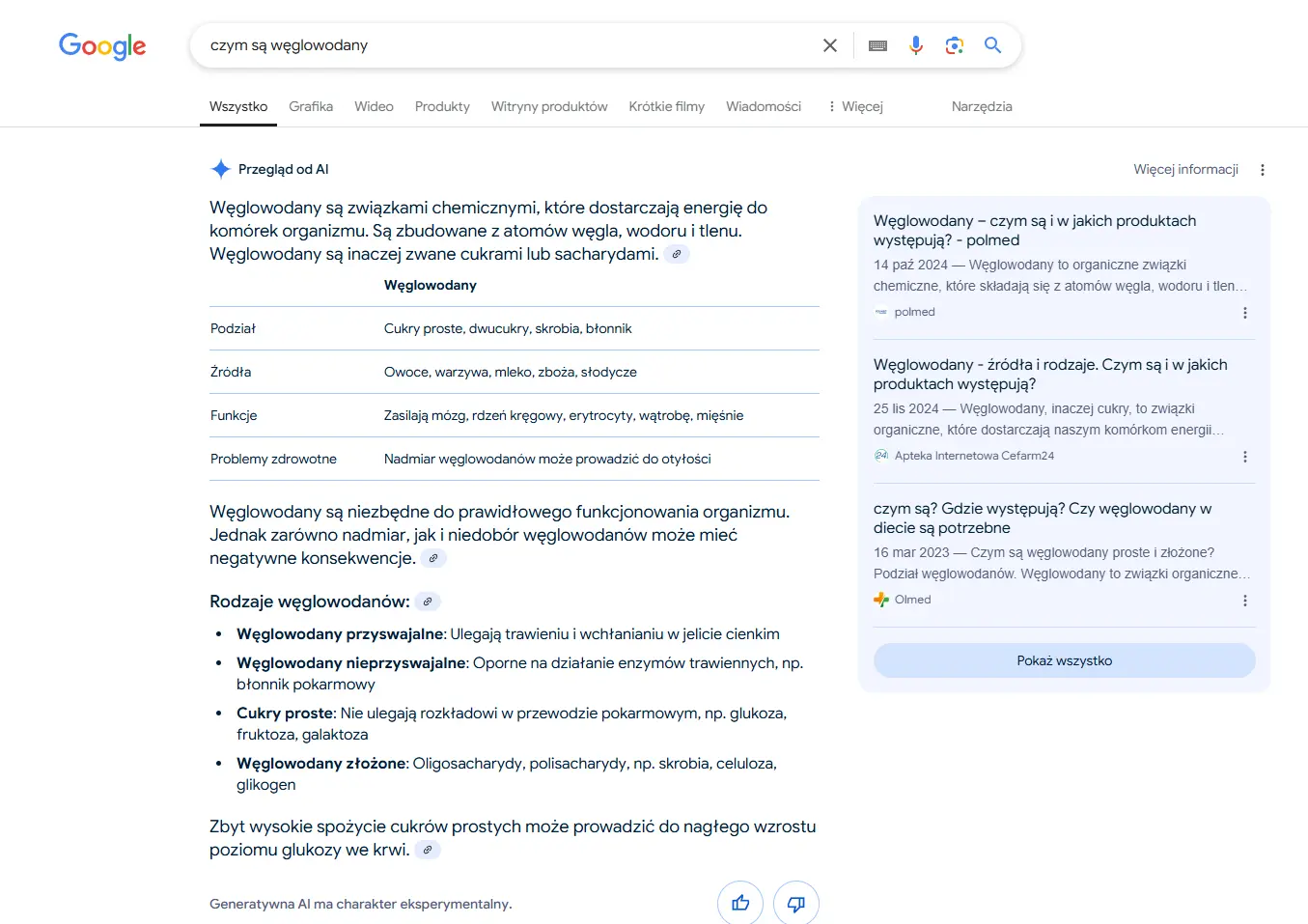

1. AI Overviews dostępne w Polsce!

Google oficjalnie udostępniło AI Overviews (wyniki generowane przez AI) w polskich wynikach wyszukiwania.

Dzisiaj, 26 marca 2025 roku, na blogu Google pojawiła się oficjalna informacja o rozszerzeniu dostępu do funkcji na kolejne europejskie kraje, w tym właśnie Polskę.

Na ten moment z AI Overviews korzystać mogą wyłącznie zalogowani użytkownicy powyżej 18 roku życia. Z tego co zaobserwowaliśmy jednak w pierwszych testach, dostęp do nowości mają na razie nie wszystkie konta Google.

Przykładowy wynik AI Overviews w polskich wynikach Google

2. Twoja strona nie jest klikana? Google może ją usunąć z indeksu

Google opublikowało krótkie wideo na swoim youtubowym kanale Search Central, w którym Martin Splitt wyjaśnia, dlaczego teoretycznie zaindeksowane strony nie pojawiają się w wynikach wyszukiwania.

I choć powodów może być mnóstwo (bo za widoczność odpowiada gigantyczna liczba czynników), to moją uwagę przykuło szczególnie jedno zdanie:

“(..) jeśli strony znowu wypadają z indeksu… użytkownicy tak naprawdę nie używają ich w wynikach wyszukiwania”.

Mówiąc krótko: jeśli Google umieści Twoją stronę w wynikach wyszukiwania i stwierdzi, że użytkownicy nie klikają jej ani nie wchodzą z nią w interakcję, algorytmy mogą stwierdzić, że nie jest „warta” wyświetlania.

A to oznacza, że raz zaindeksowana strona może zniknąć z wyników, gdy Google dojdzie do wniosku, że nie spełnia ona potrzeb użytkowników i nie jest dopasowana do intencji wyszukiwania.

To kolejne potwierdzenie, że interakcje użytkowników (a właściwie ich brak) odgrywają ważną rolę w organizacji rankingu i wpływają na indeksowanie stron.

To wszystko ładnie się też łączy z zagadnieniem tzw. Navboost – czyli algorytmu rankingowego, którego Google używa do klasyfikowania wyników wyszukiwania dla zapytań nawigacyjnych.

Wzmianki o Navboost pojawiały się już wcześniej – m.in. przy exploicie danych Google, który wyjaśniał, jak rankowany jest content – ale tym razem informacje padają z ust znanego pracownika firmy na ich oficjalnym kanale.

Działasz w SEO i wykonujesz pozycjonowanie stron? Według mnie warto mieć to wszystko z tyłu głowy.

3. GA4 dodaje wartości procentowe do raportów (i dwie inne funkcje)

Sporo nowości w Google Analytics 4 – narzędzie rozszerza możliwości raportowania o trzy nowe funkcje.

1. Wartości procentowe: będą dodawane do każdego wiersza we wszystkich szczegółowych raportach w modułach Raporty i Reklamy.

Według nas to super sprawa, bo teraz wystarczy jeden rzut oka, żeby ocenić, które kampanie, źródła ruchu czy strony wyróżniają się w statystykach na plus. Nie będzie trzeba tego obliczać ręcznie.

2. Powiadomienia session_start: jeśli raporty wykryją wysoki współczynnik brakujących zdarzeń session_start, użytkownik otrzyma ikonę informacyjną ze szczegółami alertu.

Znowu: fajna rzecz, bo przecież GA4 w dużym stopniu opiera się na prawidłowo skonfigurowanych zdarzeniach session_start.

Ale powiadomienie to dopiero początek. Użytkownicy będą mogli kliknąć alert i uzyskać więcej informacji – m.in. na czym polega problem, co mogło go spowodować i jak go rozwiązać.

3. Alerty o wysokim wskaźniku “(not set)”: GA4 będzie teraz oznaczać te raporty, które pokazują podejrzanie wysoki wskaźnik wartości “(not set)”.

Tutaj także będziemy mogli kliknąć alert i otrzymać kontekstowe informacje, np. dlaczego wartości “(not set)” są widoczne w raportach, co one oznaczają i jak naprawić podstawowe problemy ze śledzeniem.

GA4 się rozwija i na papierze wygląda na to, że idzie to w dobrą stronę w kontekście czytelności, skuteczniejszej analityki i lepszego zarządzania kampaniami.

A przy okazji zachęcamy do sprawdzenia naszego kursu Google Analytics 4.

4. Nowe dane w API Google Search Console

W grudniu zeszłego roku Google dodało 24-godzinne dane do raportu Skuteczność w GSC. Już wkrótce będą one dostępne także w API – ale w bardziej rozbudowanej wersji.

Konkretnie nie tylko z ostatnich 24 godzin. Użytkownicy zyskają dostęp do godzinowych danych z ostatnich 8 dni.

Taki news został zapowiedziany przez zespół Google Search na wydarzeniu Google Search Central Live w Nowym Jorku.

W styczniu Google wprowadziło opcję eksportu danych w kilku różnych formatach. Teraz będzie można je analizować także za pośrednictwem interfejsu API, i to niemal w czasie rzeczywistym.

Fakt, że dostęp do godzinowych danych z raportu Skuteczność pojawi się nie tylko w interfejsie GSC, ale także w wewnętrznych programach lub narzędziach SEO innych firm (dzięki wykorzystaniu API) na pewno usprawni analitykę wielu specjalistom od pozycjonowania i marketingu.

5. Czy linki „halucynogenne” będą zmorą narzędzi AI?

Jak się okazuje, halucynacja nie dotyczy tylko generowanych treści, ale także linków widocznych w wyszukiwarkach AI.

Właściciele stron i eksperci SEO mierzą się z nowym problemem – tworzeniem fejkowych, nieistniejących adresów URL przez narzędzia generatywnej sztucznej inteligencji.

Temat jest już poruszany przez specjalistów z branży. Ostatnio trafiłem na ciekawy wątek na platformie Bluesky, gdzie jeden z użytkowników zastanawiał się, jak ogarnąć przekierowania z takich adresów na prawidłowe – i czy w ogóle warto to robić.

Jak do tego podchodzi Google? Sprawę skomentował John Mueller, który przewiduje wzrost liczby takich halucynogennych linków w najbliższej przyszłości.

Wg niego dobrym pomysłem będzie zaprojektowanie przemyślanej strony 404, która będzie informować użytkownika o błędzie związanym z halucynacją i wskaże, gdzie w obrębie danej witryny znajdzie informacje, których szuka.

Druga możliwa opcja to użycie adresu URL jako zapytania w wyszukiwarce wewnętrznej na stronie. Potem można wyświetlić wyniki na stronie 404.

Ogólne zalecenia są takie, żeby obserwować rozwój sytuacji i zbierać dane przed zainwestowaniem czasu i pieniędzy w jakieś rozwiązanie.

Faktycznie chyba warto tak zrobić. W miarę jak zwiększa się adopcja różnych narzędzi AI do wyszukiwania, zmieniać będzie się też jakość generowanych odpowiedzi.

Być może tworzenie błędnych adresów URL jest tylko problemem wieku dziecięcego i niedługo zapomnimy, że coś takiego miało miejsce. Ale kto wie – może wydawcy będą zmuszeni do opracowania nowych strategii, które będą pomagać w łagodzeniu halucynacji.

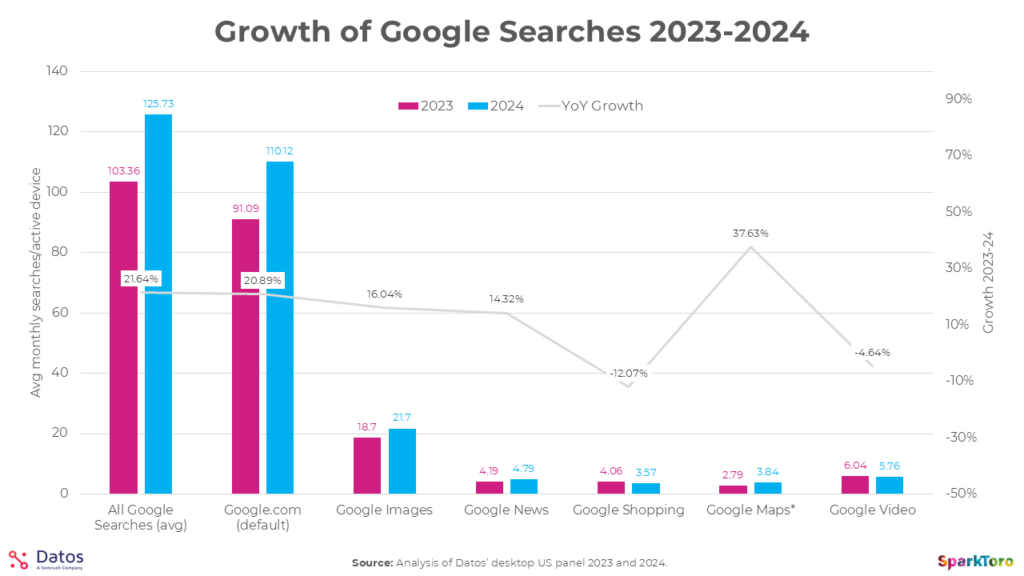

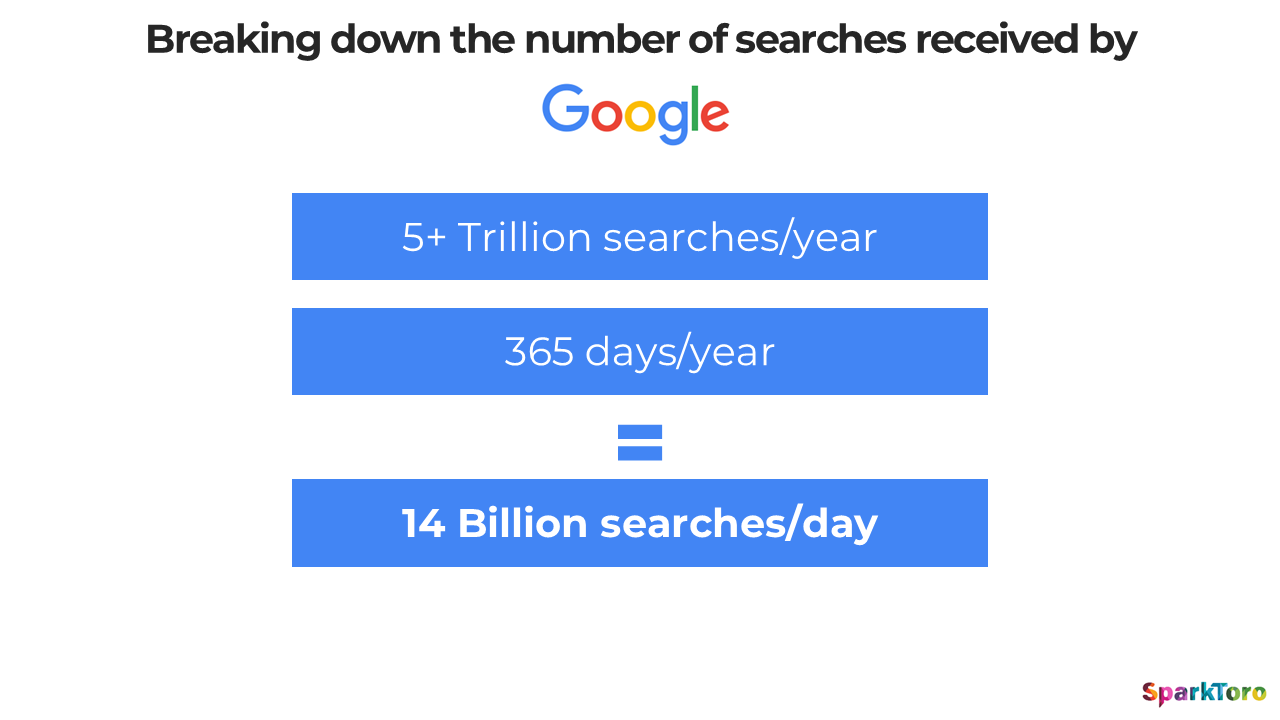

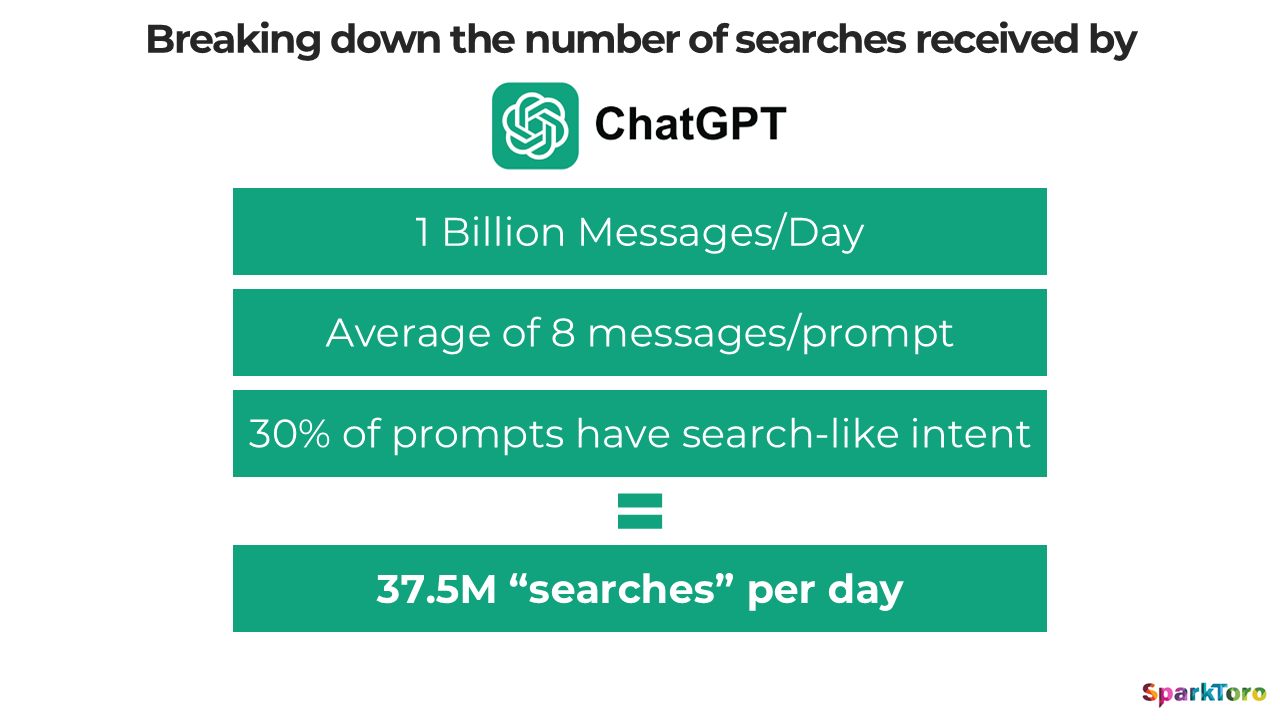

6. Wyszukiwarka Google jest większa od GPT Search… dokładnie 373 razy :D

Ok, wiadomo, że do takich danych trzeba podchodzić z przymrużeniem oka. Ale to pokazuje, że Google wciąż jest największym graczem na rynku wyszukiwania i pewnie przez długi czas się to nie zmieni.

Mówiąc precyzyjniej: Google przetwarza średnio 373 razy więcej wyszukiwań niż ChatGPT. Tak wynika z badania przeprowadzonego przez SparkToro.

Niedawno pisałem, że Google obsługuje ok. 5 bilionów zapytań rocznie, co daje ok. 14 miliardów zapytań każdego dnia. Z takimi wynikami mogą pochwalić się udziałem w rynku na poziomie 93,57%.

Tymczasem GPT dziennie rejestruje ok. 37,5 miliona wyszukiwań, co przekłada się na 0,25% udziałów.

Dla porównania: prześciga go Bing (4,10%), Yahoo (1,35%), a także DuckDuckGo (0,73%).

Ostatnio coraz więcej mówi się o tym, że Google zaczyna potykać się o własne nogi, że użytkownicy nie chcą z niego korzystać, że narzędzia AI „zmiotą” go z rynku i tak dalej, i tak dalej…

Ale fakt jest taki, że przez ostatnie 2 lata prawie wszystkie ich narzędzia zaliczyły wzrosty.