Poszukiwanie sposobów na znalezienie się w czołówce wyników wyszukiwania nie jest niczym nowym. Pozycjonowanie narodziło się razem z wyszukiwarkami, w tym wyszukiwarką Google. Na samym jej początku algorytmy (a właściwie jeden algorytm) dobierania wyników były jednak stosunkowo proste, a co za tym idzie, łatwo było je oszukać.

Jak to robiono? Poprzez stosowanie działań i technik uznawanych dzisiaj za Black Hat SEO. Co to takiego, o jakich technikach mowa i dlaczego nie warto po nie sięgać? To właśnie o tym opowiem Ci w moim artykule!

Przed Tobą zbiór informacji o tym, czego trzeba unikać, jeśli chcesz, by Twoja strona zaprzyjaźniła się z Google :)

Czym jest Black Hat SEO?

Pod potoczną nazwą Black Hat SEO kryją się wszystkie techniki, które są sprzeczne z wytycznymi dla webmasterów dotyczącymi tworzenia i prowadzenia stron internetowych. Google stworzyło te wytyczne w celu zwiększenia jakości stron internetowych oraz publikowanych na nich treści.

Skąd taki krok ze strony Google? Jak już wspomniałem, początki wyszukiwarki i jej algorytmów nie były doskonałe, przez co łatwo było manipulować wynikami. Wraz z rozwojem wyszukiwarki stało się to sporym problemem. Google postanowiło więc coś z tym zrobić, a zaczęło od stworzenia zbioru dobrych praktyk. Później stosowanie technik zaczęło być systematycznie wyplenianie.

Zmiany były wprowadzane na przestrzeni lat. Praktycznie każda seria aktualizacji algorytmów dotycząca poprawy jakości wyników wywoływała dosłowną lawinę spadków widoczności. Nie brakowało też obficie nakładanych kar za niestosowanie się do wytycznych.

Wówczas techniki pozycjonowania naruszające wytyczne zaczęły być stopniowo kojarzone jako szkodliwe i mogące szkodzić stronom. To właśnie od pierwszych poważnych zmian w wyszukiwarce upowszechniać zaczął się termin Black Hat SEO.

Skąd wziął się termin Black Hat SEO?

Określenie Black Hat, czyli dosłownie “czarny kapelusz”, ma korzenie w umownym “kodowaniu kolorami” obecnym w westernach z lat 50. W filmach tych postacie o niecnych zamiarach nosiły zawsze czarne kapelusze, a pozytywni bohaterowie - białe. Schemat ten zaszył się mocno w kulturze i jest używany potocznie po dziś dzień, szczególnie w Stanach Zjednoczonych. “Czarny kapelusz” to nic innego jak czarny charakter.

Aktualizacje, które ukróciły stosowanie technik Black Hat SEO

Jak już wspomniałem, Google ukróciło stosowanie technik Black Hat SEO poprzez aktualizacje wyszukiwarki. Były one wprowadzane na przestrzeni lat, pod różnymi nazwami. Łączył je jednak wspólny cel, a było nim wyeliminowanie z rankingu niskiej jakości stron. Niskiej jakości, czyli takich, które cieszyły się widocznością tylko dzięki np. powielonej treści oraz spamerskiemu linkowaniu.

Poniżej przedstawiam pokrótce trzy aktualizacje Google, które miały zdecydowanie największy wpływ na wyeliminowanie stron stosujących Black Hat SEO.

Panda

Algorytm Panda został wprowadzony 23 lutego 2011 roku. Na początku funkcjonował on w formie filtra. Do algorytmu głównego przyłączono go dopiero w styczniu 2016 roku. Jego głównym celem jest walka ze stronami zawierającymi duplicate content oraz spamem.

Cel ten jest realizowany poprzez obniżanie wartości stron niespełniających wytycznych Google oraz premiowanie w rankingu tych wartościowych. Panda ocenia i weryfikuje jakość treści na stronach dobieranych do wyników wyszukiwania.

Pingwin

Pingwin był kolejnym krokiem do poprawy jakości wyników prezentowanych przez wyszukiwarkę Google. Zawitał w niej 24 kwietnia 2012 roku. To algorytm, który ocenia strony internetowe pod kątem prowadzących do nich linków. Działa sprawdzając profil linków witryn pod kątem ewentualnych prób manipulacji.

Od 23 września 2016, podobnie jak Panda, również funkcjonuje w ramach algorytmu głównego. Ocenia więc dobierane do wyników strony w czasie rzeczywistym.

Pirat

Pirat to algorytm, który pojawił się w sierpniu 2012 roku. Aktualizacja ta miała na celu ukrócenie kopiowania treści objętych prawem autorskim. Pirat pilnuje, by na stronach wyników nie pojawiały się witryny łamiące jakkolwiek prawa autorskie. Celuje przede wszystkim w serwisy oferujące nielegalne pobieranie multimediów. Uderza jednak także w strony, które do nich tylko linkują.

Co ciekawe, Pirat działa nie tylko w samym dobieraniu wyników, ale także w ocenie zgłoszeń. Jeśli dasz znać Google, że na danej witrynie naruszono prawa autorskie, to właśnie algorytm zajmie się tutaj wstępną weryfikacją, a przy oczywistym naruszeniu nałoży też od razu karę.

Jakie działania są uznawane za techniki Black Hat SEO?

Techniki Black Hat SEO to wszystkie działania mające na celu manipulowanie rankingiem wyszukiwarki. Wytyczne dla webmasterów jasno określają, jakie techniki tworzenia i prowadzenia stron internetowych są uznane za prawidłowe i niebudzące wątpliwości algorytmów. To właśnie dlatego stosowanie technik Black Hat SEO może skutkować negatywnymi konsekwencjami, takimi jak obniżenie widoczności, nałożenie filtra lub blokady.

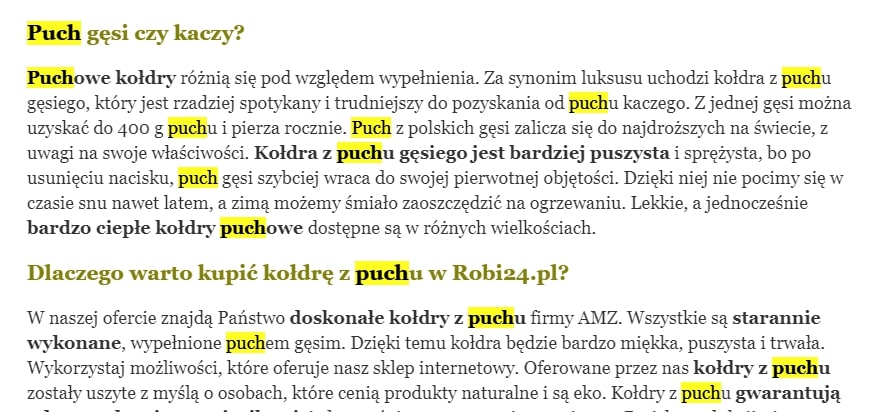

Upychanie słów kluczowych (Keyword stuffing)

Upychanie słów kluczowych to technika, której nie trzeba za szczególnie tłumaczyć. To po prostu nadmierne i nienaturalne używanie słów kluczowych na stronie. Zarówno w głównej treści, jak i w każdym innym jej elemencie, np. stopce. Dotyczy tak samo ilości fraz na podstronie, jak i częstotliwości oraz formy ich występowania. To nic innego jak wpychanie fraz do treści tylko i wyłącznie dla zwiększenia widoczności.

Warto wiedzieć

Keyword stuffing to używanie słów kluczowych w nadmiarze i “na siłę”, w sposób nienaturalny.

Nikt, kto wie cokolwiek o współczesnym SEO, raczej nie pokusiłby się o takie zabiegi na swojej stronie. W Top Online dobór fraz poprzedza zawsze szczegółowa analiza słów kluczowych. Do jednej podstrony pozycjonowanego serwisu przypisujemy maksymalnie kilka fraz. Nasi copywriterzy dbają z kolei o to, by były one rozmieszczone w treści sposób naturalny.

Maskowanie treści (Cloaking)

Cloaking, czyli maskowanie treści, może przybierać różne formy. Zawsze dotyczy on jednak prezentowania w jakiś sposób dwóch różnych wersji strony. Jednej dla użytkowników, a drugiej dla robotów indeksujących. W praktyce wygląda to tak, że użytkownik widzi zazwyczaj grafikę, a robot masę nasyconej frazami kluczowymi treści.

Warto wiedzieć

Cloaking to pokazywanie innej treści użytkownikom, a innej robotom wyszukiwarki.

To jedna z najstarszych i obecnie bardzo sporadycznie już stosowanych technik Black Hat SEO. Nie spotykam się już z nią zbyt często. Jeśli jednak coś takiego się przydarzy, tj. spotkam na audytowanej stronie jakąś formę maskowania treści - natychmiast zgłaszam to Klientowi. Tłumaczę też przy tym, dlaczego warto się tego jak najszybciej pozbyć.

Ukrywanie treści i linków

W tym wypadku zasada jest podobna jak przy maskowaniu:

Warto wiedzieć

Jeżeli chodzi o treść, to wszystko, co zamieszczamy na stronie, ma być widoczne dla użytkownika.

Najpopularniejszym rodzajem tej techniki było niegdyś tworzenie na stronie tekstu o czcionce będącej w tym samym kolorze co kolor tła. Tekst ten był niewidoczny dla użytkownika, ale odczytywały go roboty Google.

Równie popularne było także ustawianie rozmiaru czcionki na 0, umieszczanie treści poza ekranem oraz “chowanie” linków pod jednym znakiem, na przykład w kropce. Tak rozmieszczone treści były wychwytywane przez roboty, ale kompletnie niewidoczne lub banalnie proste do przeoczenia dla większości użytkowników.

Podobnie jak z cloakingiem, mało kto porywa się dzisiaj na tego typu sztuczki. W branży nadal zdarzają się jednak optymiści, który wierzą, że tego rodzaju zabiegi w czymkolwiek pomogą. Tutaj podobnie, jeśli spotkam tego rodzaju rozwiązania na stronie Klienta, zawsze sugeruję możliwie jak najszybsze zmiany.

Treści niskiej jakości

“Content is king”, po prostu. Każdy w branży zna to powiedzenie, każdy słyszał je też setki razy. Jeśli treść ma przynosić w SEO jakieś efekty, musi nieść też w sobie jakąś wartość. Byle jaki, tworzony tylko na ilość, kopiowany lub synonimizowany content na stronie to nie tylko brak szacunku dla użytkownika i proszenie się o wysoki współczynnik odrzuceń. To także Black Hat SEO. W ten sposób nie zdobędziesz już TOP10. W niektórych przypadkach może być ciężko nawet o pierwszą setkę.

Warto wiedzieć

Niskiej jakości treść na stronie nie pomoże Ci w budowaniu widoczności!

W Top Online nad treściami pracuje zespół ponad 12 copywriterów. Nad ich zgodnością ze strategią SEO czuwam zarówno ja, jak i każdy specjalista w teamie. Wszystkie tworzone przez nas teksty zawsze wnoszą rzeczywistą wartość dla użytkownika. Są też w 100% unikalne. Wiemy, jak Google podchodzi do interpretacji treści, dlatego mocny nacisk kładziemy na tematyczność contentu.

Nadużywanie danych strukturalnych

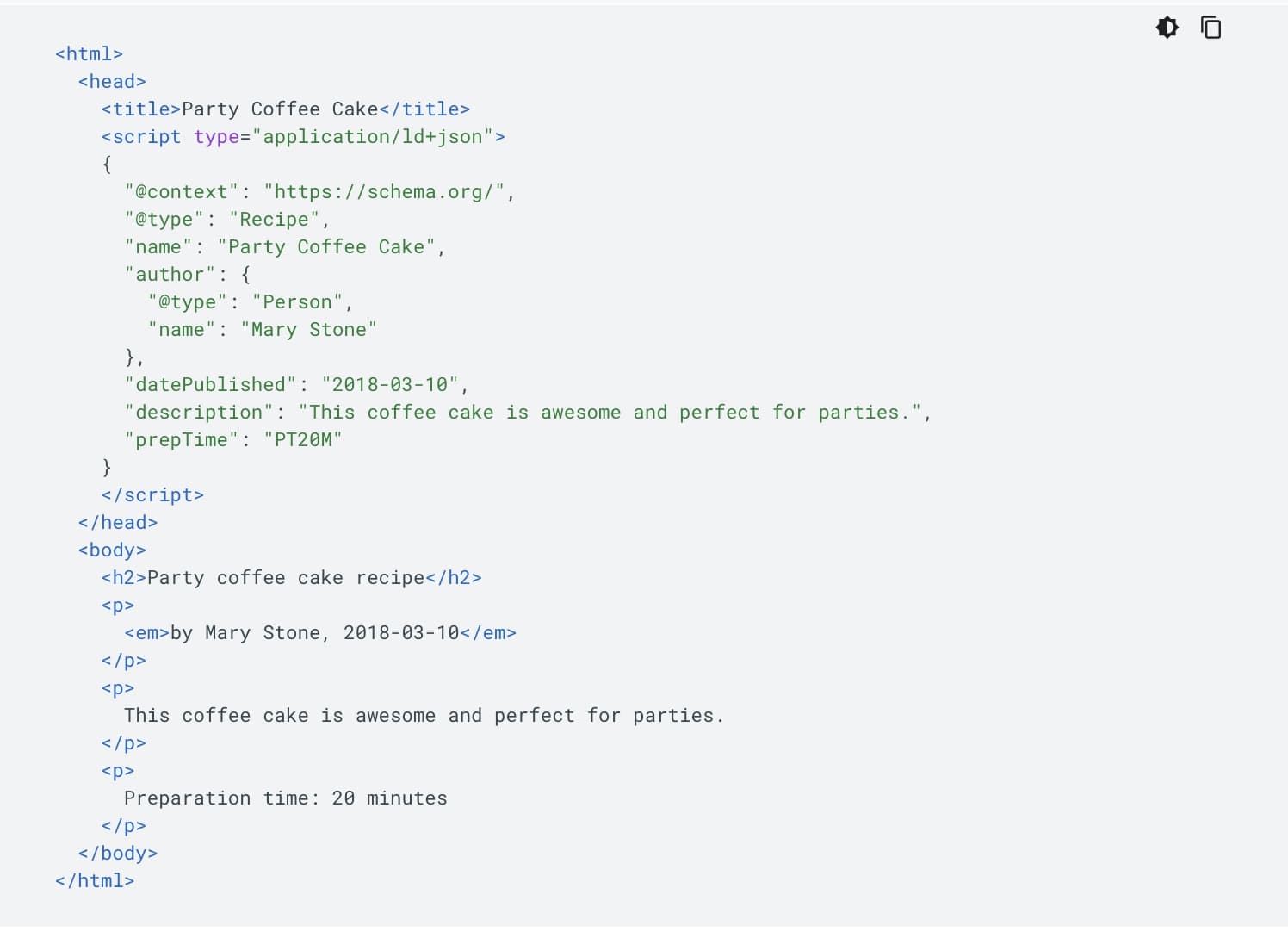

Dane strukturalne, czy inaczej dane uporządkowane, to informacje umieszczane w kodzie strony przede wszystkim dla wyszukiwarek. Mają one wiele zastosowań i aplikacji, najczęściej zamieszcza się je jednak w witrynach w celu uzyskania dodatkowych wyróżnień w wynikach wyszukiwania. Jeśli chcesz dowiedzieć się więcej w tym temacie, przejdź do artykułu Rich snippets, który stworzyliśmy w ramach kursu SEO Samodzielni.

Używanie danych strukturalnych jest w SEO korzystne i wskazane. Nie można jednak tutaj próbować w jakiś sposób “oszukać systemu”. Próby manipulacji rankingiem poprzez dane uporządkowane, takie jak choćby oznaczenie różnymi znacznikami tej samej treści, to już Black Hat SEO.

Warto wiedzieć

Dane strukturalne zawsze powinny być wdrażane zgodnie z przeznaczeniem, nadużycia lub nieprawdziwe informacje kończą się tutaj spadkami widoczności.

Przykład poprawnych danych strukturalnych, zaproponowanych przez Google dla strony z przepisem:

Ukryte przekierowania 301

Jeśli prowadzisz stronę czy sklep internetowy, to pewnie doskonale wiesz, czym są przekierowania. Jeśli nie, nie szkodzi, zajrzyj do naszego kursu SEO Samodzielni, a dokładniej do części Przekierowanie strony internetowej.

Warto wiedzieć

Przekierowania 301 są jak najbardziej potrzebne, nie można jednak używać ich bez celu czy w celu nieuczciwego budowania widoczności.

Przekierowanie przekazuje niemal całą “moc rankingową” z jednej podstrony na drugą. Ten fakt bywa wykorzystywany do podbijania widoczności. W praktyce może jednak skutkować tym, że użytkownik klikający w dany link może być przeniesiony na podstronę kompletnie oderwaną tematycznie od tego, co spodziewał się zobaczyć.

Ze względu na sporą szkodliwość tego typu praktyk, zarówno dla użytkowników, jak i w efekcie skuteczności SEO, w Top Online zawsze weryfikujemy obecność ukrytych przekierowań. Robimy to już w trakcie pierwszego audytu, na początku współpracy z Klientem.

Systemy wymiany linków (SWL)

Na początkach wyszukiwarki Google za pozycję poszczególnych stron w wynikach odpowiadał algorytm PageRank, który zresztą przyczynił się w dużej mierze do sukcesu firmy. Jego działanie było jednak proste do przechytrzenia, opierało się bowiem przede wszystkim na ilości odnośników.

Zamiast zaprzątania sobie głowy pozyskiwaniem linków wiele osób wpadło więc na lepszy pomysł - linkami można się wymieniać. W ten sposób powstały systemy wymiany linków (SWL), dzisiaj uznawane powszechnie za Black Hat SEO i odradzane przez dosłownie każdego specjalistę.

Do SWL można zaliczyć:

- wymianę systemową link za link,

- wszelką automatyzację pozyskiwania odnośników,

- publikacje gościnne mające na celu wyłącznie linkowanie (niewnoszące wartości),

- handel linkami (zarówno kupowanie, jak i sprzedaż odnośników).

Farmy linków

Farma linków to strona lub cały system stron wyłącznie w celu pozyskiwania odnośników (nie mylić z siecią PBN czy indywidualnym zapleczem pozycjonerskim!). Tego rodzaju witryna ma jeden cel: zamieścić jak najwięcej linków. Zazwyczaj z dosłownie byle jakiej treści.

Kłamstwem byłoby powiedzenie, że ilość linków nie ma już znaczenia. Nadal się (dosłownie) liczy. Ważniejsza od ilości odnośników prowadzących do pozycjonowanej strony jest jednak ich jakość. O niej z kolei nie ma mowy, jeśli pozyskujemy linki w taki sposób.

W Top Online linki do stron Klientów (oraz własnych) pozyskujemy tylko i wyłącznie z powiązanych tematycznie artykułów. Tego rodzaju treść jest dla Google naturalnym źródłem pozyskiwania odnośników.

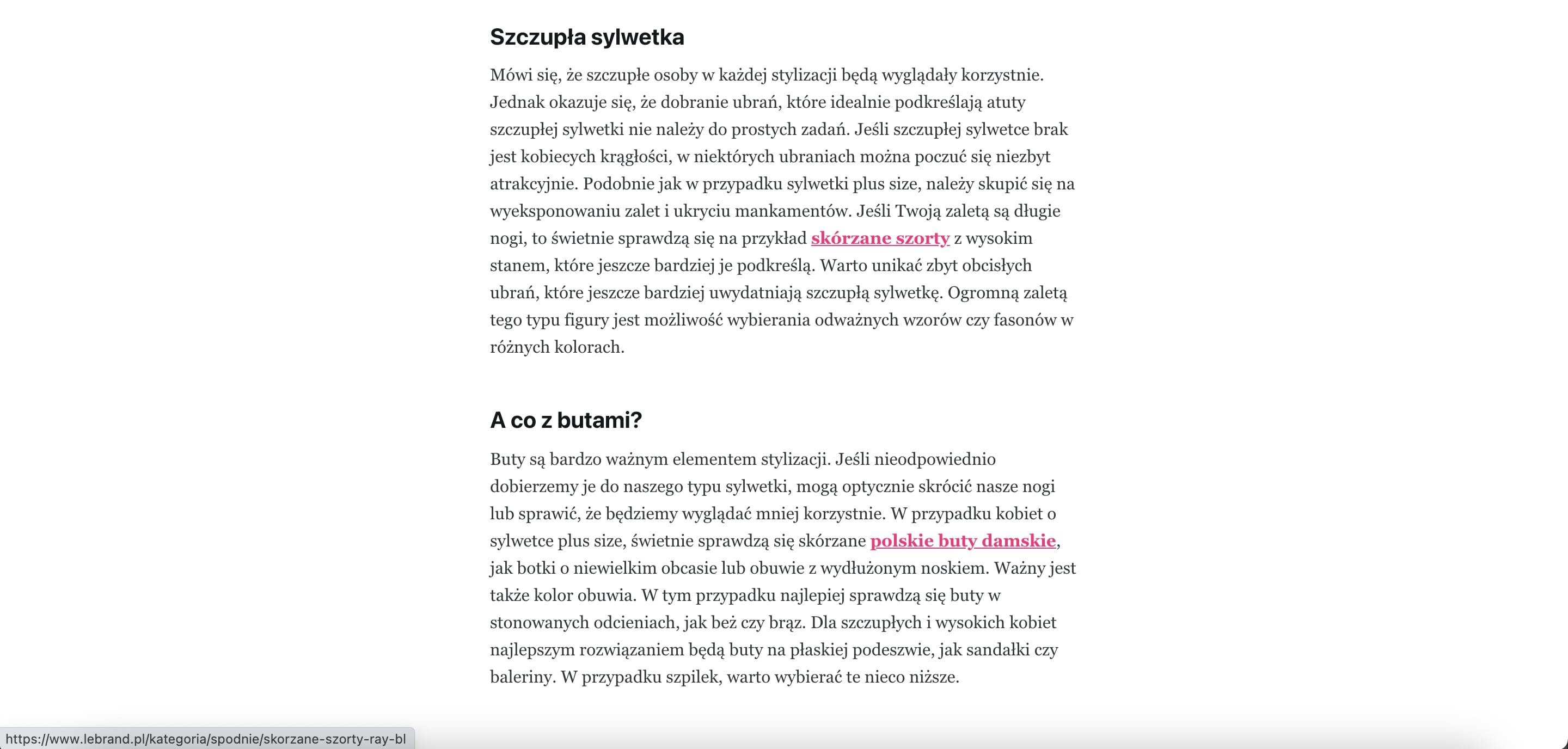

Przykład: nasz klient z branży fashion, dla którego pozyskaliśmy link do jednego z produktów z oferty.

Jeśli jakiś link pojawia się w sieci niezależnie od działań SEO-wców, marketerów czy właściciela strony, to zazwyczaj pojawia się właśnie w artykule blogowym. Gdy ktoś poleci w swoim wpisie daną stronę lub o niej wspomni.

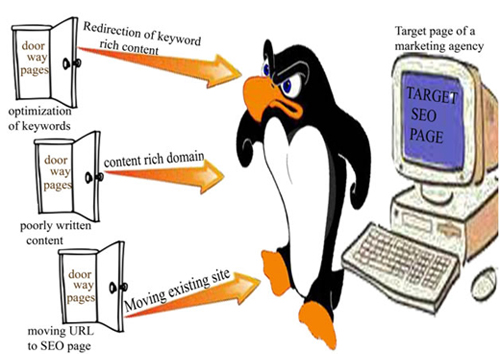

Strony przejściowe (Doorway Pages)

Strona przejściowa to domena lub podstrona służąca tylko i wyłącznie pozyskiwaniu ruchu na określone frazy. Ruch ten jest przekierowywany na właściwą, docelową stronę, co jest niezgodne z wytycznymi Google i może wprowadzać szukających w błąd. Co więcej, taka technika może być też wykorzystana do pozyskiwania ruchu na stronach próbujących oszukać użytkownika.

Stroną przejściową może być zbiór domen przekierowany na jedną, docelową stronę. Za doorway pages można uznać też pojedyncze podstrony tworzone w witrynie tylko po to by przekierowywać je np. na strony ofertowe.

Spamowanie w komentarzach

Nie chodzi oczywiście o spamowanie dla zasady, a o spamowanie linkami do stron, szczególnie pod artykułami blogowymi. Tak, to również jest Black Hat SEO.

Nikt tego nie lubi, ani użytkownicy, ani Google. Mógłbym nawet pokusić się o stwierdzenie, że nie przepadają za tym także osoby robiące to zarobkowo. Próby sztucznego linkowania z komentarzy prędzej poskutkują spadkiem pozycji strony niż jej wzrostem.

Co grozi za stosowanie technik Black Hat SEO?

Wprowadzenie aktualizacji algorytmów przez Google wiązało się również z wprowadzeniem kar dla stron internetowych. Za niestosowanie się do wytycznych dla webmasterów grozi nie tylko obniżenie widoczności. Kary są obecne pod kilkoma postaciami.

Oczywiście kara nie musi pojawić się od razu po wprowadzeniu w życie którejś z technik Black Hat SEO. Zazwyczaj tak nie jest. Zwykle kary pojawiają się po stosunkowo dłuższym okresie, gdy strona zyska już jakąś widoczność i zostanie przez to wychwycona. Ze względu na to są szczególnie bolesne dla osób, które sukcesywnie rozwijały swoją stronę od dłuższego czasu.

Warto wiedzieć

Google nakłada dwa rodzaje kar: filtry oraz bany.

Filtr od Google - czym jest?

Filtr Google to kara polegająca na obniżeniu pozycji strony. Nałożenie jej zazwyczaj odbija się obniżeniem widoczności na frazy o kilkadziesiąt (30-70) pozycji. To kara czasowa, nakładana na okres minimum jednego miesiąca. Co ciekawe, rekordowe czasy trwania filtrów (o których wiemy) sięgają nawet kilku lat.

Filtr może być częściowy (może dotyczyć jedynie części podstron) lub całościowy (może dotyczyć całej witryny. Filtry są nakładane na dwa sposoby, ręcznie lub przez algorytm. Wbrew pozorom, to, w jaki sposób zostały nałożone, ma spore znaczenie.

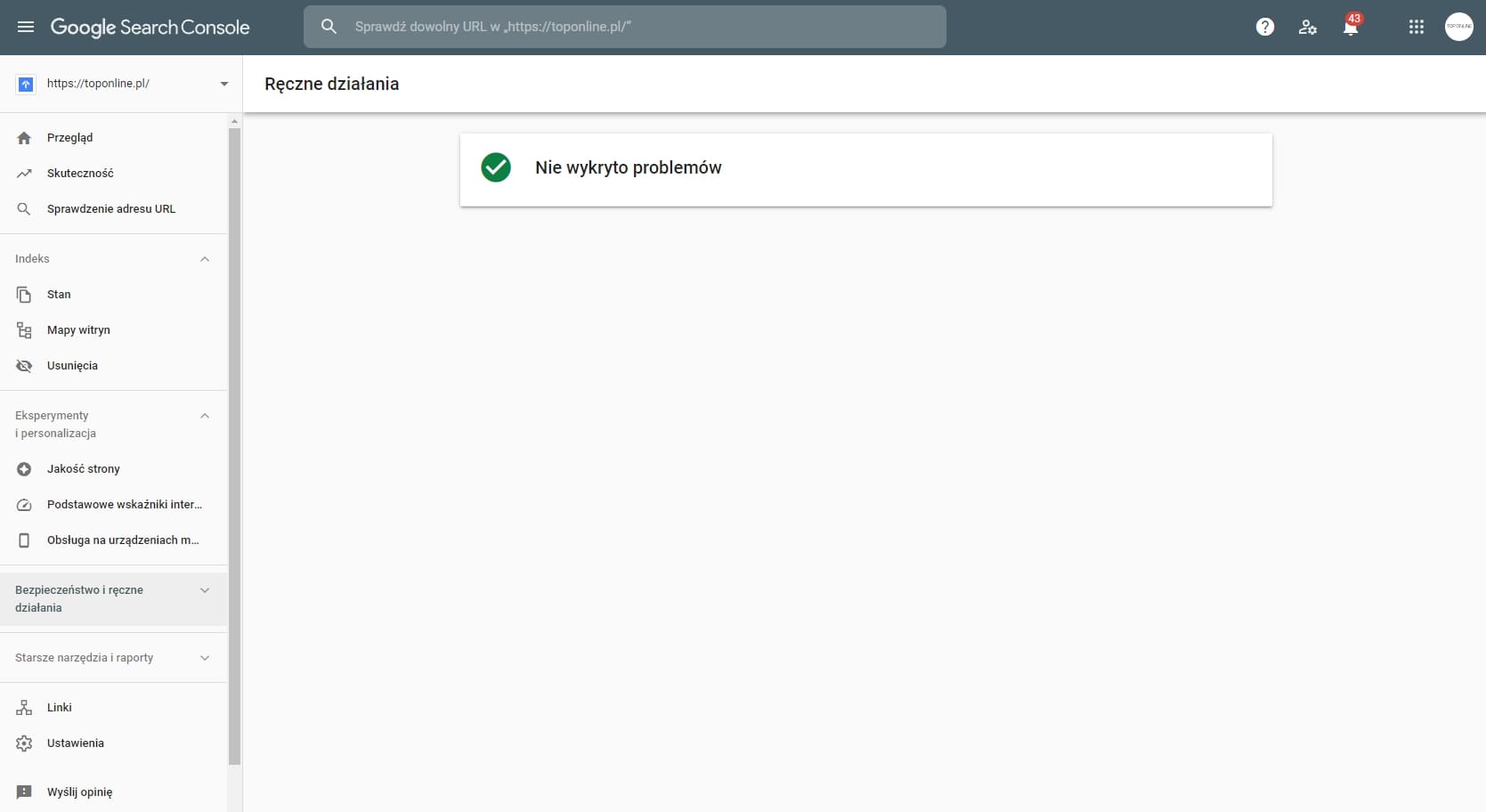

Filtr ręczny

Filtr ręczny to kara za niestosowanie się do wytycznych dla webmasterów nałożona przez pracownika Google.

Jak sprawdzić, czy strona dostała filtr ręczny?

Jeśli na stronę nałożony został filtr ręczny, to informacja o tym zdarzeniu będzie widoczna w Google Search Console. Wystarczy zalogować się do konsoli, wejść na profil witryny i sprawdzić sekcję “Ruch związany z wyszukiwaniem” (a właściwie komunikaty w tej sekcji) oraz raport “Działania ręczne”. Jeśli kara została nałożona w sposób ręczny, to zobaczysz w nim komunikat.

Komunikaty o rodzaju kary ręcznej w Google Search Console

Przy nałożeniu filtra ręcznego Google Search Console zawsze wyświetla informację dotyczące kary. Można z nich wyczytać przyczynę ukarania, zakres nałożonego filtra oraz sposób rozwiązania problemu.

Komunikaty, które można zobaczyć w związku z nałożeniem filtra ręcznego w GSC to:

- Witryna zaatakowana spamem przez osoby trzecie - na części Twojej strony pojawił się spam wygenerowany przez użytkowników lub osoby trzecie,

- Spam tworzony przez użytkowników - na Twojej stronie znajduje się spam przesłany przez Twoich użytkowników,

- Spamerski darmowy host - Twoja strona działa w usłudze hostingowej, która została uznana za źródło spamerskich stron,

- Problem z uporządkowanymi danymi - Twoje podstrony naruszają wytyczne dotyczące danych uporządkowanych

- Nienaturalne linki do Twojej witryny - Twoja witryna posiada nienaturalny, manipulacyjny profil linków,

- Nienaturalne linki z Twojej witryny - Twoja strona linkuje w nienaturalny sposób, co może wskazywać na SWL lub farmę linków,

- Mało treści, w dodatku o niewielkiej lub żadnej wartości - Twoja witryna posiada podstrony z niskiej jakości treścią (m.in. duplicate content oraz doorway pages),

- Maskowanie i niejawne przekierowania - na Twojej stronie wykryto cloacking lub ukryte przekierowania,

- Czysty spam - na stronie zastosowano agresywne techniki zamieszczania spamu, witryna zawiera głównie generowany automatycznie tekst, maskowanie lub duplicate content,

- Maskowanie grafiki - Twoja strona prezentuje różne grafiki robotom Google, a inne użytkownikom (jedna z form cloackingu),

- Ukryty tekst lub upychanie słów kluczowych - Twoja strona zawiera ukryte treści lub stosuje keyword stuffing,

- Niezgodność treści AMP - treść strony AMP jest diametralnie inna od treści jej wersji kanonicznej,

- Niejawne przekierowania na urządzeniach mobilnych - Twoja strona przekierowuje użytkowników urządzeń mobilnych do treści ukrytych przed robotem Google,

- Naruszenia zasad dotyczących Wiadomości i Discover - na Twojej stronie doszło do naruszenia polityki treści w Wiadomościach Google lub usłudze Discover, przy tym komunikacie widoczne jest zawsze wskazanie rodzaju naruszenia.

Szczegóły dotyczące raportu Ręczne działania oraz samych komunikatów znajdziesz w centrum pomocy Google Search Console, w sekcji Raport Ręczne działania.

Czy można odwołać się od kary ręcznej?

I tak i nie. Google nie pozwala odwołać się od kary na zasadzie “uważam, że została nałożona niesłusznie”. Pozwala za to poprosić o ponowne sprawdzenie witryny, co jest szansą na to, by pozbyć się nałożonych ograniczeń.

Warto wiedzieć

Przed wysłaniem prośby o sprawdzenie witryny zawsze rozwiązujemy najpierw problemy, które poskutkowały nałożeniem filtra.

Chcąc pozbyć się kary ręcznej:

- Sprawdzamy, czego dotyczy kara ręczna w Google Search Console i zapoznajemy się z opisem komunikatu w raporcie Ręczne działania.

- Sprawdzamy, których podstron dotyczy nałożony filtr.

- Rozwiązujemy wskazany przez Google problem na wszystkich stronach objętych karą.

- Sprawdzamy, czy wyszukiwarka może poprawnie indeksować podstrony objęte filtrem.

- Klikamy “Poproś o sprawdzenie” w raporcie Ręczne działania i uzupełniamy i wysyłamy prośbę.

Warto wiedzieć

Zgodnie z wytycznymi Google, każda prośba o ponowne sprawdzenie strony powinna zawierać:

- Przedstawienie problemu, który poskutkował nałożeniem kary,

- Opis wprowadzonych poprawek,

- Udokumentowanie efektów zmian na stronie.

Filtr algorytmiczny

Filtr algorytmiczny to kara nałożona automatycznie, przez algorytm. W przeciwieństwie do kary ręcznej nie jest ona widoczna w Google Search Console. Zarówno samo nałożenie filtra algorytmicznego, jak i jego przyczyna są trudne do zidentyfikowania. Równie trudne jest też zdjęcie tej kary przed czasem.

Jak sprawdzić, czy strona dostała filtr algorytmiczny?

Niestety, nie istnieje sposób pozwalający uzyskać 100% pewności co do tego, że na stronę nałożono filtr algorytmiczny. Jedyną przesłanką może być tutaj nagła strata pozycji lub ruchu, widoczna w analizie widoczności witryny.

Jeśli strona cieszyła się stosunkowo wysokimi pozycjami na frazy, a teraz są one w bardzo odległych miejscach lub poza indeksem, to może (ale nie musi) być to efekt nałożenia filtra algorytmicznego. Nagły spadek może być spowodowany zmianami w algorytmach, które spowodowały “rekalkulację” wyników wyszukiwania.

Ban od Google - czym jest?

Ban od Google zdarza się stosunkowo rzadko i dotyczy naprawdę poważnych przewinień. Ten rodzaj kary skutkuje wykluczeniem całej strony z wyników wyszukiwania. Po otrzymaniu bana witryna jest kompletnie niewidoczna w Google i nie będzie już indeksowana. Jedynym sposobem na jej odwiedzenie staje się wówczas wpisanie w przeglądarce dokładnego adresu.

Co ważne, w przeciwieństwie do filtrów, bana nie można dostać za czynniki niezależne od webmastera. Kara ta jest nakładana tylko i wyłącznie za przewinienia związane z zawartością strony, takie jak maskowanie czy strony przejściowe.

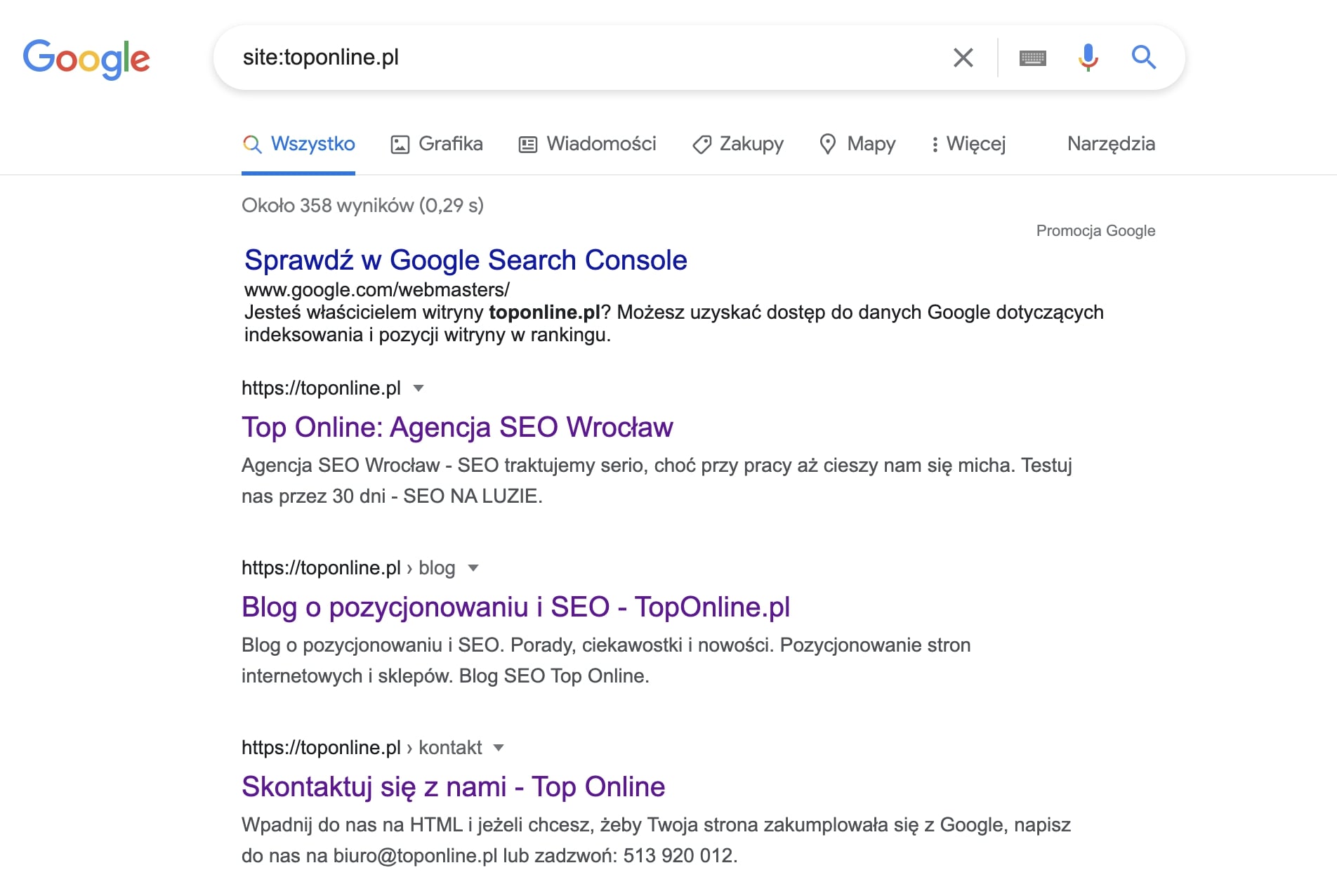

Jak sprawdzić, czy strona dostała ban od Google?

Sprawdzenie, czy na stronę został nałożony ban, jest banalnie proste. Wystarczy wyszukać w Google adres witryny poprzedzony komendą site:, np. site:example.com. Brak wyników świadczy o wyłączeniu z indeksu, tj. nałożeniu bana.

Warto wiedzieć

Brak wyników wyszukiwania może wynikać też z tego, że strona nie została jeszcze po prostu zindeksowana (np. dlatego, że jest nowa).

Możliwe też, że została wyłączona z indeksu poprzez dyrektywę “noindex” w kodzie strony lub inny błąd w konfiguracji. Podejrzewając bana, zawsze upewniamy się, czy indeksacja strony w Google przebiega prawidłowo i czy nie została w jakiś sposób ograniczona.

Jak sprawdzić, czy strona dostała ban od Google?

Oczywiście, podobnie jak od filtra ręcznego. W praktyce, jeśli strona rzeczywiście dostała bana, to próby pozbycia się go są w większości przypadków nieopłacalne. Poza sporadycznymi sytuacjami, w których mówimy o naprawdę dużych serwisach, które jakimś cudem dostały bana, znacznie szybciej i taniej jest zazwyczaj stworzyć stronę od nowa. Z upewnieniem się, że wszystko jest tym razem realizowane zgodnie z wytycznymi dla webmasterów.

Załóżmy, że chcemy odwołać się od bana na stronie, co trzeba zrobić?

Przede wszystkim, upewniamy się, że nieobecność witryny w indeksie wynika właśnie z bana, wykluczamy wszystkie inne możliwości. Następnie szukamy na stronie przewinień, które poskutkowały nałożeniem blokady oraz naprawiamy sytuację i upewniamy się, że strona jest zgodna z wytycznymi dla webmasterów.

Dopiero wówczas, gdy wszystko będzie już naprawione, wnioskujemy o ponowne sprawdzenie witryny. Tutaj również, ważne jest, by uzasadnić odpowiednio zgłoszenie (podobnie jak przy odwołaniu się od filtra ręcznego).

Dlaczego nie stosujemy i nigdy nie będziemy stosować Black Hat SEO?

W Top Online kładziemy bardzo duży nacisk na jakość naszych działań, a to wiąże się w SEO bezpośrednio z trzymaniem się wytycznych dla webmasterów stworzonych przez Google. Takie podejście pozwala nam rozwijać strony Klientów w sposób bezpieczny i kontrolowany. Bez podejmowania ryzyka związanego z karami za stosowanie zakazanych technik Black Hat SEO.

Algorytmy Google są coraz to dokładniejsze, przez co większość opisanych przeze mnie tutaj technik jest teraz wykrywana i karana zaskakująco szybko. Naprawdę, nie jest to gra warta świeczki. Każdemu, kto zajmuje się pozycjonowaniem, niezależnie - swojej, czy czyjejś strony, radzę, w imieniu całego zespołu Top Online:

Warto wiedzieć

Nie stosuj technik Black Hat SEO!

Podsumowując krótko mój artykuł:

- Black Hat SEO to zbiorcza nazwa wszystkich technik tworzenia i pozycjonowania stron, które są sprzeczne z wytycznymi dla webmasterów opracowanymi przez Google.

- Google walczy ze stosowaniem technik Black Hat SEO poprzez aktualizacje algorytmu wyszukiwarki.

- Trzy najgłośniejsze aktualizacje, które ukróciły stosowanie niezgodnych z wytycznymi technik to algorytmy: Panda, Pingwin oraz Pirat.

- Algorytm Panda walczy ze słabą jakością treści, Pingwin walczy z manipulacyjnym link buildingiem, a Pirat zapobiega naruszeniom praw autorskich.

- Panda oraz Pingwin funkcjonują obecnie w ramach algorytmu głównego, weryfikując witryny na bieżąco, w czasie rzeczywistym.

- Techniki Black Hat SEO to m.in.:

- maskowanie oraz ukrywanie treści i linków,

- upychanie słów kluczowych,

- publikowanie treści niskiej jakości,

- korzystanie z SWL i farm linków,

- tworzenie tzw. Doorway Pages lub ukrytych przekierowań.

- Poza gorszą skutecznością pozycjonowania, stosowanie technik Black Hat SEO grozi otrzymaniem kary od Google - filtra lub bana.

- Filtry to kary czasowe, obniżające widoczność części lub wszystkich podstron w ukaranym nimi serwisie na frazy kluczowe o kilkadziesiąt pozycji.

- Filtry ręczne to kary nakładane przez pracowników Google, wskazywane w Search Console i możliwe do zdjęcia po naprawieniu problemów.

- Filtry algorytmiczne to kary nakładane automatycznie, bardzo trudne do zidentyfikowania. Odwołanie się od nich jest praktycznie niemożliwe.

- Ban od Google to kara skutkująca całkowitym wyłączeniem strony z indeksu wyników wyszukiwania.

- Bany są nakładane tylko i wyłącznie za poważne przewinienia dotyczące zawartości strony.

- Odwołanie się od każdej kary Google wymaga zidentyfikowania i naprawienia wszystkich przyczyn jej nałożenia oraz udokumentowania zmian.

- Większość technik Black Hat SEO jest dzisiaj wykrywana i karana bardzo szybko.

- W Top Online nie stosujemy i nigdy nie będziemy stosować technik Black Hat. SEO traktujemy serio :)

![[object Object] - Top Online](https://cdn.toponlineapp.pl/7474-hubert.png)