ChatGPT jest super, ale ma parę ograniczeń, przez które może nieźle namieszać, a nawet stworzyć realne zagrożenie. Oto lista czynności i zadań, przy których lepiej nie korzystać ChatuGPT.

Spis treści:

- ChatGPT zmyśla. Czym jest, skąd się bierze i jak działa halucynowanie ChatuGPT

- Pozyskiwanie specjalistycznych informacji technicznych

- Diagnozowanie stanu zdrowia

- Pozyskiwanie pomysłów na inwestycje

- Sprawdzania, czy dana informacja jest prawdziwa

- Podejmowanie decyzji

- Wszystko, co uwzględnia wrażliwe dane

- Tworzenie treści bez weryfikacji

- Podsumowanie w punktach

ChatGPT zmyśla. Czym jest, skąd się bierze i jak działa halucynowanie ChatuGPT

ChatGPT ma za zadanie prowadzenie z nami rozmowy w formie czatu, a konkretnie generowanie odpowiedzi na nasze wiadomości. W praktyce jest to „opakowany” w interfejs duży model językowy wytrenowany na ogromnej ilości danych – głównie tekstów.

Cały problem z jego „zmyślaniem” bierze się stąd, że trenowanie (uczenie) takiego modelu nie przebiega tak, jak proces nauki u ludzi. Model językowy nie zdobywa wiedzy i nie uczy się z niej korzystać tak jak człowiek.

W dużym uproszczeniu uczy się on raczej prawdopodobieństwa występowania po sobie słów w zależności od kontekstu.

Gdy zapytam czat „Kto był prezydentem Polski w latach 1990-1995?”, to odpowie mi prawidłowo: Lech Wałęsa. Nie stanie się tak jednak dlatego, że zna on nowoczesną historię Polski.

Taka odpowiedź pojawi się tylko dlatego, że w treściach analizowanych w procesie uczenia, były zdania mówiące, że „w latach 1990-1995 prezydentem Polski był Lech Wałęsa”.

Wiesz, co z tego wynika?

Mniej więcej to, że gdyby z jakiegoś powodu w danych treningowych pojawiło się więcej zdań mówiących „w latach 1990-1995 prezydentem Polski był Aleksander Kwaśniewski” to czat kłamałby jak z nut.

Warto wiedzieć

Cała „wiedza” ChatGPT polega na dobieraniu słów najczęściej występujących po sobie w danym kontekście – a częstotliwość ta pochodzi z danych wejściowych, które nie muszą być zgodne z prawdą.

Jak to działa?

Gdy ChatGPT generuje odpowiedź na pytanie, to określa najpierw kontekst odpowiedzi. W przykładzie, który podałem powyżej, kontekst jest oczywisty. Chodzi o historię Polski w podanych latach i o ówczesnego prezydenta.

Na podstawie określonego kontekstu wygenerowane zostaje pierwsze słowo odpowiedzi, czyli „Prezydentem”.

Następnie, już na podstawie wszystkich danych, które zostały użyte podczas procesu uczenia, model oblicza, jakie słowo ma największe prawdopodobieństwo pojawienia się jako kolejne.

W kontekście tak zadanego pytania około 90% prawdopodobieństwa miałoby pewnie słowo „Polski”. Potem „w”, „latach”, „1990 - 1995”, „był”... i tak dalej, i tak dalej. Aż, słowo po słowie, czat wygeneruje w końcu, że „Prezydentem Polski w latach 1990-1995 był Lech Wałęsa”.

W przypadku takich prostych pytań czat zapewne miał bardzo dużo danych, na których mógł się odpowiednio przeszkolić i teraz z łatwością odpowiada zgodnie z prawdą.

Wciąż pozostaje jednak mnóstwo tematów, które nie zostały aż w tak dobrze uwzględnione w treściach, na których był szkolony. Wtedy przewidywanie kolejnych słów często nie jest już tak skuteczne.

Co jeśli dane treningowe mówią różne rzeczy?

No właśnie, mało danych wejściowych to jedno, ale przecież czat mógł dostać równie dużo tekstów kompletnie ze sobą sprzecznych. Co wtedy?

Żeby to pokazać na przykładzie, załóżmy, że model językowy dostał równie dużo informacji o tym, że ziemia jest okrągła i o tym, że jest płaska.

Co się stanie, jeśli wtedy go z tego odpytam?

Najprawdopodobniej, przy obliczaniu prawdopodobieństwa wystąpienia kolejnego słowa wyjdzie mu, że jako kolejne słowo w zdaniu „Ziemia jest” na 50% wystąpi „okrągła”, a na 50% „płaska”.

Przykład z kształtem ziemi jest oczywiście skrajny i ChatGPT aż takich bzdur raczej nie wygeneruje. Piszę o nim tylko po to, żeby dobitnie pokazać schemat działania.

Generowanie takich bzdur to halucynacja AI

Halucynowanie to właśnie pisanie takich bzdur przez czat (i ogólnie: przez model językowy).

Zadaniem ChatGPT, tak jak wspomniałem już na początku, jest po prostu generowanie odpowiedzi, a nie generowanie odpowiedzi prawidłowej. Sam model językowy nie wie nawet, co jest prawidłowe, a co nie.

OpenAI doskonale zdaje sobie sprawę z tego problemu, dlatego implementuje dodatkowe zabezpieczenia. Stąd np. pojawiające się czasem odpowiedzi, mówiące wprost, że czat nie czytał nic na dany temat i nie ma wiedzy potrzebnej, żeby odpowiedzieć na pytanie.

Mimo to, ChatGPT i tak gubi się czasem w miliardach słów, na których został wytrenowany. Dalej zdarza się więc, że wygeneruje słowo po słowie, coś, co może i brzmi, jak prawidłowa definicja, ale w rzeczywistości nie ma z nią nic wspólnego.

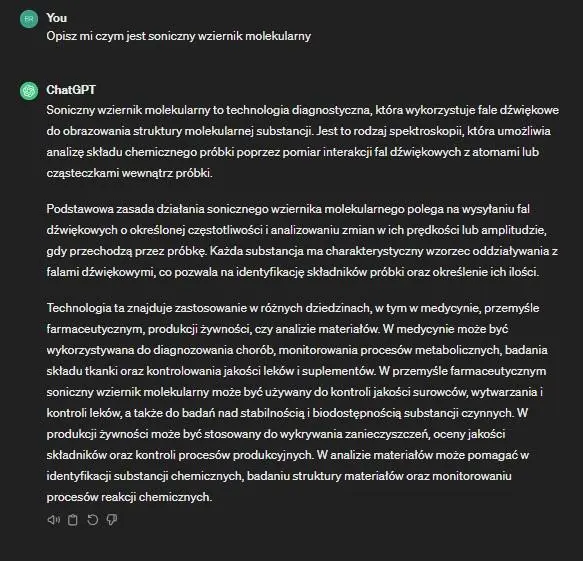

Przykład? Proszę bardzo, definicja „sonicznego wziernika molekularnego”:

Tak, dobrze Ci się wydaje. Nie ma czegoś takiego jak „soniczny wziernik molekularny”.

ChatGPT kojarzy jednak pojedyncze słowa, z których stworzyłem tę nazwę. Odnajduje je w treściach, na których był szkolony i potrafi dopasować do jakiegoś naukowego kontekstu.

Dzięki temu mimo wszystko generuje odpowiedź i tworzy całkowicie fikcyjną definicję nieistniejącego przedmiotu.

I to jeszcze byłoby nic, ale co gorsza, to samo dzieje się przy przedmiotach i pojęciach istniejących. Zwykle im bardziej specjalistyczne informacje, tym większa szansa na halucynacje.

Pozyskiwanie specjalistycznych informacji technicznych

Jak pokazał przykład „sonicznego wziernika molekularnego”, specjalistyczne definicje nie są mocną stroną ChatuGPT. Stąd pierwsza rzecz, przy której wolałbym na nim nie polegać: pozyskiwanie wszelkich specjalistycznych informacji (zwłaszcza technicznych).

Warto wiedzieć

Chcesz przekonać się, jak bardzo czat może bredzić na jakiś temat? Pogadaj z nim o czymś, na czym bardzo dobrze się znasz – tylko koniecznie dopytaj o niuanse, szczegóły i konkretne wartości :)

Skąd problemy ze specjalistycznymi informacjami?

Myślę, że przede wszystkim stąd, że wszelkie dokumentacje techniczne brzmią podobnie, a w dużej mierze też nie są łatwo i publicznie dostępne. Stąd czat po pierwsze mógł nie mieć ich w danych szkoleniowych, a po drugie (nawet jeśli były) – nie jest w stanie ich rozróżnić.

Ogólnie być może coś opowie, ale o szczegółową instrukcję rozdzielenia nagłówka H1 od nazwy kategorii w Shoperze raczej bym go nie prosił.

Diagnozowanie stanu zdrowia

Kolejna rzecz, której unikam: nie opisuję w ChatGPT objawów swojej dolegliwości z prośbą o diagnozę. Wszyscy diagnozujemy się szukając w Google, ale spójrzmy prawdzie w oczy: od tego jest lekarz.

Śmiem twierdzić nawet, że diagnozowanie sobie chorób z ChatemGPT może mieć jeszcze mniejszą skuteczność niż zwykłe szukanie objawów po znanych stronach internetowych.

W internecie pojawiało się mnóstwo clickbaitowych artykułów, mówiących, że „Sztuczna inteligencja zdiagnozowała chorobę, którą przeoczyli wszyscy lekarze”. Albo, że „AI wykryło chorobę na X lat wcześniej”.

Nie twierdzę, że to kłamstwo. Chodzi tylko o to, że pojęcie „sztucznej inteligencji” to nie tylko ChatGPT. Istnieje mnóstwo algorytmów, modeli językowych i sieci neuronowych tworzonych w różnych celach, a większość z nich nie jest publicznie dostępna.

Wśród nich znajdą się i te, które są szkolone przez specjalistów z różnych dziedzin nauki, w tym medycyny. I to właśnie ta sztuczna inteligencja, potrafi np. przeanalizować rozbudowaną, skomplikowaną dokumentację medyczną i wyciągnąć z niej poprawne wnioski.

Te modele są jednak tworzone tylko do tego jednego celu, a często nawet stricte pod kątem wykrywania tylko jednej konkretnej choroby. No i prezentowane przez nie wyniki i tak zawsze są interpretowane przez prawdziwych lekarzy.

Tak samo słabym pomysłem jak diagnozowanie ludzkiego zdrowia może okazać się też diagnozowanie stron internetowych, czyli proszenie ChatuGPT o sprawdzenie pozycjonowania. Podstawowy audyt SEO lepiej zrobić samemu :)

Pozyskiwanie pomysłów na inwestycje

Podobnie co do możliwości diagnoz medycznych, równie dużo artykułów pojawiających się w okresie rozkwitu ChatuGPT, mówiło o tym, jak to wymyślił on świetny pomysł na biznes.

To już totalna bzdura bez żadnego drugiego dna.

Jeżeli nie masz pomysłu na biznes, to ChatGPT go za Ciebie nie wymyśli. Może co najwyżej zaproponować jakieś kombinacje, które przeoczyłeś/aś rozważając opcje, albo wyhalucynować jakieś bujdy.

Zdecydowanie odradzam więc planowanie inwestycji na bazie tego, co wygeneruje ChatGPT. Ewentualnie… jeśli faktycznie masz za dużo pieniędzy i nie wiesz, co z nimi zrobić, to mogę podać Ci mój numer konta :)

Tak samo jak nie ufam wygenerowanym podpowiedziom co do finansów, tak też nie używam czatu do planowania strategii SEO.

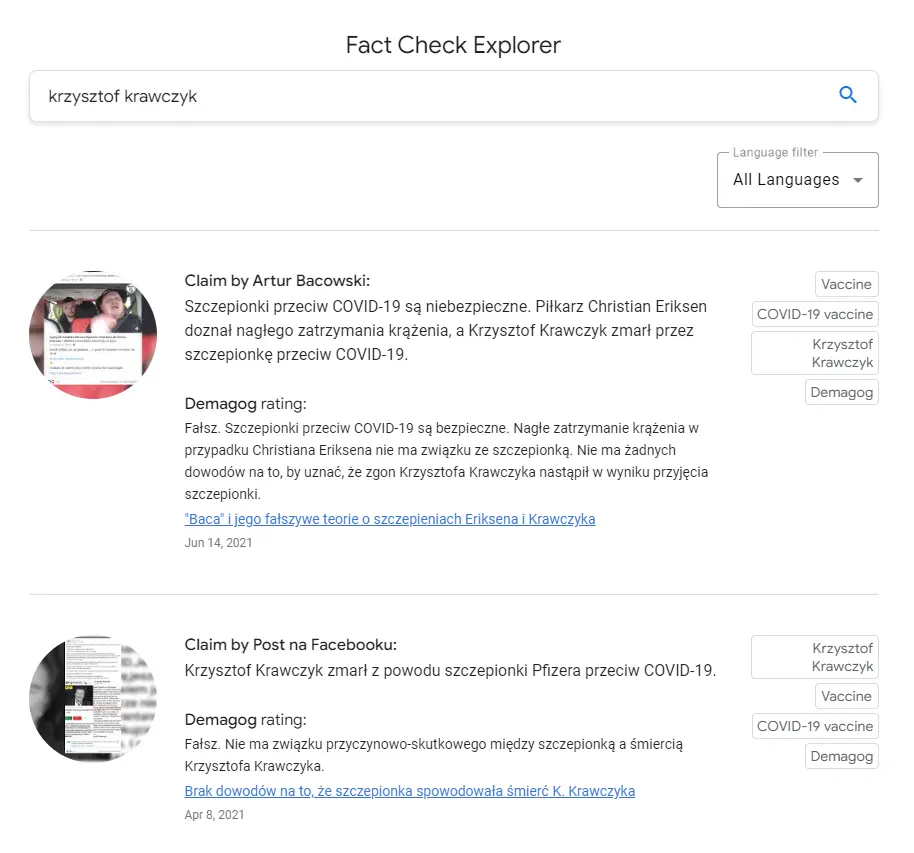

Sprawdzania, czy dana informacja jest prawdziwa

Kolejna sytuacja, w której warto być ostrożnym, to pozyskiwanie informacji i weryfikowanie ich prawdziwości. Jedno wynika z drugiego – skoro ChatGPT może nie mieć wiedzy i po prostu zmyślać na jakiś temat, to raczej nie podoła też sprawdzaniu, czy coś jest prawdą.

ChatGPT może mi porównać treść jednego wskazanego artykułu z innymi lub ze swoją bazą wiedzy, ale nigdy nie da stuprocentowej pewności co do tego, że dana informacja jest prawdziwa lub fałszywa.

Jeśli chcę mieć pewność co do prawdziwości newsów, to sięgam po zaufane źródła. Na przykład odwiedzam stronę stowarzyszenia Demagog, albo szukam w Google Fact Check Explorerze, który indeksuje pracę takich organizacji fact-checkingowych.

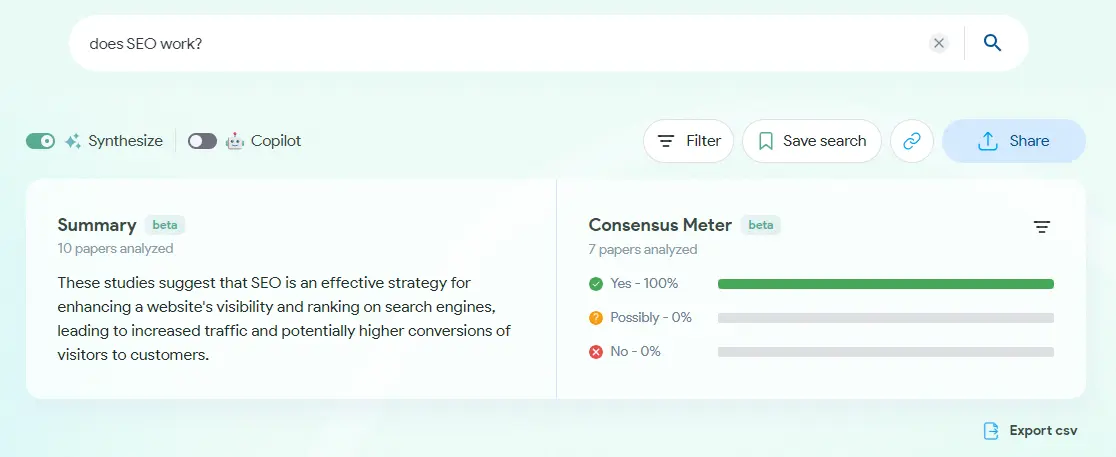

Jeśli potrzebuję sprawdzić informacje bardziej ogólne, to korzystam z AI wyszukującego informacji w publikacjach naukowych. Jedno z bardziej znanych rozwiązań tego typu to Consensus.

Podejmowanie decyzji

Kolejne zastosowanie ChatuGPT, którego unikam, to decydowanie za pomocą czatu. Tutaj jednak z dużym ALE: ChatGPT sprawdza się świetnie w proponowaniu rozwiązań, a nawet odtwarzaniu całych procesów decyzyjnych.

Fakt istnienia halucynacji AI sprawia jednak, że czat nigdy nie powinien podejmować decyzji bez naszej kontroli / interakcji.

Sugerować decyzje? Pewnie! Podpowiadać wybór? Jak najbardziej. Decydować za mnie samodzielnie? Nigdy.

Przykładowo, w pracy nad stronami klientów, często proszę ChatGPT o pomysły na frazy kluczowe. Nigdy jednak nie oddałbym mu samego ich ostatecznego wyboru, nawet gdybym wkleił mu razem z nimi dane o potencjale czy konkurencyjności.

Wszystko, co uwzględnia wrażliwe dane

Imię i nazwisko to jeszcze pół biedy, ale gorzej jeśli wpadłbym na pomysł wklejenia do czatu całej treści CV, jakiegoś dokumentu zawierającego adresy, numery dokumentów, czy pesel.

Albo – żeby nie było tak stricte osobowo – kodu, w którym są klucze API, hasła czy inne ważne dane dostępowe.

Warto wiedzieć

Domyślnie OpenAI może wykorzystać do szkolenia swoich modeli wszystko, co wpiszemy do ChatGPT – a wszystko co w szkoleniu, może pojawić się też w odpowiedziach.

Prosta zasada: jeśli chcę, żeby czat pomógł mi z treścią dokumentu, np. CV czy listu motywacyjnego, to usuwam z niego wszystko, czego nie chciałbym wrzucać publicznie do internetu. I tak samo robię, gdy ma mi pomóc z opracowaniem fragmentu kodu.

OpenAI oczywiście filtruje dane, żeby usunąć z nich wszelkie wrażliwe informacje, a samo przekazywanie danych do szkolenia można wyłączyć w ustawieniach, ale i tak. Wyznaję zasadę, że lepiej nie ryzykować i Tobie też ją polecam :)

Tworzenie treści bez weryfikacji

Tym razem czynność zahaczająca bezpośrednio o pozycjonowanie stron, czyli generowanie treści z AI. Ogólnie można to robić, ale w praktyce nigdy nie pokusiłbym się o opublikowanie na stronie tekstu wygenerowanego 1:1, tak jak „wypluł” go ChatGPT.

Trochę składają się na to powyższe punkty – praktycznie zawsze potrzebna będzie weryfikacja faktów i edycja.

Publikowanie tekstów „na ilość” bez ich sprawdzania to już w ogóle zły pomysł – a zarazem Black Hat SEO. Jakiś czas temu Google zaczęło banować za to strony – kompletnie wyindeksowując je z wyników.

Warto wiedzieć

Wyszukiwarce nie przeszkadza to, że tekst został napisany przez AI, problemem są jego niska jakość, duplikacja treści i nieprawdziwe informacje.

Ten punkt tyczy się tak samo wszelkiego tworzenia treści, również tego nie do internetu, czyli np. pisania prac naukowych. To proszenie się o problemy.

Podsumowanie w punktach

- ChatGPT zmyśla, taka jest jego „natura” i wynika to bezpośrednio z działania modeli językowych.

- Stąd nigdy nie korzystam z ChatuGPT do pozyskiwania specjalistycznych informacji technicznych.

- Brak specjalistycznej wiedzy sprawia, że złym pomysłem jest też diagnozowanie swoich objawów zdrowotnych z czatem.

- ChatGPT nie jest także czymś, co jest w stanie podpowiedzieć w kwestii inwestowania czy biznesu.

- To, że nie dysponuje on wiedzą, tylko przewiduje kolejne słowa, sprawia, że nie da się w nim sprawdzić wiarygodności informacji.

- Nie jest również najlepszym decydentem, choć tu trzeba przyznać, może skutecznie podpowiadać.

- Kolejne zastosowanie, a raczej grupa zastosowań, których warto się wystrzegać w ChatGPT to wszystko to, co wymaga użycia wrażliwych danych.

- Nie pokusiłbym się także o generowanie i publikowanie treści bez ich dokładnego sprawdzenia i zedytowania.

![[object Object] - Top Online](https://cdn.toponlineapp.pl/4042-Brajan-Pogwizd.png)