Większość marketerów chce zwiększać budżety na SEO. Google testuje nowy układ SERP. Tag lastmod w mapie strony jest dla wyszukiwarki zerojedynkowy. Poza tym: zmiany w crawlerach Apple, automatyczne dane GMC, Google vs błędy AI, blokowanie linków wew. i koniec stron z GMF.

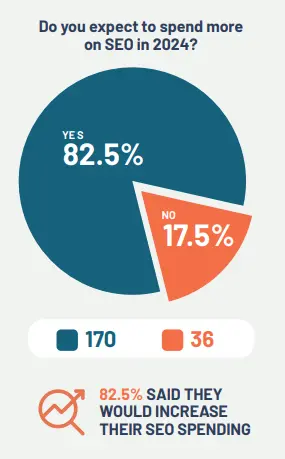

1. 82,5% marketerów planuje zwiększyć budżet na SEO w tym roku

Agencja Ignite Visibility opublikowała wyniki badania ankietowego dot. strategii SEO na 2024 rok.

Jak się okazuje, 82,5% marketerów planuje zwiększyć w tym roku swoje budżety na pozycjonowanie, a ich największa część ma zostać przeznaczona na content marketing.

Dodatkowo: najtrudniejsze wyzwania w SEO w 2024 roku według badanych to: tworzenie wysokiej jakości treści (21,4%), ograniczenia budżetowe (20,4%) oraz rosnąca konkurencja (19,9%).

Za największe zagrożenia dla branży postrzegane są z kolei: uczenie maszynowe i AI (32% badanych), regulacje prawne (15,5%) oraz Search Generative Experience (14,6%).

W badaniu wzięło udział 206 „ekspertów marketingu”. 70% badanych to osoby mające ponad 5 lat doświadczenia w SEO, a 20% – osoby go mające ponad 10 lat.

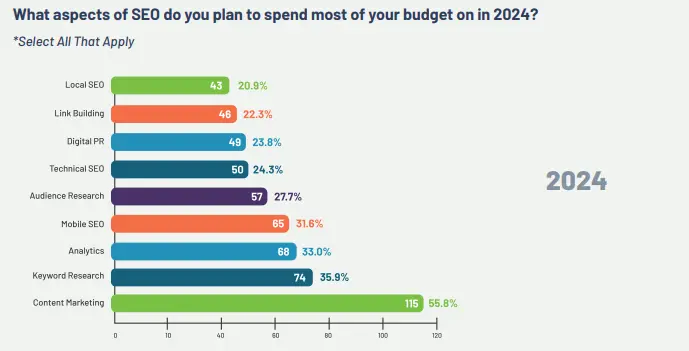

2. Google testuje „zorganizowane” strony wyników wyszukiwania

Google testuje w USA „zorganizowane” strony wyników. W ramach eksperymentu wyszukiwarka sortuje witryny według kategorii i tematów:

Jak widać na screenshocie, wyniki na frazie „best smoker grill combo” (najlepszy grill z wędzarnią), są podzielone na „Top-owe strony sklepów”, „Produkty z sieci”, czy „poradniki zakupowe”.

A co wyróżnia ten test spośród setek innych?

Po pierwsze, nie jest to byle test, bo takie sortowanie wyników zostało zapowiedziane na Google I/O 2024 (SEO News #135 – Google I/O 2024). Funkcja ma więc spore szanse, żeby trafić do wyników na stałe.

No a po drugie: taka zmiana kompletnie wywraca do góry nogami układ stron na frazach zakupowych. W tych wynikach nie ma już TOP10, są za to różne niezależne listy „TOP”, w zależności od intencji użytkownika (kategorii treści), które można rozwinąć.

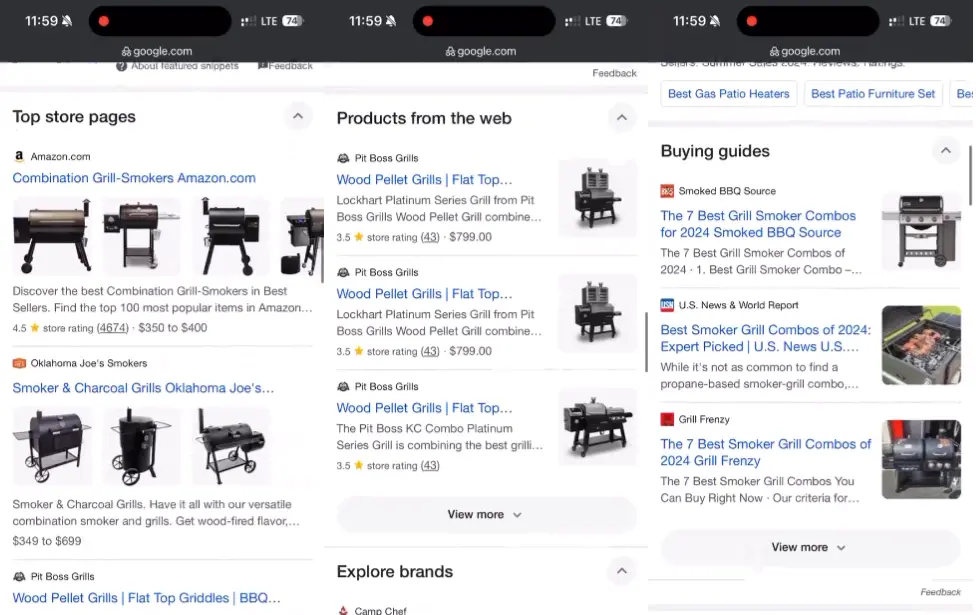

3. Lastmod w pliku sitemap jest traktowany zerojedynkowo

Znacznik

Gary Illyes z Google zdradził, że wyszukiwarka traktuje

Co z tego wynika? Przede wszystkim, że używanie

O tym, że

4. Zmiany w crawlerach Apple

10 czerwca 2024 miała miejsce konferencja Apple: WWDC 2024, na której firma ogłosiła między innymi integrację asystenta Siri z ChatemGPT i AI, które rozwinięte zostało jako „Apple Intelligence”.

O tych nowościach nie będę się jednak rozpisywał, bo nie mają one za wiele wspólnego z SEO. Skupię się za to na tym, co stało się później – czyli na zmianach, które Apple wprowadziło w dokumentacji Applebota dzień po ogłoszeniu nowości na konferencji.

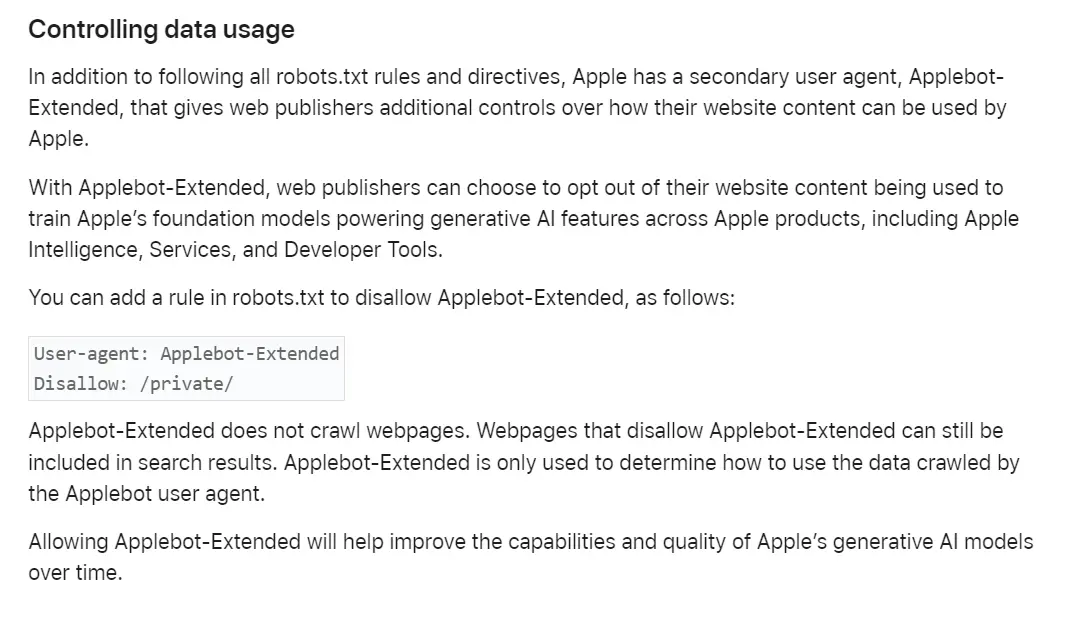

Największą nowością jest tutaj Applebot-Extended, który działa podobnie do crawlera Google-Extended (SEO News #103).

W skrócie: zablokowanie go w pliku robots.txt pozwala na wyłączenie treści z używania jej do szkolenia modeli AI Apple.

Jak zablokować Applebot-Extended w pliku robots? Firma podaje następujący przykład:

User-agent: Applebot-Extended

Disallow: /private/

Pełną dokumentację Applebota, wraz z informacjami dot. kontroli wykorzystywania danych przez firmę, znajdziesz na stronie pomocy Apple.

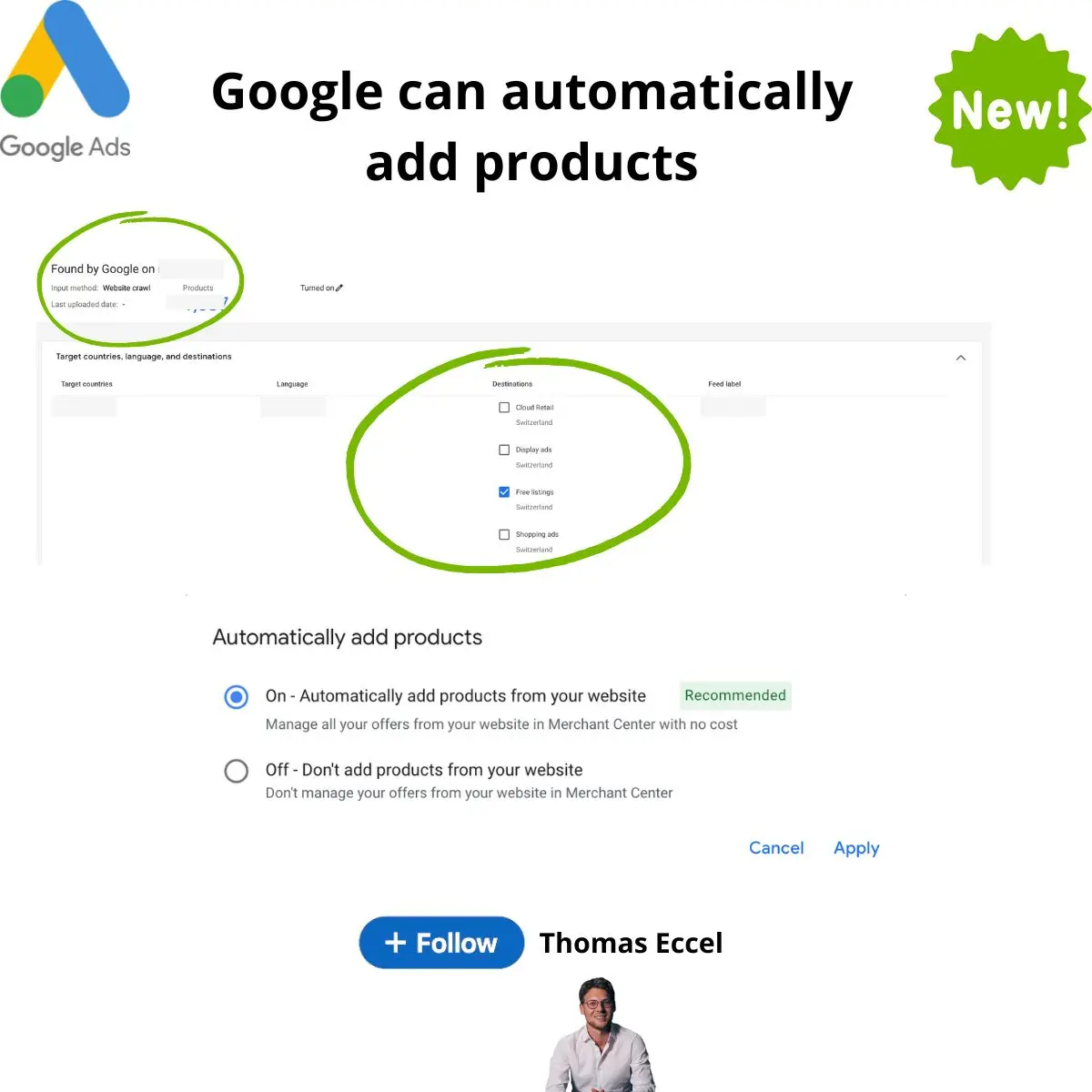

5. Automatyczne pobieranie produktów ze sklepów do Merchant Center

Google, najprawdopodobniej, rozwiązało na dobre problem aktualizacji produktów w Google Merchant Center. Od 22 czerwca narzędzie będzie automatycznie pobierać produkty ze sklepów przy użyciu swojego crawlera.

Żeby to działało, trzeba mieć aktywne konto z dodanymi produktami oraz uzupełnione w sklepie dane strukturalne dla produktów.

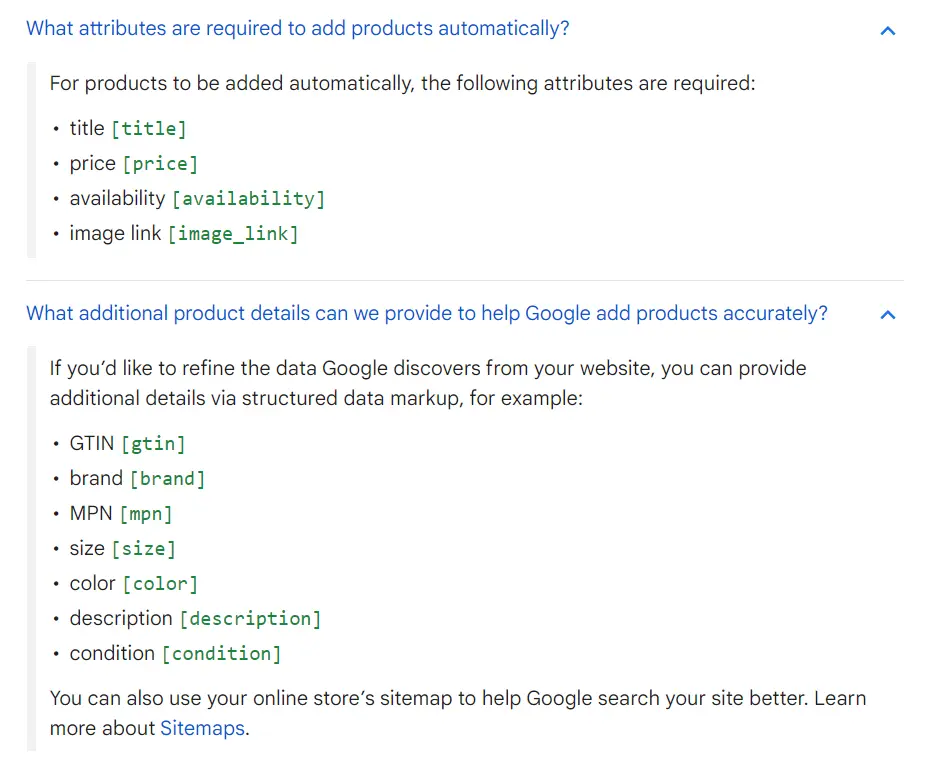

Konkretnie, wymagane są:

- tytuł [title],

- cena [price],

- dostępność [availability],

- zdjęcie produktu [image_link].

Google może też jednak pobierać automatycznie ze stron dodatkowe informacje, takie jak GTIN, marka, kolor czy opis produktu.

Dzięki nowej funkcji Google będzie automatycznie odzwierciedlać wszystkie zmiany w zakresie produktów na sklepie w Merchant Center. Chodzi zarówno o dodawanie nowych produktów, jak i usuwanie tych wycofanych, zmiany cen czy modyfikacje innych elementów.

Nowa funkcja będzie dostępna w Google Merchant Center Next.

Więcej szczegółów znajdziesz w jej dokumentacji: Używanie automatycznych plików danych do tworzenia danych produktów.

6. Google: błędy AI nie zatrzymają progresu

Jak donosi CNBC, na ostatnim spotkaniu ogólnym Google, Liz Reid (Head of Google Search) odniosła się do błędów w AI Overviews (SEO News #138) i stwierdziła, że problemy tego typu nie mogą powstrzymać Google przed publikowaniem nowych funkcji.

Reid miała podobno mówić między innymi o tym, że „dla Google ważne jest teraz, by nie wstrzymywać funkcji tylko dlatego, że mogą być z nimi okazjonalne problemy”.

Head of Google Search mówiła też, że z problemów z AI Overviews firma nie może wyjść z przeświadczeniem, że nie powinno się podejmować ryzyka. Wręcz przeciwnie, powinna, ale rozważnie i z jednoczesnym „pilnym działaniem” w razie błędów.

Ogólny przekaz był taki: musimy (w Google) jeszcze bardziej dbać o bezpieczeństwo, zgłaszać absolutnie wszystkie problemy i błędy i dalej niezmiennie iść na przód.

Jeśli zastanawiałeś/aś się więc, czy w obliczu ostatnich problemów i nieprawidłowych wyników AI Overviews zostanie na razie wstrzymane, to masz już odpowiedź. Google nie zamierza się zatrzymywać.

7. Google: czasem trzeba zabronić robotom śledzenia linków wewnętrznych

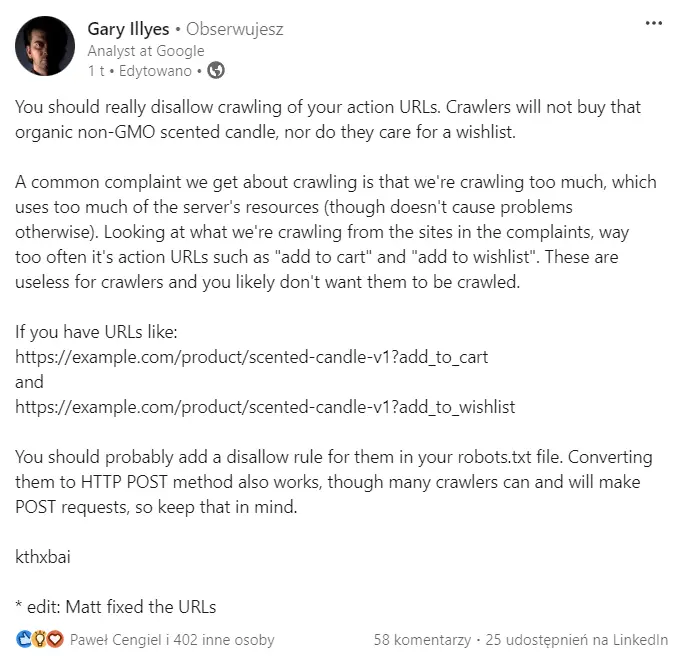

Podobno jedną z częstych skarg otrzymywanych przez Google jest skarga na to, że wyszukiwarka odwiedza stronę zbyt często, co zużywa za dużo zasobów serwera.

Jeśli masz taki problem, to Gary Illyes ma dla Ciebie rozwiązanie.

Jak napisał na LinkedIn’ie: z analizy stron, które się na to skarżą, wynika, że najczęściej problemem w takich przypadkach są URL-e „akcji” w stylu „dodaj do koszyka” czy „kup teraz”.

Linki do nich, np. z przycisków pod produktami, są śledzone przez roboty np. ze wszystkich podstron produktów, a to generuje ogromny ruch. W dodatku, absolutnie bezużyteczny, bo ani Google, ani sklep nie chce crawlowania takich adresów.

Rozwiązanie jest proste: jeśli Googlebot za bardzo obciąża Twój serwis, a masz w nim adresy z parametrem w stylu /produkt?add_to_cart, to najlepiej będzie po prostu zablokować je przed Googlebotem w pliku robots.txt.

W końcu, robot wyszukiwarki i tak niczego przecież nie kupi :).

8. Strony stworzone w GMF zostały wyłączone

Zgodnie z zapowiedzią (SEO News #117), od 10 czerwca wszystkie strony internetowe stworzone poprzez wycofany już kreator Google Moja Firma (kończące się na „.business.site” zwracają błąd 404.)

Zostały one usunięte już 1 marca 2024, ale teraz przestały działać także ich przekierowania (prowadzące do profili w Google Maps).

Google automatycznie usunęło wszystkie strony tego typu z profili Google Moja Firma.

Jeśli miałeś/aś taką stronę i jakimś cudem ominęły Cię wszystkie ostrzeżenia związane z tymi zmianami, to przykro mi, ale teraz musisz stworzyć sobie nową, kompletnie od zera.

Więcej informacji na tej stronie pomocy.